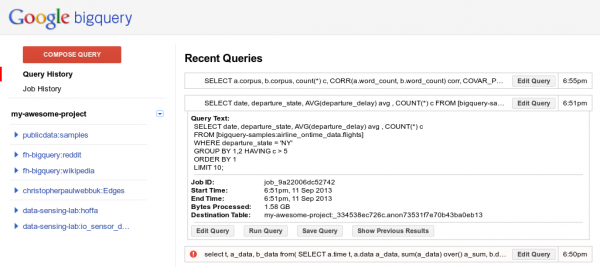

Ya conocemos al servicio BigQuery de Google, que permite a las empresas el análisis de grandes volúmenes de datos usando la propia infraestructura de Google. Pues bien, hoy nos trae una serie de novedades, comenzando por su nueva capacidad de cargar y analizar los datos en tiempo real gracias a una simple llamada a la API. La idea consiste en introducir los datos conforme se vayan disponiendo, en lugar de crear lotes de datos para su carga.

Los nuevos datos estarán disponibles para realizar consultas de forma instantánea, siendo esta nueva característica ideal para aquellos casos de uso de tiempo sensibles, como los análisis de registros y la generación de alertas, apunta Google en su propio anuncio. Esta nueva capacidad es gratis hasta el 1 de Enero de 2014, facturando después una tarifa de 1 centavo por cada 10.000 filas incluidas.

Otra de las novedades es la posibilidad de realizar consultas en un rango de tiempo en las últimas 24 horas, de manera que en lugar de realizar una exploración de columna completa al consultar los datos, ahora permite centrarse sólo en un subconjunto específico de los datos más recientes. Esto originaría menores costes de consultas, permitiendo a modo de ejemplo la consulta de datos de la última hora o la consulta de los datos disponibles antes de esa hora.

También se incluyen nuevas ventanas y nuevas funciones estadísticas, así como una nueva herramienta para el navegador que permite ver las consultas anteriores.

Google informa a través del blog de la plataforma en la nube que va a reforzar la seguridad en su servicio Google Cloud Storage, del lado del servidor, de manera que desde ahora, cifrará todos los datos antes de ser escritos en los discos duros, de manera que todos los datos que se vayan subiendo desde ahora, ya serán automáticamente cifrados.

Google informa a través del blog de la plataforma en la nube que va a reforzar la seguridad en su servicio Google Cloud Storage, del lado del servidor, de manera que desde ahora, cifrará todos los datos antes de ser escritos en los discos duros, de manera que todos los datos que se vayan subiendo desde ahora, ya serán automáticamente cifrados.