Y si ayer os hablé de VLOGGER, hoy os hablo de MELON, otro proyecto que llega desde Google Research con el objetivo de recrear objetos tridimensionales a partir de fotografías bidimensionales.

No se trata de una tarea sencilla, sobre todo cuando las posiciones desde las que se tomaron las imágenes no son conocidas, por lo que la parte técnica del proyecto es realmente amplia y compleja.

Hablamos de un proyecto que tiene aplicaciones prácticas en numerosos campos, desde el comercio electrónico hasta la navegación de vehículos autónomos. Los desarrolladores de aplicaciones de realidad aumentada pueden utilizar esta técnica para crear modelos 3D precisos a partir de simples fotografías. Esto podría mejorar la experiencia del usuario al interactuar con objetos virtuales que se integran de manera más realista en el entorno real. Por otro lado, en el sector del comercio electrónico, la capacidad de generar rápidamente modelos 3D de productos a partir de imágenes 2D simplificaría la visualización de productos en línea, ofreciendo una experiencia de compra más inmersiva y detallada.

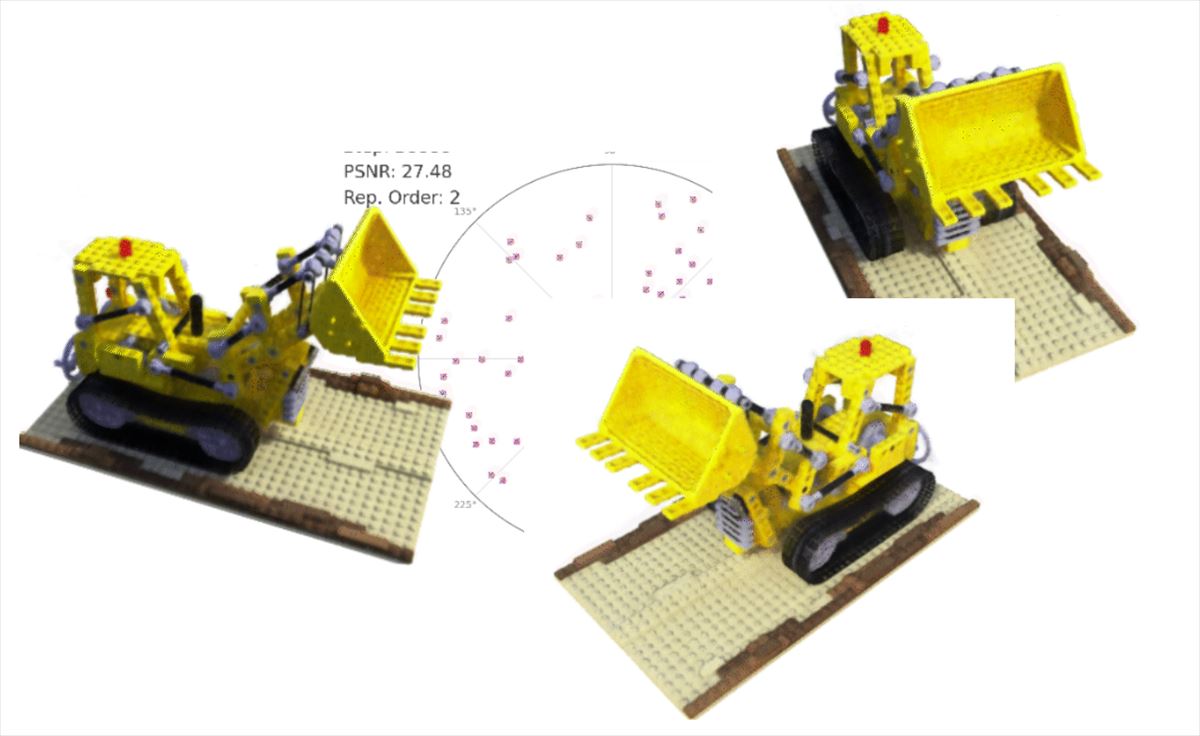

El potencial de MELON radica en su habilidad para inferir la posición de la cámara (pose) que tomó una serie de imágenes sin necesidad de información previa. Esto es particularmente valioso en situaciones donde las poses de las cámaras no se registran o son difíciles de estimar, como en imágenes antiguas o en fotografías tomadas por usuarios en plataformas de venta en línea.

Uno de los aspectos más intrigantes de MELON es su capacidad para trabajar incluso con imágenes de baja calidad o con alto nivel de ruido. Esto significa que podría ser extremadamente útil en escenarios de baja visibilidad, como en investigaciones subacuáticas o en la exploración espacial, donde las condiciones de iluminación no son ideales y las imágenes suelen ser granuladas o borrosas.

¿Cómo funciona MELON?

Si querer entrar en detalles muy técnicos, que tenéis en blog.research.google, MELON combina una red neuronal convolucional (CNN) para lograr una precisa reconstrucción 3D. Este método no requiere de un extenso conjunto de datos preetiquetados para el entrenamiento, por lo que se puede integrar fácilmente en aplicaciones existentes. También usa una forma inteligente de manejar las fotos que se parecen mucho entre sí, como ver la misma silla desde ángulos ligeramente diferentes. Este método ayuda a la CNN a no confundirse con estas similitudes y a tomar decisiones más precisas sobre la pose de la cámara.

MELON no solo hace posible que una computadora «vea» en 3D a partir de imágenes 2D; también lo hace con una eficiencia sorprendente, necesitando tan solo 4-6 imágenes para entender completamente un objeto.

Desde ayudar a diseñadores y arquitectos a visualizar sus creaciones de manera más intuitiva hasta permitir a historiadores reconstruir artefactos antiguos con una precisión sin precedentes, MELON puede ser una verdadera revolución. Lástima de nombre, será difícil competir en el mundo SEO con esas siglas.