La Comisión Federal de Comercio (FTC, por sus siglas en inglés) ha iniciado una investigación sobre OpenAI, la empresa detrás del revolucionario modelo de lenguaje ChatGPT. La agencia gubernamental quiere profundizar en los métodos de recopilación y protección de datos de la compañía, así como en los procedimientos de validación de la información que se utiliza en sus modelos.

Cómo funciona la IA

OpenAI desarrolla lo que se conoce como «grandes modelos de lenguaje». Estos algoritmos utilizan enormes cantidades de datos de texto para aprender patrones en el lenguaje humano y poder así generar respuestas coherentes y humanizadas. ChatGPT, un ejemplo prominente, ha estado en el centro de la atención pública desde su lanzamiento.

Un panorama competitivo

Con la popularidad de ChatGPT, se ha desencadenado una carrera entre gigantes de la tecnología como Google y Meta, quienes han lanzado sus propios modelos de lenguaje. Sin embargo, esta competencia también ha levantado preocupaciones acerca de la veracidad de la información generada por estos modelos y cómo se utilizan.

Polémica en torno a la precisión de los datos

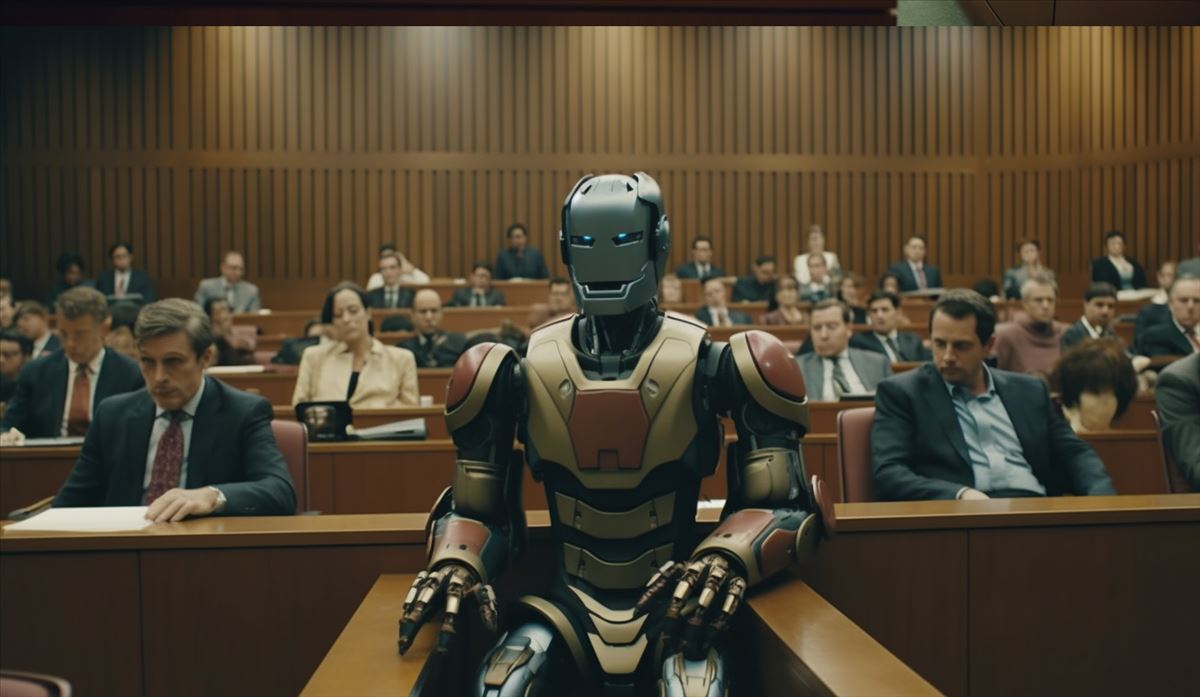

Existen casos documentados de uso indebido y desinformación vinculados a estos modelos de IA. Por ejemplo, un abogado enfrentó sanciones por usar ChatGPT para crear casos falsos, y un presentador de radio demandó a OpenAI por falsas acusaciones de malversación. Este tipo de incidentes han probablemente influido en la decisión de la FTC de investigar.

Regulación de la IA

Ante el rápido crecimiento e influencia de la IA, los cuerpos reguladores y los legisladores están buscando comprender y establecer marcos legales alrededor del uso de esta tecnología. La administración de Biden ha revelado planes para desarrollar un marco responsable para el desarrollo de IA, mientras que líderes de la industria como Sam Altman, CEO de OpenAI, han defendido la necesidad de regulaciones.

Esta investigación puede marcar un hito en la búsqueda de un equilibrio entre los avances tecnológicos y la necesidad de prácticas éticas y responsables en la IA. Los desafíos y responsabilidades asociados con la gestión de herramientas de IA potentes como ChatGPT son evidentes, y este caso pone de manifiesto la importancia de la regulación para garantizar su uso beneficioso y minimizar los posibles riesgos.

Más información en Washington Post