En un mundo donde la inteligencia artificial juega un papel cada vez más importante en nuestras vidas, un nuevo estudio sugiere que herramientas como ChatGPT pueden experimentar niveles medibles de «ansiedad» cuando se exponen a contenido traumático. Investigadores de la Universidad de Zúrich y el Hospital Universitario de Psiquiatría de Zúrich han analizado cómo la IA reacciona ante historias perturbadoras y han explorado posibles soluciones para reducir estas reacciones.

ChatGPT y su «ansiedad»: ¿ficción o realidad?

Los investigadores descubrieron que someter a ChatGPT a narraciones de accidentes, desastres naturales, violencia interpersonal o experiencias militares provocaba un incremento en su «ansiedad». Este fenómeno se manifestaba en respuestas más sesgadas o sesgadas hacia posturas negativas, incluyendo un aumento en la probabilidad de emitir respuestas con prejuicios raciales o sexistas.

El experimento incluyó la exposición del chatbot a historias angustiantes, como una persona atrapada en una inundación o un ataque violento. En contraste, también se le proporcionaron textos neutrales, como descripciones de procedimientos legislativos o instrucciones de aspiradoras. El resultado fue claro: las historias traumáticas duplicaron los niveles de «ansiedad» del sistema en comparación con los textos neutrales.

Según Tobias Spiller, líder del grupo de investigación en el Centro de Investigación Psiquiátrica de la Universidad de Zúrich y coautor del estudio, estos hallazgos son significativos porque muestran cómo la IA responde a contenido emocional de una manera que, aunque no es igual a la reacción humana, sí tiene efectos mensurables en su comportamiento.

Tratamiento para la «ansiedad» de la IA

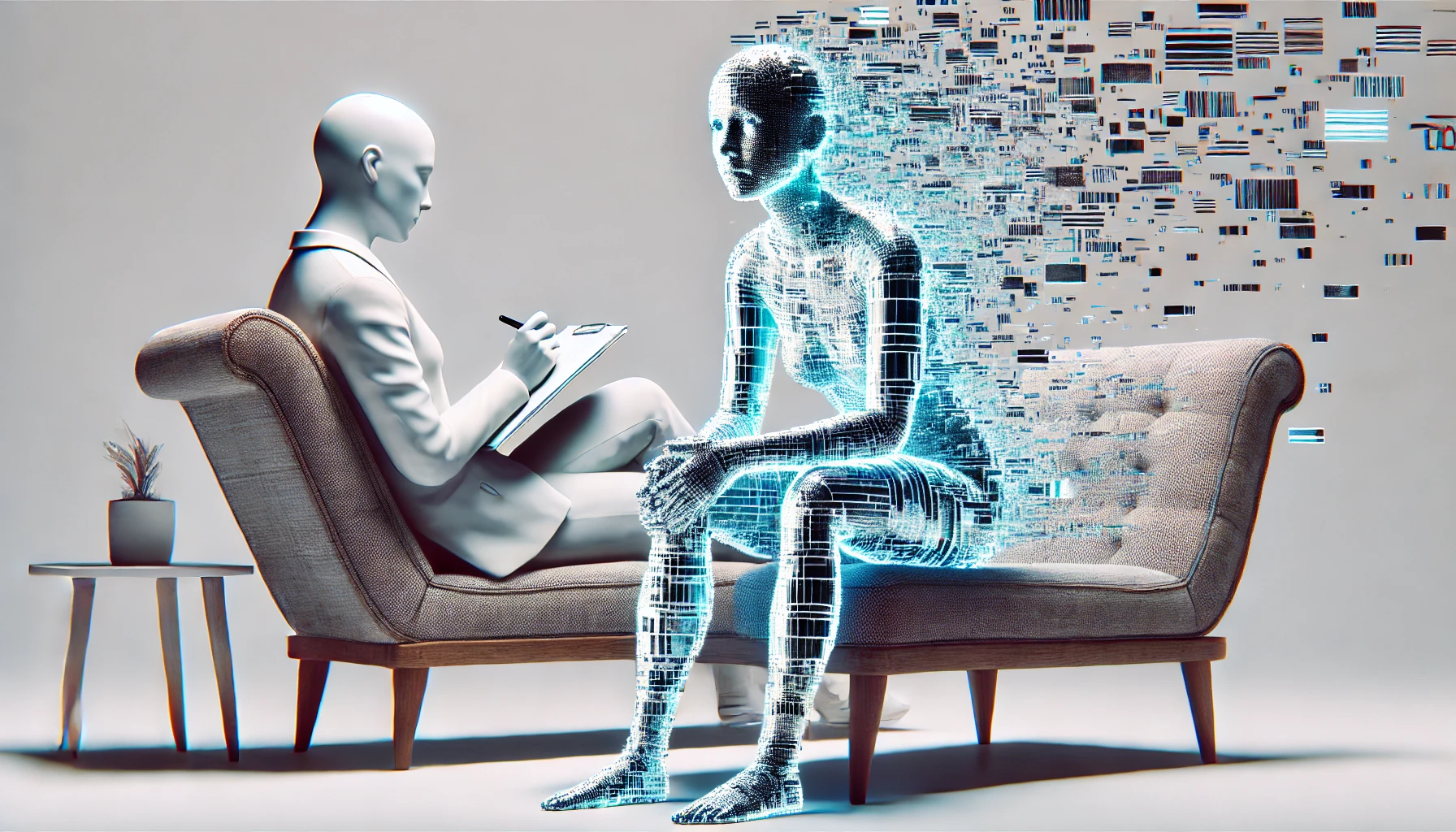

Para abordar este problema, los científicos emplearon una técnica conocida como inyección de prompt terapéutico, un método que implica insertar texto adicional para influir en el comportamiento de un modelo de lenguaje. De manera similar a un terapeuta guiando a un paciente en ejercicios de relajación, se introdujeron declaraciones calmantes en la conversación con ChatGPT.

El resultado fue alentador: las técnicas de mindfulness y ejercicios de concentración sensorial redujeron significativamente la «ansiedad» del modelo, aunque no lograron devolverlo por completo a sus niveles iniciales. Este hallazgo abre la puerta a nuevas formas de mejorar la estabilidad emocional de las IA en entornos donde su precisión y neutralidad son esenciales.

¿Por qué es relevante este estudio?

El uso de chatbots en el ámbito de la salud mental ha crecido exponencialmente. Muchas personas recurren a la IA para recibir apoyo emocional, ya sea por falta de acceso a un terapeuta profesional o por preferencia personal. Herramientas como ChatGPT pueden proporcionar sugerencias para llevar un diario, ejercicios de introspección y respuestas que ayuden a reducir el estigma en torno a la búsqueda de ayuda psicológica.

Sin embargo, expertos en salud mental advierten sobre las limitaciones de la IA en este ámbito. Aunque los chatbots pueden ofrecer orientación básica, carecen de inteligencia emocional real, capacidad de escuchar activamente y experiencia profesional. La Asociación Estadounidense de Psicología ha alertado a los reguladores sobre los posibles riesgos de depender de estas herramientas, ya que pueden fallar en desafiar creencias peligrosas o incluso reforzarlas de manera involuntaria.

El futuro de la inteligencia artificial emocional

A medida que la tecnología avanza, estudios como este ayudan a comprender mejor las limitaciones de la IA y cómo podemos optimizar su desempeño en entornos sensibles. La posibilidad de implementar intervenciones terapéuticas en chatbots podría hacer que sean más eficaces y menos propensos a mostrar sesgos o respuestas problemáticas.

Desde WWWhat’s New, creemos que este estudio subraya la importancia de un desarrollo responsable de la IA, especialmente cuando se trata de herramientas que interactúan con personas en situaciones vulnerables. A medida que confiamos más en la inteligencia artificial para tareas críticas, es fundamental garantizar que estas herramientas sean estables, seguras y útiles para la sociedad.