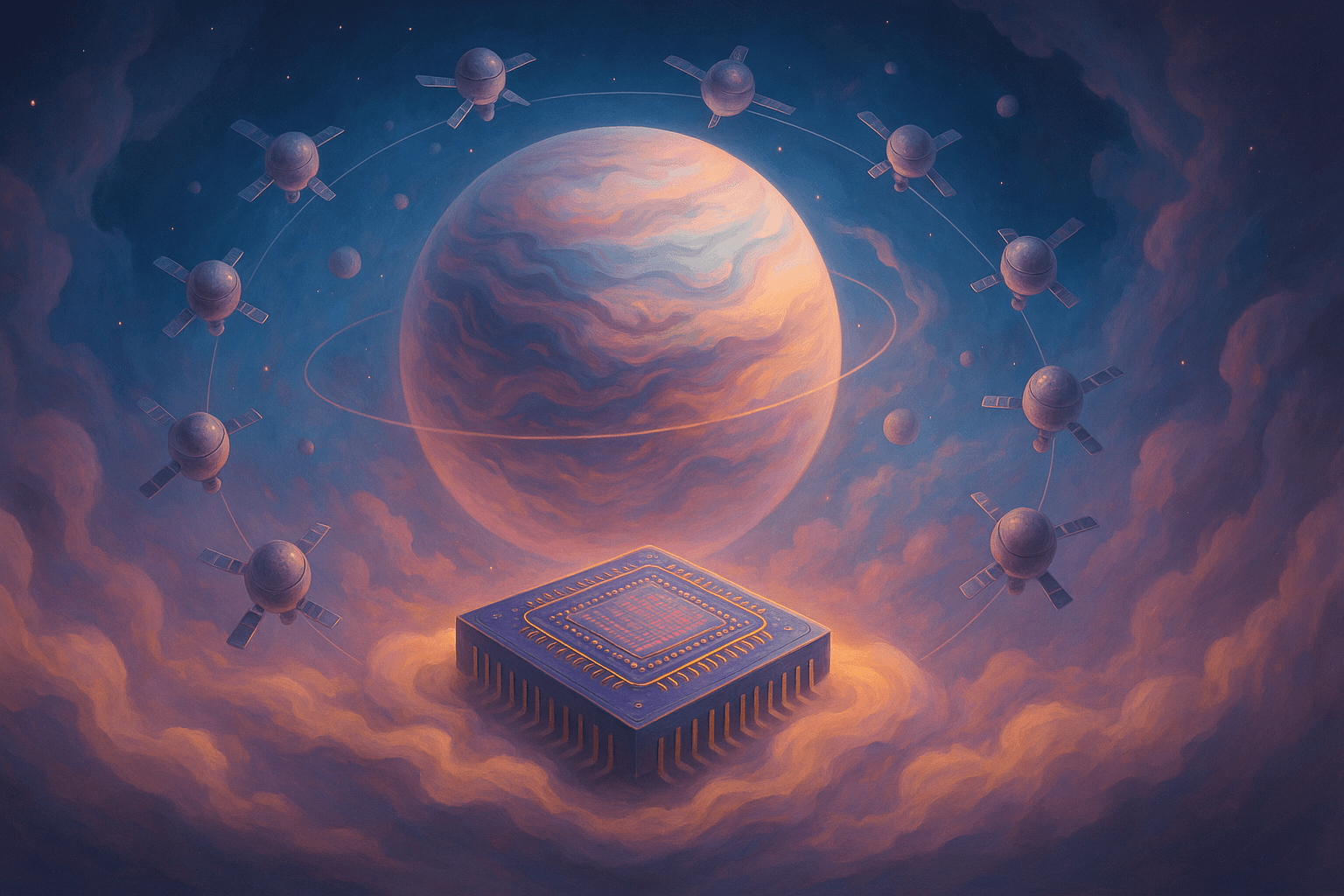

China ha dado un paso gigantesco en el desarrollo de infraestructura tecnológica espacial al lanzar los primeros 12 satélites de una red que promete convertirse en una supercomputadora basada en el espacio. Este sistema, bautizado como la constelación Three-Body Computing, aspira a desplegar un total de 2.800 satélites con capacidad para realizar hasta 1.000 peta operaciones por segundo (POPS). En pocas palabras, una velocidad de cálculo astronómica, nunca mejor dicho.

¿Qué hace especial a esta constelación?

Cada uno de los 12 satélites lanzados incorpora un modelo de inteligencia artificial de 8.000 millones de parámetros, lo que les permite procesar datos a una velocidad de 744 tera operaciones por segundo (TOPS). En conjunto, los satélites ya en órbita pueden alcanzar un rendimiento de 5 POPS, una capacidad considerable para ser apenas la fase inicial del proyecto.

Pero más allá de la potencia, lo interesante es dónde y cómo se realiza este procesamiento: en el espacio. En lugar de recolectar datos y enviarlos de vuelta a la Tierra —como hacen los satélites tradicionales—, este sistema permite el análisis en tiempo real desde la órbita, aprovechando la energía solar y el frío del vacío espacial como sistema de enfriamiento natural. Es como tener un centro de datos solar refrigerado al estilo criogénico, orbitando a cientos de kilómetros de altura.

Ventajas de procesar en el espacio

Hoy en día, los satélites se comportan como cámaras de vigilancia que graban todo, pero deben enviar sus vídeos a una oficina central para que alguien los revise. Esto implica cuellos de botella en la transmisión de datos y pérdidas de información. El enfoque chino busca evitar este paso, reduciendo la carga en las redes terrestres, acelerando los tiempos de respuesta y minimizando el consumo energético asociado a la refrigeración.

Gracias al uso de enlaces láser de alta velocidad —capaces de transmitir datos a 100 Gbps entre satélites—, estos módulos pueden colaborar como si fueran nodos interconectados de un gran servidor flotante. Esto no solo hace más eficiente el análisis, sino que también crea un modelo escalable que podría extenderse sin los límites físicos de los centros de datos terrestres.

¿Quiénes están detrás del proyecto?

El desarrollo corre a cargo de la empresa tecnológica ADA Space en colaboración con el centro de investigación Zhejiang Lab. Ambos actores tienen la mirada puesta no solo en el avance técnico, sino también en la apertura internacional del proyecto. Según Wang Jian, portavoz de Zhejiang Lab, esta plataforma estará disponible para otros países y organizaciones interesadas en usar o mejorar la infraestructura.

Comparaciones con iniciativas internacionales

Estados Unidos y Europa ya han realizado pruebas con supercomputación espacial, pero ningún país había llevado la tecnología al punto de desplegar un sistema funcional y escalable en órbita. El único intento comparable es la propuesta de Eric Schmidt, ex CEO de Google, quien tiene planes para colocar centros de datos en el espacio tras adquirir una participación en la empresa aeroespacial Relativity Space. Sin embargo, sus propuestas aún están en etapa conceptual.

Un cambio de paradigma en la computación global

Al igual que cuando se trasladó el almacenamiento de datos a la nube para evitar depender de dispositivos físicos, ahora estamos viendo los primeros pasos hacia una computación exaespacial. Esto significa mover el núcleo de procesamiento fuera del planeta, con todas las ventajas y desafíos que esto implica: desde la dependencia de lanzamientos espaciales hasta la protección frente a radiación cósmica y basura orbital.

Además, la constelación podría jugar un papel fundamental en tareas como la predicción climática global, el análisis de recursos naturales y la vigilancia ambiental, con una capacidad de procesamiento y autonomía sin precedentes.

Participación internacional y posibles aplicaciones

ADA Space ha expresado su intención de colaborar con entidades extranjeras, tanto públicas como privadas. Esto podría abrir las puertas a una nueva dinámica de cooperación espacial más allá de los grandes organismos como la NASA o la ESA. Las universidades, startups y gobiernos con presupuestos más modestos podrían tener acceso a un sistema de computación avanzada sin necesidad de montar sus propias infraestructuras.

Imaginemos, por ejemplo, un país que quiera analizar el crecimiento de cultivos mediante imágenes satelitales. En lugar de descargar terabytes de imágenes y procesarlos localmente, podría hacerlo directamente desde la red orbital, reduciendo tiempo y costos. O una empresa de logística que quiera optimizar rutas en tiempo real basándose en datos globales de tráfico y meteorología.

¿Qué podemos esperar a futuro?

Si el despliegue continúa como está planeado, el sistema completo de 2.800 satélites podría estar operativo en la próxima década, lo que redefiniría los límites del edge computing tal como lo conocemos. En vez de llevar el procesamiento lo más cerca posible del usuario en la Tierra, lo estaremos llevando directamente al cosmos.

Y con ello, se abren nuevas preguntas: ¿Quién controlará el acceso a estos recursos? ¿Qué normativas regirán esta nueva infraestructura? ¿Podrían surgir conflictos sobre el uso del espacio para fines tecnológicos?

Por ahora, China ha dado un golpe de efecto que pone sobre la mesa una realidad: el futuro de la inteligencia artificial también se está escribiendo más allá de la atmósfera.