Hoy he conocido el programa EMO (Emote Portrait Alive), desarrollado por un equipo de investigadores de Alibaba Group, y que representa un avance significativo en la producción de vídeos a partir de imágenes y sonido. Utilizando una técnica conocida como Audio2Video Diffusion, EMO es capaz de generar animaciones realistas que capturan expresiones faciales y movimientos de cabeza con una precisión asombrosa.

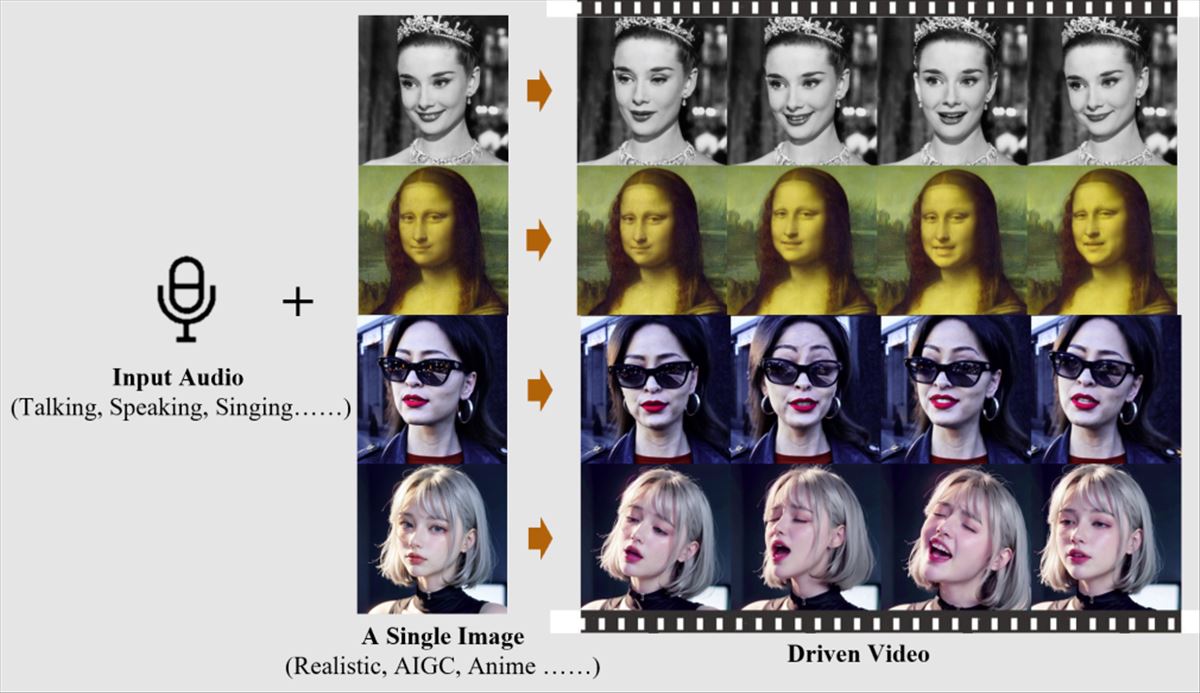

La propuesta de EMO es sencilla pero impactante. Utiliza una imagen de referencia y un archivo de audio vocal —ya sea habla o canto— para crear vídeos de avatares que no solo expresan emociones y gestos sincronizados con el audio sino que también mantienen la identidad y los rasgos del personaje original. La clave aquí es la personalización y la capacidad de generar contenido que resuene de forma más auténtica y personalizada con los usuarios.

Imagina poder ver a Audrey Hepburn o a Joaquin Phoenix en nuevas escenas, sin que haya sido necesario su presencia en un set de filmación. Lo que me parece más fascinante es que esta tecnología no se apoya en los métodos tradicionales que requieren modelos 3D o puntos de referencia faciales, sino que realiza una síntesis directa de audio a vídeo. Mirad el ejemplo con Audrey Hepburn (tenéis más ejemplos en los enlaces de abajo):

El proceso se divide en dos etapas principales: la codificación de marcos y el proceso de difusión. En la primera, una red llamada ReferenceNet extrae las características de la imagen de referencia y los marcos de movimiento. Luego, durante la etapa de difusión, un codificador de audio preentrenado procesa el audio, y mediante una combinación de máscaras faciales y ruido, se genera la base del vídeo, que luego se refina para capturar las sutilezas de la expresión y el movimiento.

Otro aspecto notable es la capacidad de EMO para trabajar con audio en diversos idiomas, permitiendo que los personajes entreguen actuaciones en una amplia gama de estilos lingüísticos y culturales. Imagina poder escuchar a la Mona Lisa recitar un monólogo de Shakespeare… Las implicaciones para la globalización del contenido digital son enormes.

Al observar los resultados de EMO, uno no puede evitar maravillarse ante la coherencia y realismo de las animaciones. La capacidad de mantener la identidad y expresividad a lo largo de los fotogramas es algo que, sin duda, captará la atención de la industria cinematográfica. Sin embargo, no todo es color de rosa. Este tipo de tecnologías plantea importantes cuestiones éticas y legales, especialmente en lo referente a los derechos de imagen y la autenticidad del contenido.

Desde mi perspectiva, el impacto de EMO se extiende más allá del cine y la televisión. Podemos anticipar su uso en la educación, la publicidad y hasta en la recreación de eventos históricos. Pero, como siempre, la clave estará en el uso responsable y consciente de la tecnología.

EMO se presenta como una revolución en el universo de la inteligencia artificial. Representa una ventana a nuevas formas de expresión y creatividad, un puente hacia historias que nunca fueron contadas y la reinvención de las ya conocidas. Aunque el futuro es incierto, estoy entusiasmado por ver cómo evolucionará esta tecnología y el impacto que tendrá en nuestra forma de consumir y crear contenido audiovisual.

Referencias

- EMO: Emote Portrait Alive – Generating Expressive Portrait Videos with Audio2Video Diffusion Model under Weak Conditions – arxiv.org

- Ejemplos de más vídeos en humanaigc.github.io