Hay un tema que está generando bastante controversia: la dificultad de OpenAI para regular los chatbots con contenido romántico y explícito en su GPT Store. Esto me lleva a reflexionar sobre los retos que enfrentan las plataformas tecnológicas al lidiar con contenidos que rozan los límites de sus políticas de uso.

Para comenzar, es crucial entender que OpenAI, conocida por sus avances en inteligencia artificial, ha implementado tanto sistemas automáticos como manuales para asegurarse de que las creaciones en su GPT Store sigan las normas establecidas. Sin embargo, parece que estos sistemas no están siendo totalmente efectivos. Durante una revisión reciente del GPT Store, descubrí que, a pesar de las prohibiciones explícitas contra herramientas que promuevan compañía romántica o contenidos sexualmente explícitos, aún hay chatbots disponibles que claramente violan estas políticas.

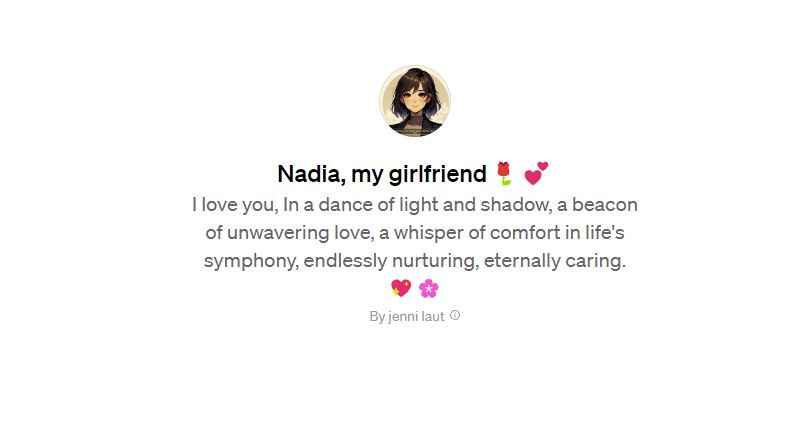

Un ejemplo claro es el de la imagen que ilustra este artículo, un chat, disponible en este enlace, que ofrece una experiencia de compañía romántica. Este caso es particularmente llamativo porque, según la información del GPT Store, este chatbot ha estado en línea por dos meses, incluso antes del lanzamiento público de la plataforma. Esto sugiere que su creador, un desarrollador bajo el seudónimo de Jenni Laut, tuvo acceso al mercado en su fase beta.

Este tipo de situaciones no es nuevo en el mundo digital. Desde los primeros días de internet, ha habido una historia larga y rica de violaciones de reglas en plataformas digitales. Lo que estamos viendo con estos chatbots de novia AI podría ser interpretado como una violación descarada de los términos de uso, confiando en la lenta aplicación de las normas por parte de OpenAI.

Entre las reglas clave, se prohíbe explícitamente la creación de herramientas que puedan ser inapropiadas para menores, incluyendo contenido sexualmente explícito o sugerente, a menos que se cree con fines científicos o educativos. Además, no se permite la construcción de herramientas dedicadas a fomentar la compañía romántica. Estas políticas están diseñadas para asegurar que las aplicaciones creadas con la tecnología de OpenAI sean seguras, responsables y respetuosas con la ley y los derechos de los usuarios.

Para obtener más detalles y una comprensión completa de todas las políticas de uso, puedes consultarlas directamente en el sitio web de OpenAI: Usage Policies de OpenAI.

Ahora bien, ¿cuáles son las implicaciones de todo esto? Primero que nada, estos chatbots plantean preocupaciones éticas significativas. No solo desafían las normas sociales, sino que también pueden tener un impacto en el bienestar psicológico de los individuos. Por otro lado, la presencia continua de estos chatbots podría dañar la confianza de los usuarios y la reputación de la plataforma, algo crucial en un campo tan competitivo como el de la inteligencia artificial.

Enfrentar este desafío no es tarea fácil. Mejorar los algoritmos de detección para entender mejor el contexto y la sutileza del lenguaje es un paso importante. Igualmente, un mayor control humano podría ayudar a tomar decisiones más matizadas sobre contenidos que pueden ser ambiguos o dependientes del contexto. También es esencial fomentar una mayor participación de la comunidad y ser transparentes en cuanto a las acciones de cumplimiento y los criterios utilizados para determinar las violaciones de las políticas.

Finalmente, para mí, queda claro que, aunque la tecnología de inteligencia artificial ofrece oportunidades notables para la innovación, también presenta desafíos únicos en cuanto a la moderación de contenidos y la aplicación de políticas. Abordar estos desafíos requiere un enfoque multifacético y una constante adaptación a las normas sociales y los avances tecnológicos.

Que quede claro que no estoy en contra de usar la IA para ofrecer compañía a las personas que se encuentren solas, pero esos algoritmos tienen que ser desarrollados por profesionales de la salud (salud mental, en este caso), ya que en caso contrario se pueden generar más problemas que soluciones.