En el dinámico mundo de la tecnología de inteligencia artificial (IA) no podemos olvidar nunca a Inflection AI. Fundada por Mustafa Suleyman de Google DeepMind y Reid Hoffman de LinkedIn, Inflection AI ha irrumpido ahora en el escenario con su innovador modelo Inflection-2. Este modelo no solo se destaca por su capacidad tecnológica avanzada, sino también por el respaldo significativo de inversionistas de renombre, habiendo recaudado $1.3 mil millones de empresas como Microsoft y Nvidia.

Inflection AI ha captado la atención del sector por su potencial competitivo y por su ambiciosa visión de crear IA personal para todos. Su producto estrella, el chatbot Pi, del que hemos hablado en varias ocasiones, utiliza tecnología de IA generativa para interactuar con los usuarios a través de diálogos, ofreciendo una experiencia de usuario novedosa y personalizada.

Orígenes de Inflection AI

Inflection AI representa un caso destacado de rápido éxito y reconocimiento en el ámbito de la tecnología de inteligencia artificial. Fundada en marzo de 2023 por Mustafa Suleyman y Reid Hoffman, esta empresa emergente no tardó en asegurar un financiamiento significativo. Apenas dos meses después de su lanzamiento, Inflection AI cerró una inversión de $225 millones. Posteriormente, en junio, logró recaudar adicionalmente $1.3 mil millones de inversores de alto perfil, incluyendo a Microsoft y Nvidia. Este apoyo financiero ha valorado a la compañía en unos impresionantes $4 mil millones.

Con sede en Palo Alto, California, Inflection AI ha sabido capitalizar el boom actual en el sector de la IA, atrayendo la atención y el capital de inversionistas importantes. Este respaldo financiero no solo refleja la confianza en la visión de la compañía, sino que también subraya la creciente importancia y el potencial percibido de la tecnología AI en el mundo actual.

Inflection-1: El Pionero Detrás de Pi

Antes del lanzamiento de Inflection-2, la primera gran innovación de Inflection AI fue su modelo Inflection-1 (sí, ya lo sé, un poco obvio). Este modelo, lanzado previamente, sentó las bases para la tecnología avanzada que la compañía ofrece hoy. Inflection-1 es notable por su capacidad para escribir y reescribir textos, resumir documentos, generar código y realizar tareas relacionadas, demostrando así la versatilidad y la potencia de las soluciones de IA de Inflection AI (hace lo que hace ChatGPT, pero de forma más educada, como si fuera un psicólogo).

Inflection-1 no solo es el núcleo detrás del chatbot Pi, sino que también ha establecido un alto estándar en la industria de la IA. El modelo fue alabado por su desempeño superior en comparación con la mayoría de los modelos disponibles en ese momento. Este éxito inicial de Inflection-1 proporcionó una base sólida para el desarrollo y el lanzamiento de su sucesor, Inflection-2, un modelo aún más avanzado y potente.

Inflection-2: Innovación y superioridad tecnológica

El modelo Inflection-2 de Inflection AI representa un salto significativo en la tecnología de inteligencia artificial. Este modelo es una mejora sobre su predecesor, claro, pero también establece nuevos estándares en el campo de los modelos de lenguaje. Según la compañía, Inflection-2 posee una base de conocimientos actualizada y una capacidad de razonamiento considerablemente mejorada. Estas características le permiten responder a consultas de usuarios con mayor precisión y ajustar el estilo del texto que genera de manera más detallada.

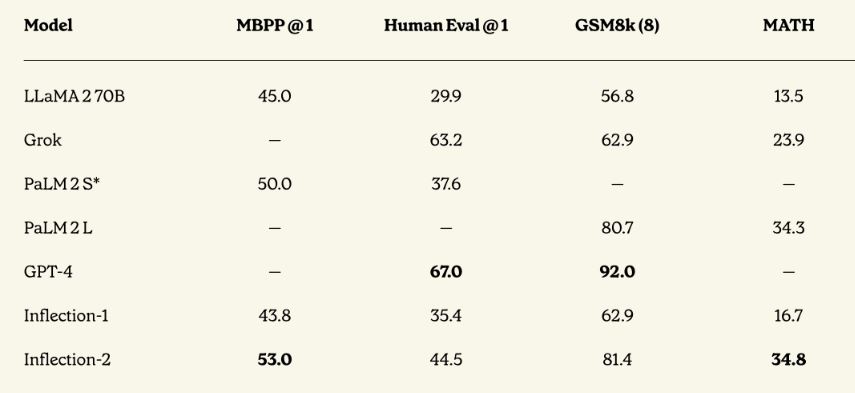

Uno de los aspectos más destacados de Inflection-2 es su rendimiento en comparación con otros modelos líderes de IA. En pruebas de referencia, Inflection-2 ha demostrado ser el modelo de lenguaje más capaz del mundo, solo superado por GPT-4 de OpenAI, tal y como veremos más abajo. Este logro es notable, especialmente considerando que Inflection-2 superó a modelos optimizados para la generación de código en ciertas pruebas, a pesar de que la codificación y el razonamiento matemático no eran el enfoque explícito durante su entrenamiento.

El entrenamiento de Inflection-2 involucró el uso de 5,000 unidades de procesamiento gráfico (GPU) H100 de Nvidia, destacando el compromiso de la empresa con la utilización de tecnología de punta. Estas GPUs permiten que el modelo realice tareas de inferencia (procesamiento de solicitudes de usuario) de manera más rápida y eficiente en términos de costos, a pesar de ser varias veces más grande que su predecesor.

Comparativa con GPT-4 y otros modelos

Inflection-2 se ha establecido como un competidor formidable en el ámbito de los modelos de lenguaje a gran escala (LLMs). Una característica clave de este modelo es su comparativa directa con otros modelos líderes, como el GPT-4 de OpenAI, PaLM-2 de Google, Claude-2, Llama-2 y Grok. Según las evaluaciones de Inflection AI, Inflection-2 ha demostrado ser el modelo más capaz en su clase de cómputo, solo superado por GPT-4, repito. La tabla de arriba (donde también aparece Grok, por cierto) la han publicado en analyticsindiamag.com.

Esta comparativa es significativa por varias razones. Primero, destaca la rápida evolución y la intensa competencia en el sector de la IA, donde nuevas empresas como Inflection AI pueden desafiar a gigantes establecidos. Además, subraya el importante papel que desempeñan las innovaciones tecnológicas en la mejora de la eficiencia y la efectividad de los modelos de IA.

La capacidad de Inflection-2 para superar a modelos optimizados en tareas específicas, como la generación de código, es un testimonio de su sofisticación y versatilidad. Aunque Inflection-2 no se centró explícitamente en la codificación y el razonamiento matemático durante su entrenamiento, su rendimiento en estas áreas indica un nivel avanzado de comprensión y adaptabilidad.

Referencias

- «Amid OpenAI Chaos, Rival Inflection AI Releases Model On GPT-4» – Forbes

- «Microsoft-backed AI startup Inflection raises $1.3 billion from Nvidia and others» – Reuters

- «Inflection AI debuts new flagship Inflection-2 LLM trained on 5,000 H100 chips» – SiliconANGLE