La compañía Runway, con base en Nueva York, ha lanzado una nueva actualización de su modelo generativo Gen-2 que ha captado la atención de la comunidad de cineastas de IA. Esta actualización trae consigo varias mejoras y nuevas funcionalidades que prometen cambiar la forma en que se crea contenido visual.

Una de las características más destacadas es la capacidad de crear videos nuevos mediante el uso de prompts de texto, lo que permite una generación de contenido más intuitiva y flexible. También se ha introducido una función para animar imágenes estáticas, agregándoles movimiento, lo que abre un abanico de posibilidades creativas.

En twitter han mostrado algunos de los resultados impresionantes de esta nueva versión.

En agosto, se permitió la extensión del tiempo de videos generados por IA hasta 18 segundos, y en septiembre, se introdujo el «Modo Director», que permite a los usuarios controlar la dirección y velocidad de los movimientos simulados de cámara, proporcionando un mayor control sobre el contenido generado.

La resolución de los videos generados ha sido mejorada, pasando de 1792×1024 a 2816×1536, lo que, junto con un movimiento más suave y realista, contribuye a una mejor experiencia visual.

Con la capacidad de generar producciones cortas de IA y la posibilidad de combinar imágenes generadas por IA de otras fuentes, los cineastas tienen ahora más herramientas para experimentar y crear contenido original.

Cómo usar Runaway

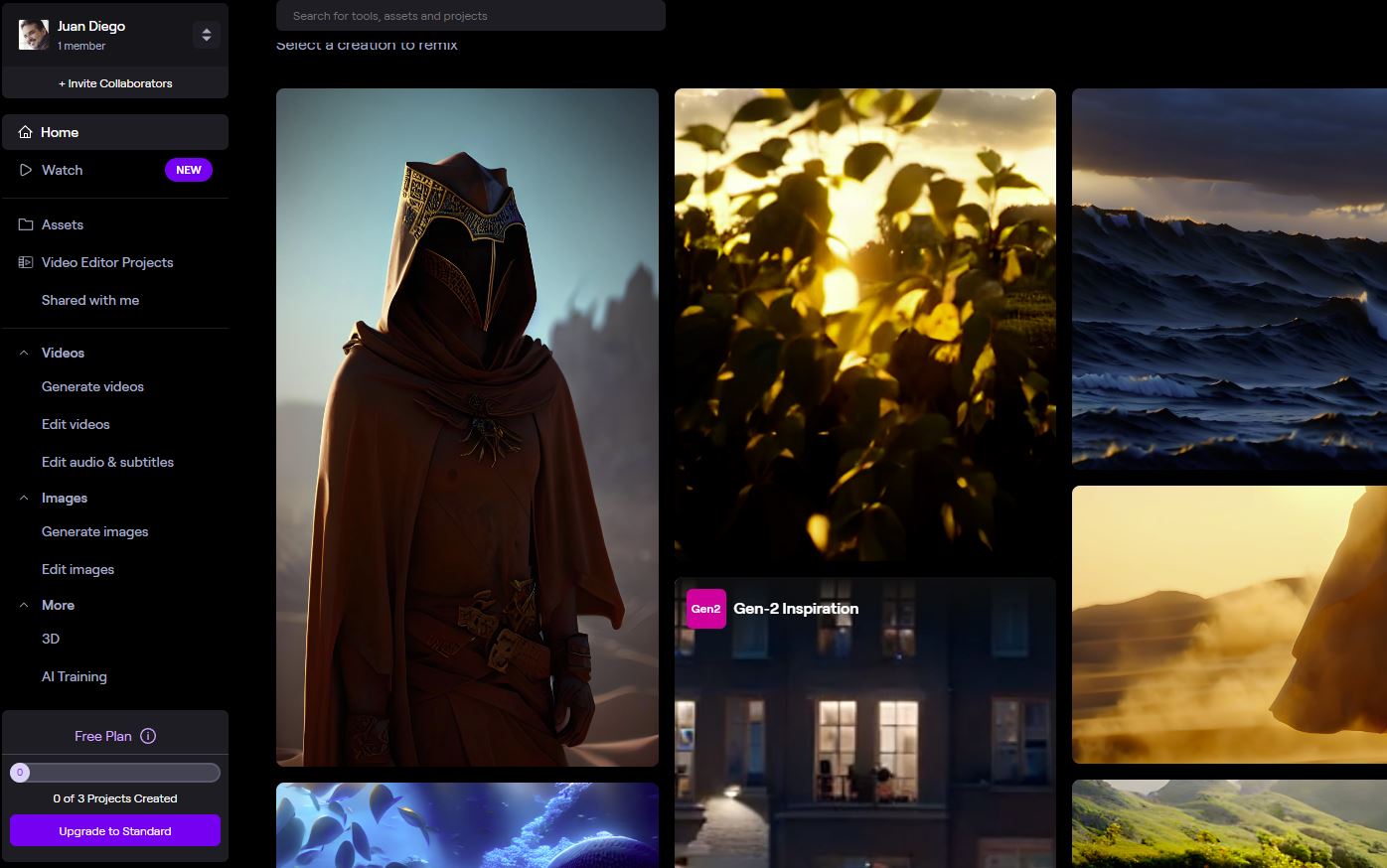

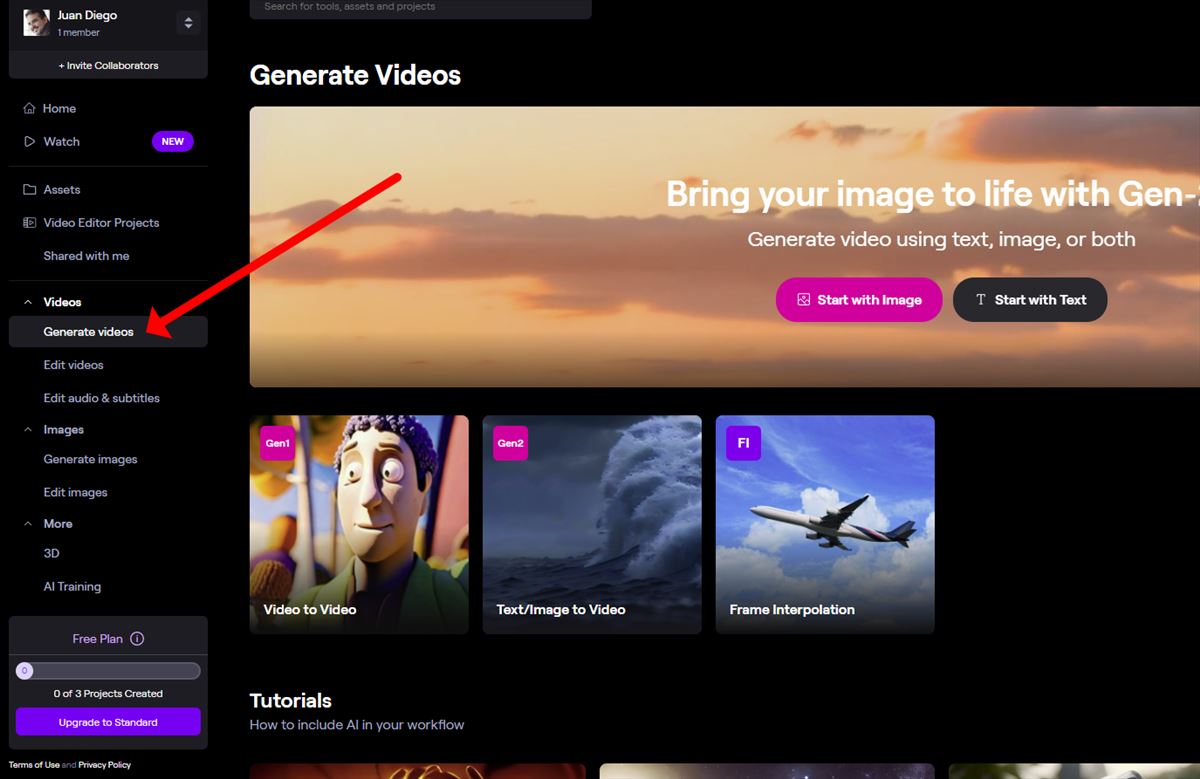

Después de crear una cuenta en Runway, nos encontramos con el siguiente panel de control:

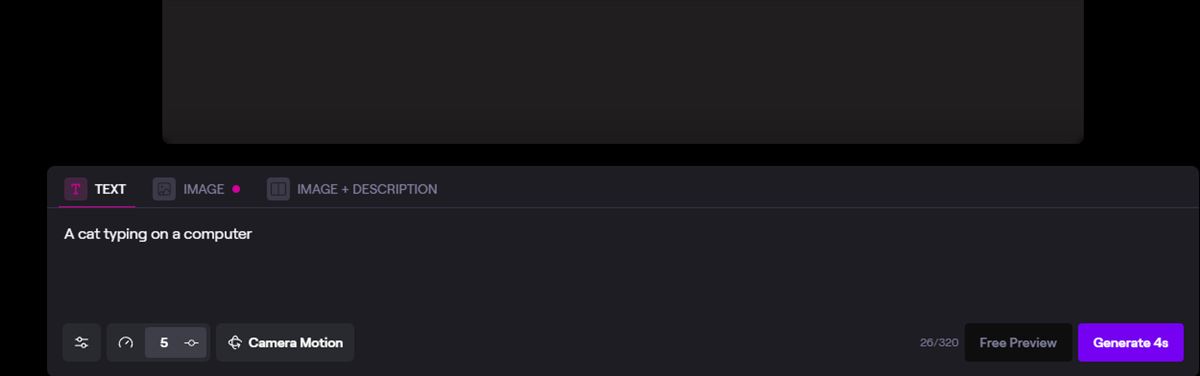

Una vez seleccionamos la cuenta gratuita, podemos comenzar a usar Gen2 para poner nuestro prompt y generar el vídeo deseado. Selecciono la opción del medio y pongo el prompt de «un gato tecleando en un ordenador»

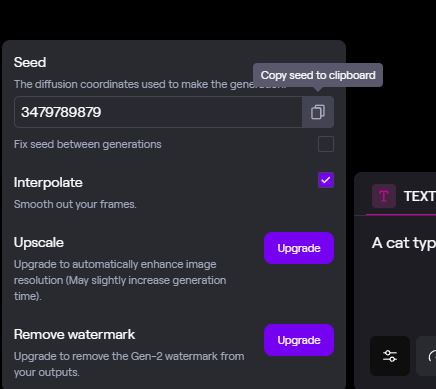

Generalmente hay una opción de previsualizar, pero en tiempos de mucho tráfico la deshabilitan, por lo que pongo cinco segundos, y establezco las siguientes variables:

La herramienta Gen-2 de Runway simplifica la creación de videos a través de IA, permitiendo a los usuarios generar contenido visual a partir de descripciones textuales o imágenes de referencia. A continuación, se detallan los pasos y cosas a tener en cuenta para utilizar esta herramienta:

1. Descripción de la Escena

- Lo primero es tener una idea clara de la escena que se desea crear.

- Se debe escribir una descripción detallada de la escena en la herramienta. Cuanto más descriptivo sea el texto, mejores serán los resultados.

- Si se cuenta con una imagen de referencia que se desea utilizar, se puede incluir en este paso.

2. Generación de Previsualización

- Antes de generar el video, la herramienta proporcionará una previsualización en forma de fotograma de cómo se verá.

- Si el resultado es satisfactorio, se procede a generar el video.

- En caso contrario, se pueden hacer ajustes en la descripción inicial para obtener una previsualización diferente.

3. Evaluación del Resultado

- Tras cada generación de video, se presenta la oportunidad de evaluar el resultado otorgando una calificación de uno a cinco estrellas.

- Esta evaluación ayuda a mejorar el modelo Gen-2 y, por ende, los resultados futuros que se obtendrán con la herramienta.

4. Inspiración

- Si se tiene dificultad en visualizar o describir una escena, se puede visitar la sección «Featured» para encontrar ejemplos inspiradores de lo que Gen-2 puede hacer.

- Desde esta sección, es posible utilizar las mismas descripciones proporcionadas para generar videos propios.

5. Consideraciones de Créditos

- La generación de videos consume créditos, específicamente 5 créditos por cada segundo de video generado.

- Es importante tener en cuenta la cantidad de créditos disponibles antes de proceder con la generación de videos. En mi caso empiezo con 525 créditos.

Aquí tenéis mi resultado, en este enlace

Opinión personal

El resultado es mejor que el que he tenido con otras herramientas (me ha gustado más que Kaiber), pero me faltan variables, y el gato no está tecleando, únicamente está mirando el monitor, por lo que el resultado no es exactamente lo mismo que lo que he pedido.

Aún así, está claro que estamos frente a un paso importante para que las películas del futuro se hagan desde el ordenador, pidiendo lo que queremos ver en cada escena.