OpenAI está trasladando a inversores un ajuste importante en su hoja de ruta de infraestructura: su objetivo de gasto total en cómputo de aquí a 2030 pasaría a rondar los 600.000 millones de dólares, una cantidad muy por debajo del compromiso previo de 1,4 billones. La información, difundida por CNBC y recogida en un artículo… Continúa leyendo »

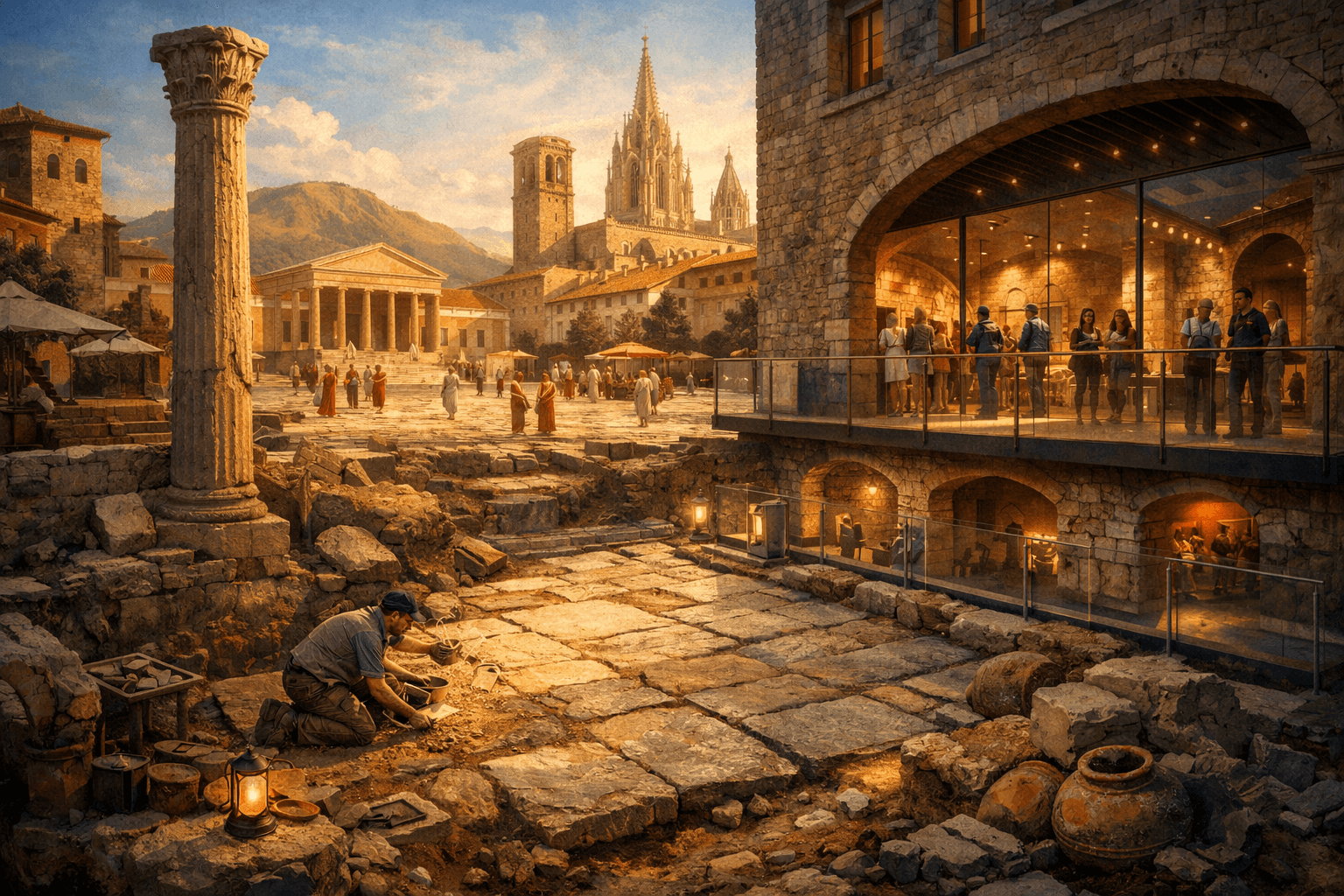

Un pavimento bajo un hotel obliga a repensar el foro de Barcino y el plano de la Barcelona romana

En la calle d’Hèrcules, número 3, en el corazón del barrio Gòtic, unas obras que parecían rutinarias han abierto una puerta directa a los primeros años de la ciudad. Durante la ampliación del Gran Hotel Barcino, los equipos técnicos y arqueológicos localizaron, bajo el edificio histórico conocido como Casa Requesens, un pavimento monumental de época romana. Visto desde fuera puede parecer “solo” un suelo antiguo, pero en arqueología urbana un pavimento bien conservado funciona como una regla dibujada sobre el papel: marca alineaciones, delimita espacios y ayuda a ubicar lo que antes eran hipótesis. Medios como El País, La Vanguardia, elDiario.es, Cadena SER, betevé y Ara han coincidido en la relevancia del descubrimiento por su estado de conservación y por lo que implica para entender la Barcelona romana. Continúa leyendo «Un pavimento bajo un hotel obliga a repensar el foro de Barcino y el plano de la Barcelona romana»