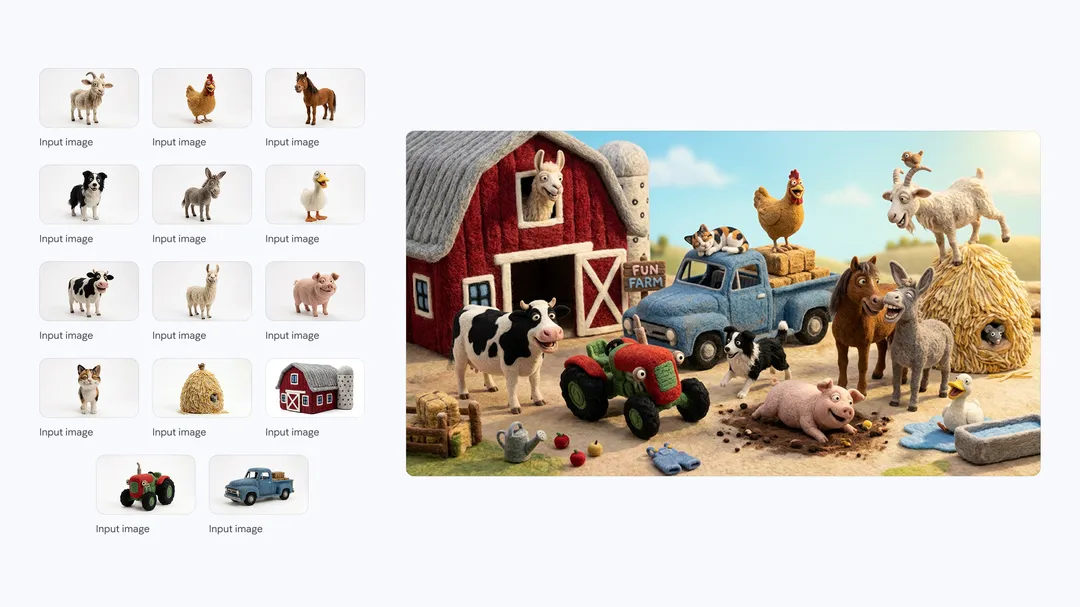

Google DeepMind ha presentado Nano Banana 2, identificado también como Gemini 3.1 Flash Image, como su modelo más reciente para generación y edición de imágenes dentro del ecosistema Gemini. La idea central es sencilla de entender si pensamos en una cocina: hasta ahora, para lograr un plato “de restaurante” solía hacer falta fuego lento; con Nano Banana 2, Google dice haber encontrado una forma de mantener el sabor y la presentación con un ritmo mucho más rápido. Según el anuncio firmado por Naina Raisinghani, product manager en Google DeepMind, el modelo busca juntar la calidad y el razonamiento visual que se asociaban a la versión Pro con la velocidad propia de la familia Flash.

Este enfoque no se limita a “crear imágenes bonitas”. Google lo plantea como una herramienta para iterar rápido, corregir detalles sin fricción y producir recursos que puedan pasar de la pantalla del diseñador a un uso real en campañas, productos o contenidos con menos pasos intermedios. Continúa leyendo «Nano Banana 2: el nuevo modelo de imágenes de Google que apuesta por velocidad sin renunciar al control»