La atención del mercado hacia Oklo no es nueva, pero a veces una sola nota de análisis funciona como ese empujón que hace que una conversación vuelva a la mesa. Según informó Barron’s, BofA Securities elevó su recomendación sobre la acción a “Comprar” desde “Neutral” y, al mismo tiempo, revisó al alza su precio objetivo… Continúa leyendo »

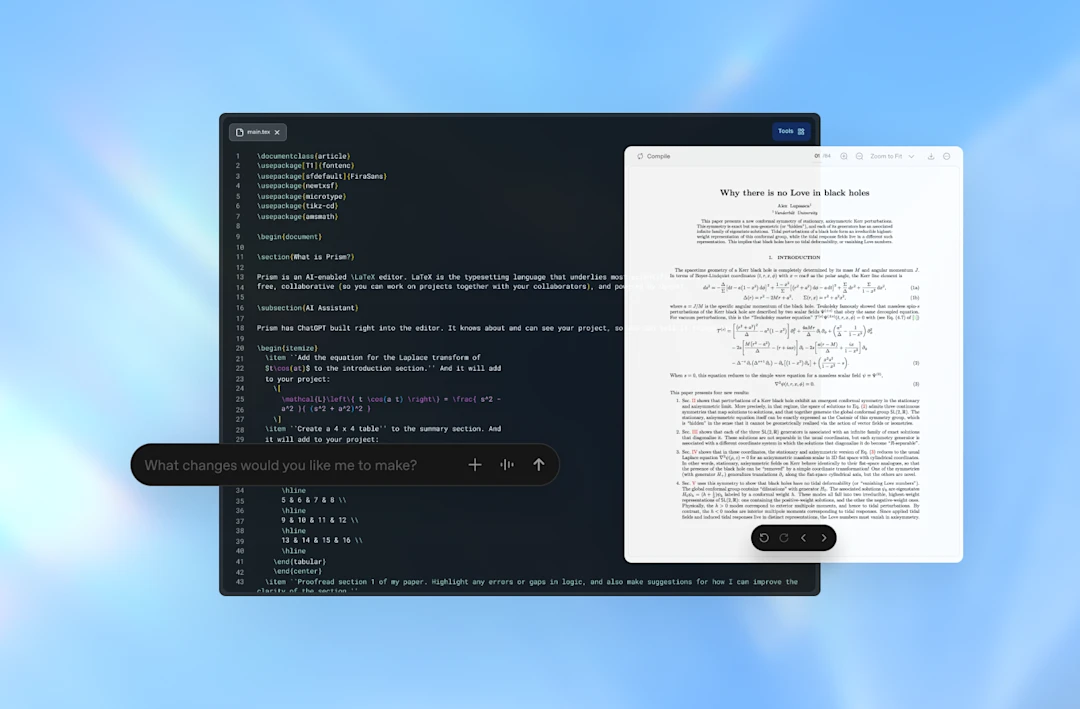

Maia 200: el chip de inferencia de Microsoft que quiere abaratar el coste de la IA en Azure

Cuando hablamos de modelos grandes, solemos imaginar el momento épico del entrenamiento, como si fuera el rodaje de una película. En la práctica, lo que más factura no es grabar, sino emitir la serie cada día a millones de personas. Esa “emisión” se llama inferencia, el trabajo de generar respuestas en tiempo real cuando alguien usa un chatbot, un copiloto de productividad o un sistema de atención al cliente.

Microsoft lleva tiempo insistiendo en que el cuello de botella ya no es solo construir modelos, sino mantenerlos funcionando de forma rentable y consistente en centros de datos. En esa línea se entiende el anuncio de Maia 200, un acelerador de IA diseñado con una misión muy concreta: producir “tokens” (las unidades con las que el modelo compone texto) con menos coste y menor consumo energético, sin sacrificar la experiencia de uso. Según Microsoft, su objetivo es recortar el coste de ejecutar modelos a escala y mejorar el rendimiento económico de la infraestructura de inferencia. Continúa leyendo «Maia 200: el chip de inferencia de Microsoft que quiere abaratar el coste de la IA en Azure»