Google ha ampliado Canvas en AI Mode para que esté disponible “para todo el mundo en Estados Unidos” y en inglés, integrado dentro de Google Search. La idea es sencilla de explicar, aunque ambiciosa en la práctica: convertir la búsqueda con IA en un lugar donde no solo preguntas y recibes una respuesta, sino donde… Continúa leyendo »

Canvas en AI Mode: el espacio de trabajo de Google Search para escribir, programar y ordenar proyectos

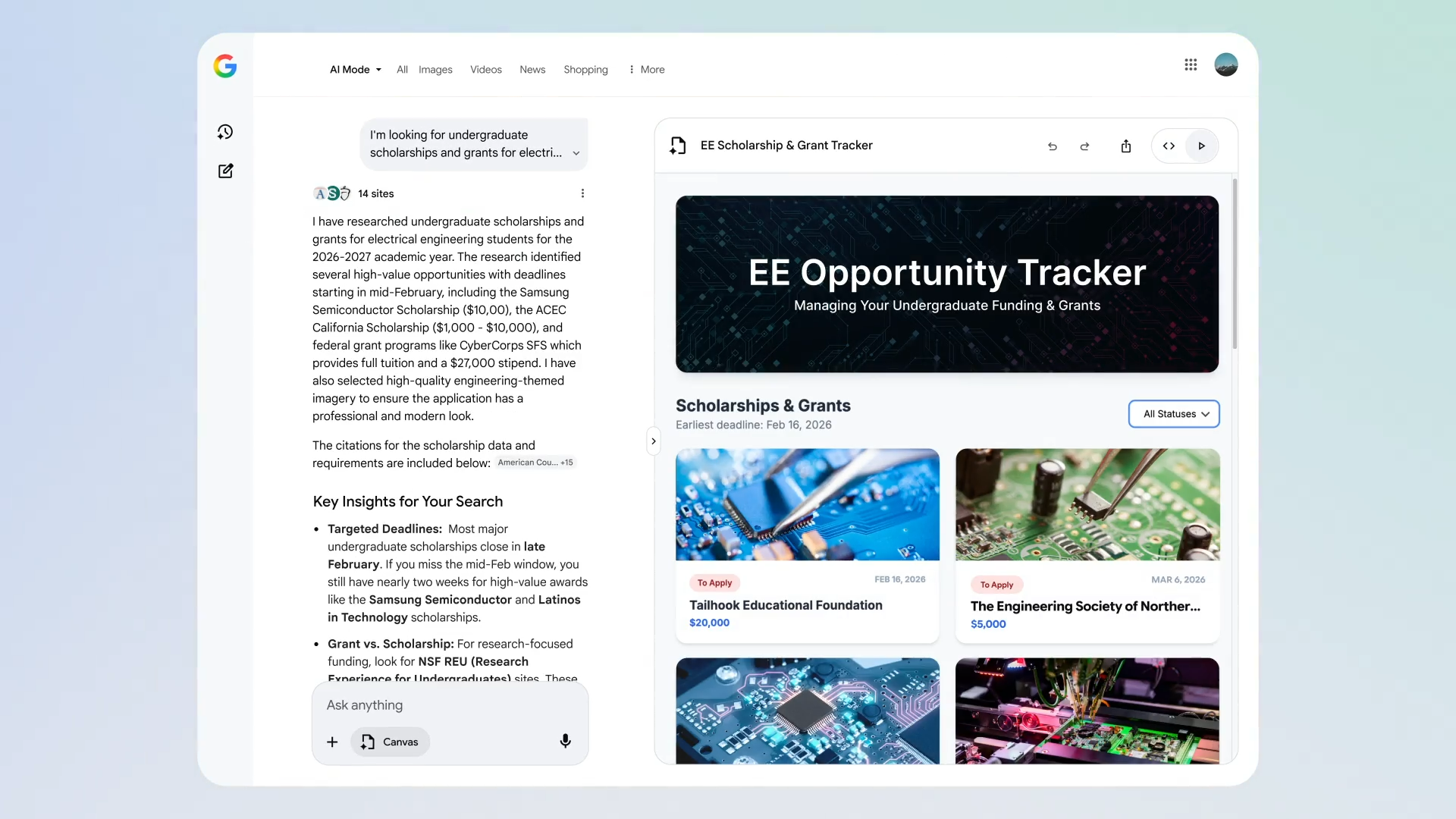

Google ha ampliado Canvas en AI Mode para que esté disponible “para todo el mundo en Estados Unidos” y en inglés, integrado dentro de Google Search. La idea es sencilla de explicar, aunque ambiciosa en la práctica: convertir la búsqueda con IA en un lugar donde no solo preguntas y recibes una respuesta, sino donde también construyes algo que se queda contigo y va madurando con el tiempo. Google lo describe como un “espacio dedicado y dinámico” para organizar planes y proyectos, con soporte reforzado para escritura creativa y tareas de programación.

En vez de tratar cada consulta como una conversación que se pierde en el historial, Canvas funciona como una mesa de trabajo: dejas documentos a medio hacer, retomas una idea, pruebas un prototipo, ajustas el texto, revisas el código. Esta lógica de “panel lateral” encaja con la forma en la que muchas personas ya usan herramientas de IA: iterando, comparando versiones y puliendo detalles hasta que el resultado encaja. Continúa leyendo «Canvas en AI Mode: el espacio de trabajo de Google Search para escribir, programar y ordenar proyectos»