Entre el 18 y el 25 de febrero de 2026, Google Threat Intelligence Group (GTIG), Mandiant y varios socios ejecutaron una operación coordinada para frenar una campaña de ciberespionaje a escala global. El actor, identificado como UNC2814 y vinculado por los investigadores a un posible nexo con la República Popular China (PRC), llevaba años operando… Continúa leyendo »

GRIDTIDE y el “C2 en una hoja de cálculo”: así fue la disrupción de una campaña global de espionaje contra telecos y gobiernos

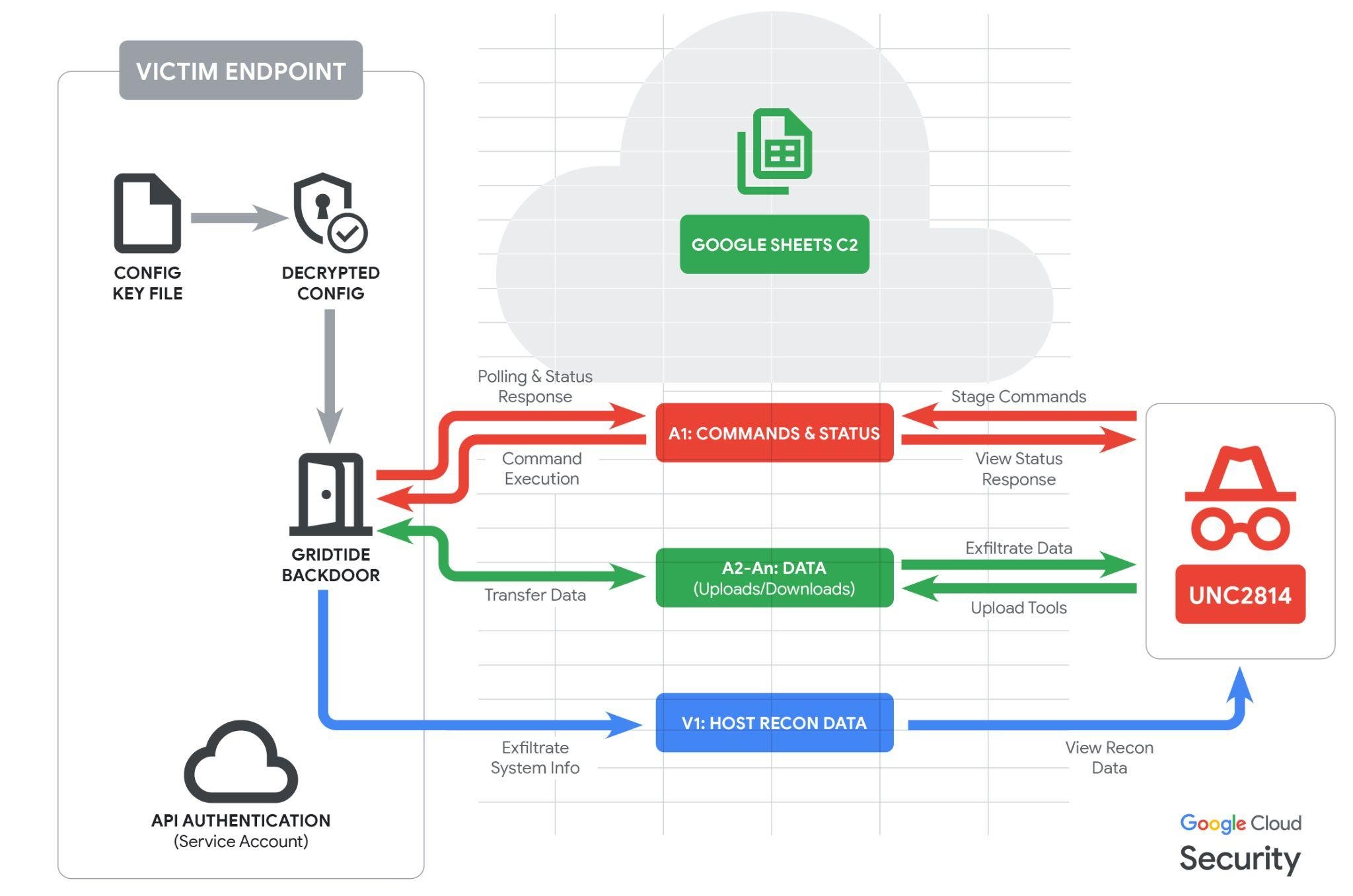

Entre el 18 y el 25 de febrero de 2026, Google Threat Intelligence Group (GTIG), Mandiant y varios socios ejecutaron una operación coordinada para frenar una campaña de ciberespionaje a escala global. El actor, identificado como UNC2814 y vinculado por los investigadores a un posible nexo con la República Popular China (PRC), llevaba años operando con un perfil discreto y un objetivo constante: operadores de telecomunicaciones y organismos gubernamentales en múltiples regiones.

Según los datos publicados por GTIG, cuando se llevó a cabo la disrupción había intrusiones confirmadas en 42 países y un total de 53 víctimas verificadas, con señales de actividad sospechosa en al menos una veintena de países adicionales. Un matiz relevante para no mezclar titulares: GTIG indica que esta actividad no se solapa con lo reportado públicamente como “Salt Typhoon”, ni en víctimas ni en el modo de operar.

La razón por la que este caso merece atención no es solo el volumen. Es el enfoque. En lugar de apoyarse en una vulnerabilidad concreta del proveedor, los atacantes explotaron funciones legítimas de servicios en la nube para camuflar su tráfico como si fuera normal. Es como entrar a un edificio sin forzar la puerta porque alguien dejó una tarjeta de visita “válida” encima del mostrador. Continúa leyendo «GRIDTIDE y el “C2 en una hoja de cálculo”: así fue la disrupción de una campaña global de espionaje contra telecos y gobiernos»