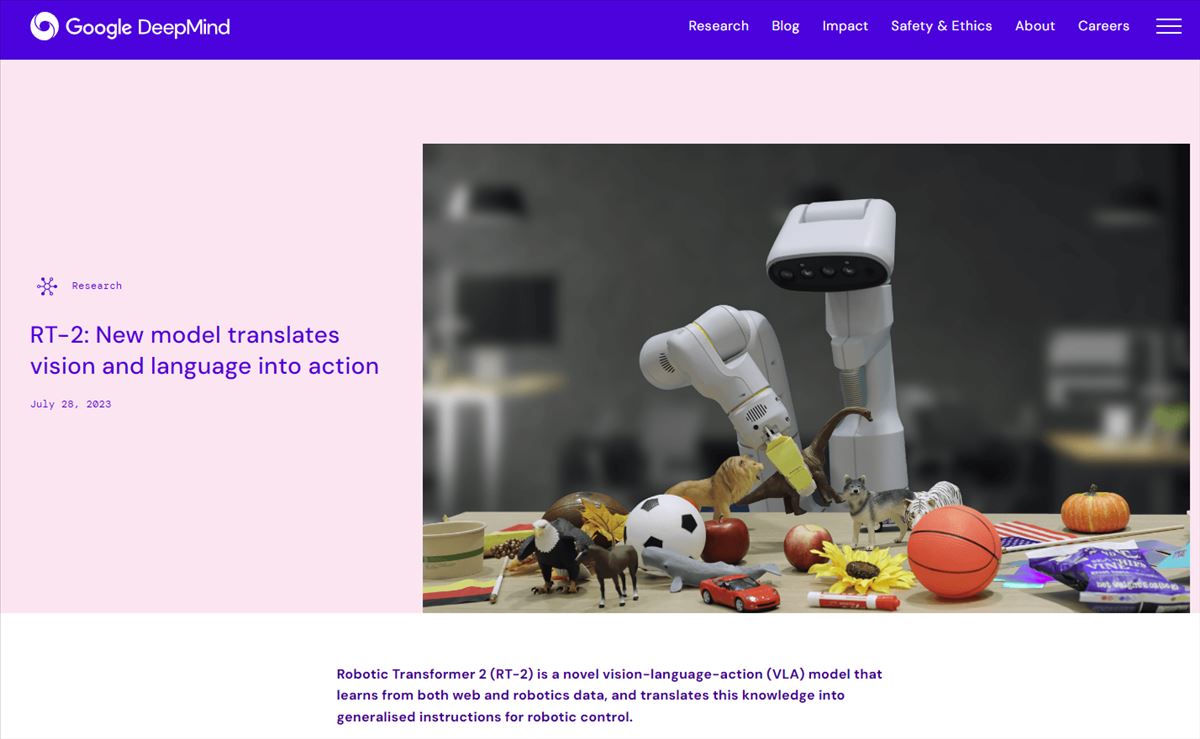

En un paso adelante hacia una comunicación más fluida entre seres humanos y máquinas, DeepMind ha presentado su modelo RT-2. Este nuevo sistema permite el control de robots a través de instrucciones en lenguaje natural y visionado de imágenes, combinando textos, imágenes y coordenadas en un solo modelo. A continuación, se presenta un análisis profundo de esta tecnología y su potencial en la industria robótica.

RT-2: Uniendo Visión, Lenguaje y Coordenadas

El Modelo

El RT-2 (Robotics Transformer versión 2) no es solo un modelo de lenguaje grande. Va más allá al integrar no solo imágenes y texto, sino también datos de coordenadas de los movimientos de un robot en el espacio. Esta fusión permite que, una vez entrenado, el modelo pueda generar tanto un plan de acción como las coordenadas necesarias para llevar a cabo un comando, utilizando grados de libertad (6-DoF) en las coordenadas espaciales.

Instrucciones en Tiempo Real

La clave de RT-2 es su capacidad para recibir instrucciones en tiempo real. Los datos grabados por el robot se convierten en una fuente para nuevas acciones, permitiendo que las instrucciones sean tan simples como conversar con un chatbot, como ChatGPT.

Codificación y Transformación de Acciones

Transformación de Acciones

El modelo RT-2 codifica las acciones del robot como coordenadas en el espacio. Estas acciones se integran durante el entrenamiento junto con los tokens de palabras e imágenes. Las coordenadas del robot se convierten en otra parte de una frase, facilitando la interacción.

Una Mezcla Innovadora

La innovación aquí reside en la combinación de física de robots, programación de bajo nivel y redes neuronales de imágenes y lenguaje en una mezcla unificada. El programa RT se basa en dos esfuerzos anteriores de Google, PaLI-X y PaLM-E, y los lleva un paso más allá, generando no solo el plan de acción sino también las coordenadas de movimiento en el espacio.

Versatilidad y Eficiencia de RT-2

Sucesor Mejorado

RT-2 es sucesor de RT-1 y se basa en modelos de lenguaje grandes como PaLI-X y PaLM-E. Esto significa que tiene muchos más parámetros neurales, lo que generalmente hace que los programas sean más eficientes.

Pruebas y Predicciones

Una vez entrenado, el RT-2 se sometió a una serie de pruebas, demostrando su habilidad para interpretar comandos en lenguaje natural junto con una imagen, para ejecutar acciones específicas. Esto incluye tareas complejas que involucran razonamiento, comprensión de símbolos y reconocimiento humano.

Desafíos y Perspectivas Futuras

A pesar de los avances, el coste computacional de estos modelos es alto. El artículo menciona que la inferencia en tiempo real puede ser un cuello de botella significativo, y sugiere que una dirección emocionante para la investigación futura sería explorar técnicas que permitan que estos modelos funcionen a tasas más altas o en hardware de menor costo.

El modelo RT-2 de DeepMind abre un camino prometedor hacia la comunicación más intuitiva y accesible entre humanos y robots. Aunque aún hay desafíos a superar, el potencial de esta tecnología es evidente. Podemos esperar que la integración de la visión, el lenguaje y la acción en la robótica conduzca a aplicaciones más amplias y significativas, fortaleciendo nuestra conexión con las máquinas y avanzando hacia una colaboración más efectiva.

Más información en DeepMind