Hoy quiero hablaros de una novedad que seguramente captará la atención de todos aquellos apasionados por la tecnología y la inteligencia artificial, especialmente para los entusiastas del hardware y el software que buscan explorar las capacidades de la IA en sus propias máquinas. Se trata de Chat with RTX, una herramienta lanzada por Nvidia que promete revolucionar la forma en que interactuamos con modelos de IA generativa directamente desde nuestro PC.

Nvidia, conocida por estar en la vanguardia de las soluciones gráficas, no se queda atrás en el terreno de la inteligencia artificial. Con Chat with RTX, la compañía busca incentivar la adquisición de sus últimas tarjetas gráficas GeForce RTX 30 y 40 Series, permitiendo a los propietarios de estas tarjetas ejecutar un chatbot impulsado por IA de manera offline en un PC con Windows.

Lo interesante de esta herramienta es su capacidad para personalizar un modelo GenAI al estilo de ChatGPT de OpenAI, conectándolo a documentos, archivos y notas para realizar consultas específicas. Imaginad la facilidad de preguntar, por ejemplo, «¿Cuál fue el restaurante que mi pareja recomendó mientras estábamos en Barcelona?«, y que Chat with RTX escanee los archivos locales señalados y proporcione la respuesta con contexto. Este nivel de personalización abre un abanico de posibilidades para la productividad personal y profesional, permitiéndonos acceder a información de manera rápida y eficiente sin necesidad de buscar manualmente a través de notas o contenido guardado.

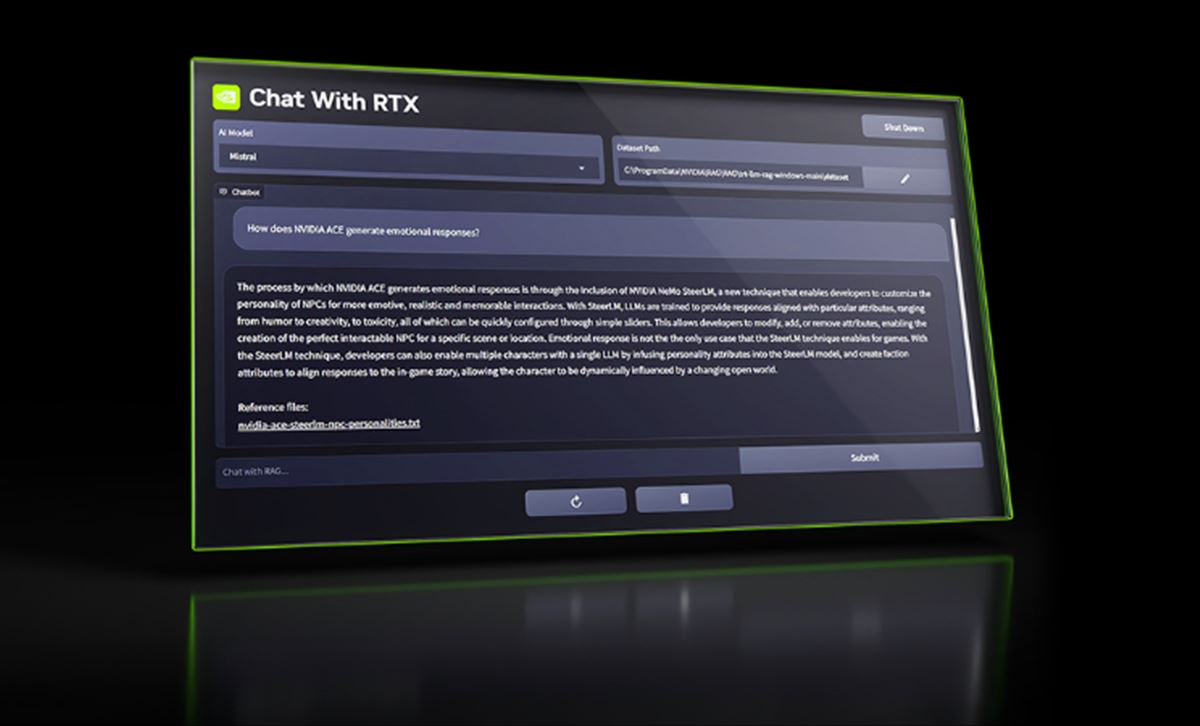

Aquí lo tenéis funcionando:

La herramienta por defecto utiliza el modelo de código abierto de la startup AI Mistral, pero también es compatible con otros modelos basados en texto, incluido Llama 2 de Meta. Sin embargo, es importante mencionar que descargar todos los archivos necesarios puede requerir una cantidad considerable de almacenamiento, entre 50GB y 100GB dependiendo del modelo seleccionado. Este aspecto es crucial para quienes estén considerando esta herramienta, ya que implica una inversión no solo en la tarjeta gráfica sino también en soluciones de almacenamiento.

A pesar de sus promesas, Chat with RTX tiene sus limitaciones. Por ejemplo, la herramienta no puede recordar el contexto de las preguntas anteriores, lo que puede limitar la continuidad de las conversaciones. Además, la relevancia de las respuestas puede verse afectada por diversos factores, como la formulación de la pregunta, el rendimiento del modelo seleccionado y el tamaño del conjunto de datos de ajuste fino.

Aun así, la iniciativa de Nvidia destaca por facilitar la ejecución de modelos de IA de manera local, una tendencia en crecimiento según el Foro Económico Mundial, que predice un aumento «dramático» en dispositivos asequibles capaces de ejecutar modelos GenAI offline. Las ventajas son claras: mayor privacidad, ya que los datos procesados nunca abandonan el dispositivo; menor latencia y más eficiencia en costos en comparación con los modelos alojados en la nube.

No obstante, la democratización de herramientas para ejecutar y entrenar modelos también abre la puerta a actores maliciosos, un tema que no debe tomarse a la ligera. En WWWhatsnew, siempre hemos destacado la importancia de usar la tecnología de manera responsable y consciente de los riesgos potenciales.

Estaremos atentos a cómo evoluciona esta tecnología y su impacto en el ámbito de la productividad y más allá.