La inteligencia artificial está en constante evolución, y una de las áreas más fascinantes es la de los modelos multimodales. Estos modelos, conocidos como LMM, permiten la interacción con sistemas de IA mediante texto e imágenes. Aunque GPT-4 Vision de OpenAI está siendo un referente en este campo, su naturaleza comercial y cerrada ha abierto la puerta a alternativas de código abierto. Entre ellas destaca LLaVA 1.5.

LLaVA 1.5 es un modelo de IA que combina varios componentes generativos para crear un sistema computacionalmente eficiente y preciso. Su rendimiento en diversas tareas lo posiciona como un candidato prometedor en el ámbito de los modelos multimodales de código abierto.

Arquitectura de los modelos multimodales (LMM)

Los LMM emplean modelos preentrenados para codificar características visuales. Estos modelos se alinean con el espacio de incrustación de palabras del modelo de lenguaje.

Un modelo de lenguaje grande y preentrenado, como GPT-4, se utiliza para comprender las instrucciones del usuario y generar respuestas.

Un conector cruzado de modalidad visión-lenguaje se encarga de alinear el codificador visual y el modelo de lenguaje, permitiendo una interacción fluida entre ambos.

Sobre LLaVA 1.5

LLaVA 1.5 utiliza CLIP (Contrastive Language–Image Pre-training) como su codificador visual, un modelo desarrollado por OpenAI que aprende a asociar imágenes y texto. El modelo de lenguaje de LLaVA es Vicuna, una versión del modelo de código abierto LLaMA de Meta, ajustada para seguir instrucciones.

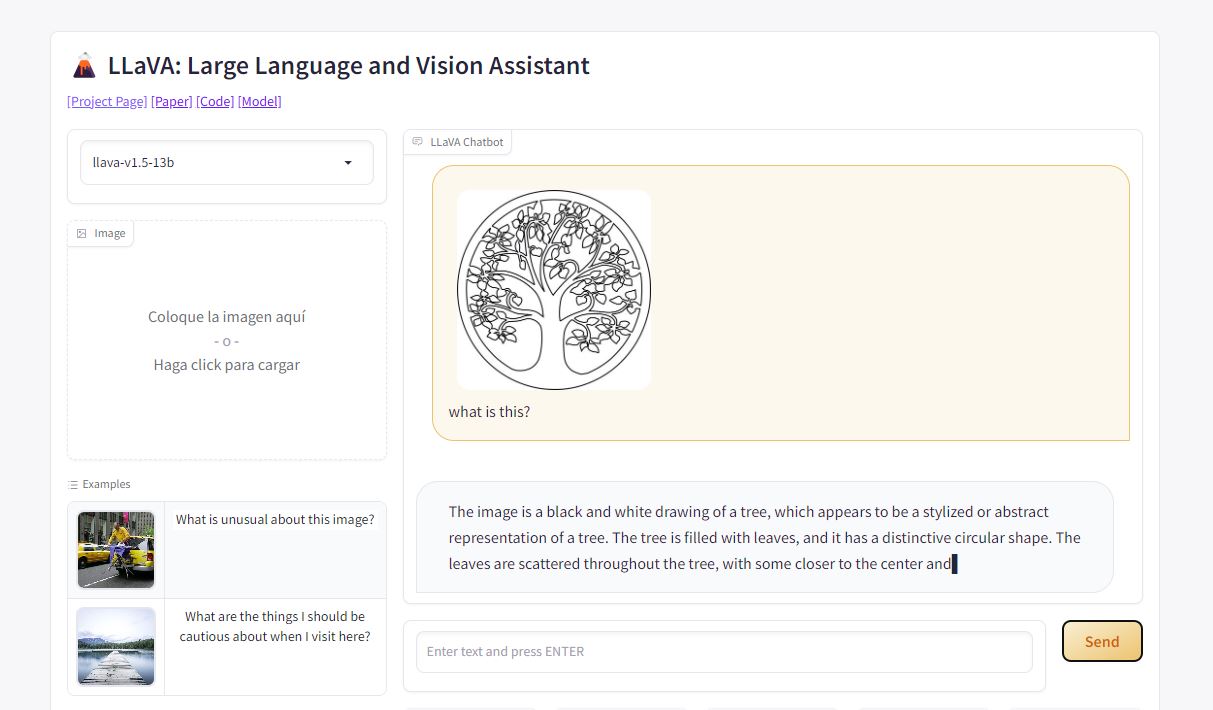

Para usarlo solo tenemos que enviar una imagen a su web y comenzar a interactuar con el campo de texto, preguntando cosas sobre la imagen, por ejemplo, siendo así ideal para obtener descripciones que después podamos llevar a midjourney.

Aunque LLaVA 1.5 muestra un rendimiento impresionante, su uso comercial está limitado debido a los términos de uso de ChatGPT, en los que se basa su entrenamiento. Aún así, es una buena opción para usarlo directamente desde su web, sin necesidad de tener un plan de GPT Plus.

Que quede claro que GPT-4 Vision sigue siendo más fácil de usar e integrar con otras herramientas de OpenAI, lo que plantea desafíos para LLaVA 1.5 en términos de adopción masiva.

Más información en LLaVA 1.5