Google ha presentado Visual Captions, una innovadora solución que transforma la comunicación en video sincrónica al ofrecer sugerencias de imágenes relevantes en tiempo real. Esta herramienta forma parte del proyecto ARChat, que tiene como objetivo facilitar la comunicación aumentada con transcripción en tiempo real. Mediante el análisis de verbalizaciones, Visual Captions sugiere imágenes adecuadas durante las conversaciones, mejorando la comprensión y la expresión de contenidos. Conozcamos en detalle esta revolucionaria tecnología.

Visual Captions: mejorando la comunicación con imágenes en tiempo real

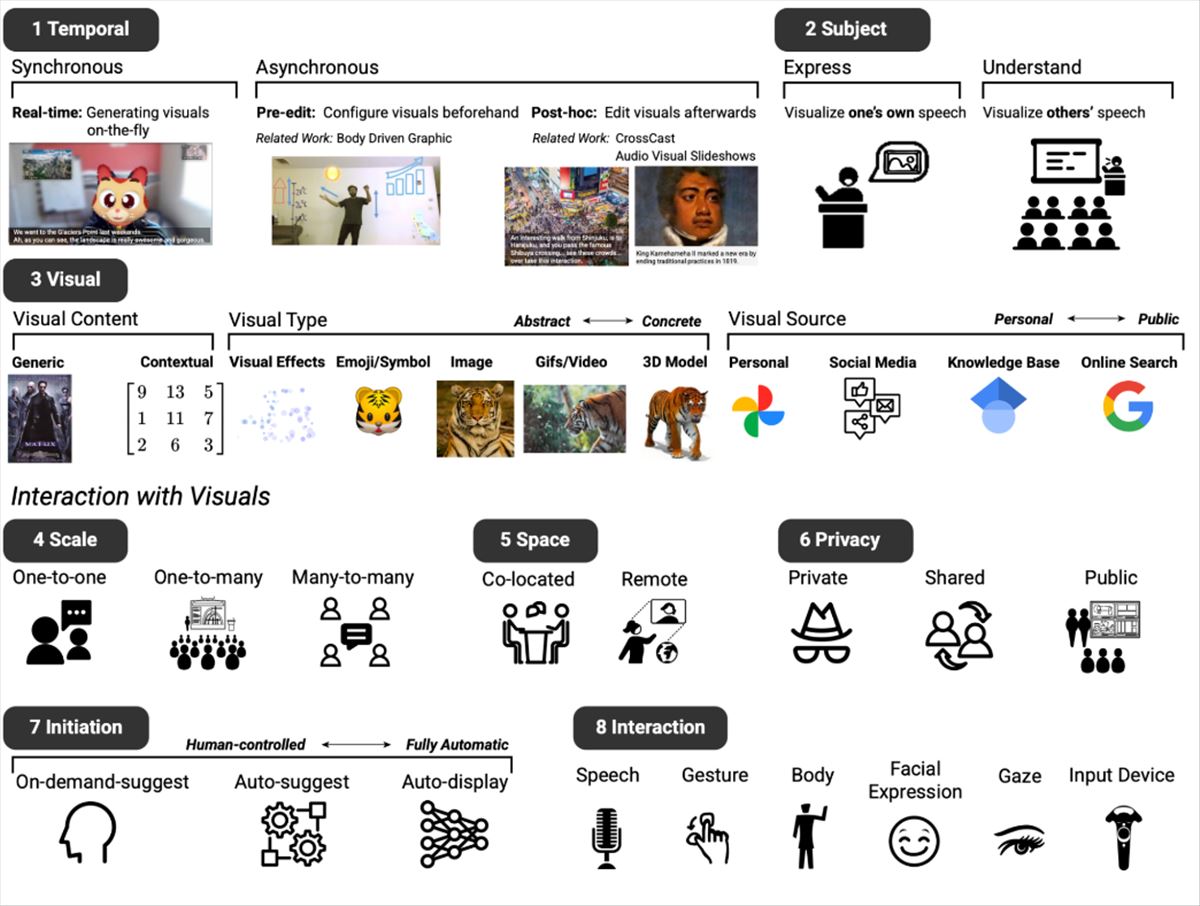

El proyecto ARChat de Google ha dado lugar a Visual Captions, un sistema que busca potenciar las videoconferencias mediante la inclusión de imágenes en tiempo real. Para desarrollarlo, se llevaron a cabo estudios con la participación de diez individuos provenientes de diversos ámbitos, lo que permitió identificar ocho dimensiones fundamentales relacionadas con la mejora visual en las conversaciones. Entre estas dimensiones se incluyen el momento oportuno para mostrar las imágenes, su papel en la expresión y comprensión del contenido verbal, los tipos y fuentes de contenido visual, las consideraciones de escala y configuración de las reuniones, la privacidad, la iniciación de la interacción y los métodos de interacción.

Generando imágenes relevantes de manera sincrónica

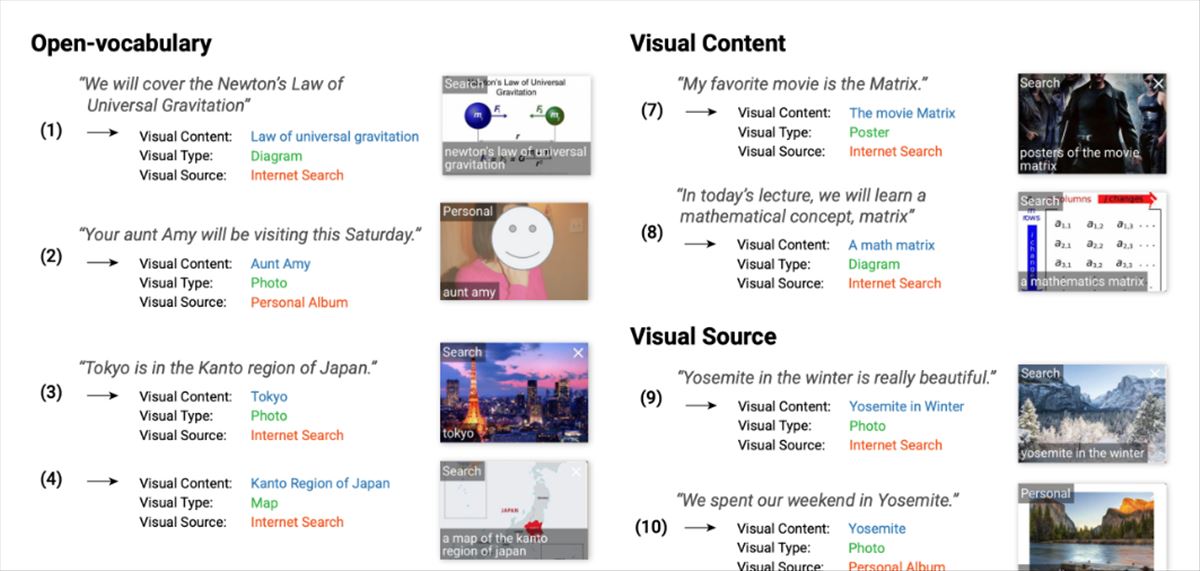

Basándose en los valiosos aportes obtenidos, se diseñó Visual Captions para generar imágenes sincrónicas que sean semánticamente relevantes a la conversación en curso. El sistema fue sometido a pruebas en diversos escenarios, como conversaciones remotas uno a uno, presentaciones y discusiones grupales. Para entrenar el sistema de manera efectiva, se creó un conjunto de datos específico llamado VC1.5K, que consiste en pares de lenguaje, contenido visual, tipo y fuente en diferentes contextos. El modelo fue entrenado utilizando un modelo de lenguaje amplio y el conjunto de datos, superando en eficacia a los enfoques basados en palabras clave y logrando una alta precisión.

Estudios de usuarios: evaluando la efectividad de Visual Captions

Se llevaron a cabo estudios de usuarios para evaluar la efectividad de Visual Captions. Los participantes encontraron que las imágenes eran informativas, de alta calidad y relevantes. El tipo y la fuente de las imágenes coincidían de manera precisa con el contexto de la conversación. Además, se realizaron estudios controlados en laboratorio y despliegues en condiciones reales para evaluar el sistema. Se descubrió que las imágenes en tiempo real mejoraron las conversaciones al explicar conceptos, resolver ambigüedades lingüísticas y aumentar el compromiso. Diferentes niveles de proactividad en la sugerencia de imágenes fueron preferidos según los escenarios sociales.

Visual Captions en la plataforma ARChat

Visual Captions fue desarrollado en la plataforma ARChat, la cual integra widgets interactivos en plataformas de videoconferencias como Google Meet. El sistema captura la verbalización de los usuarios, predice las intenciones visuales en tiempo real, recupera imágenes relevantes y las sugiere a los usuarios. Ofrece tres niveles de proactividad en la sugerencia de imágenes: auto-mostrar, auto-sugerir y sugerir a demanda.

Tenéis más información en ai.googleblog.com