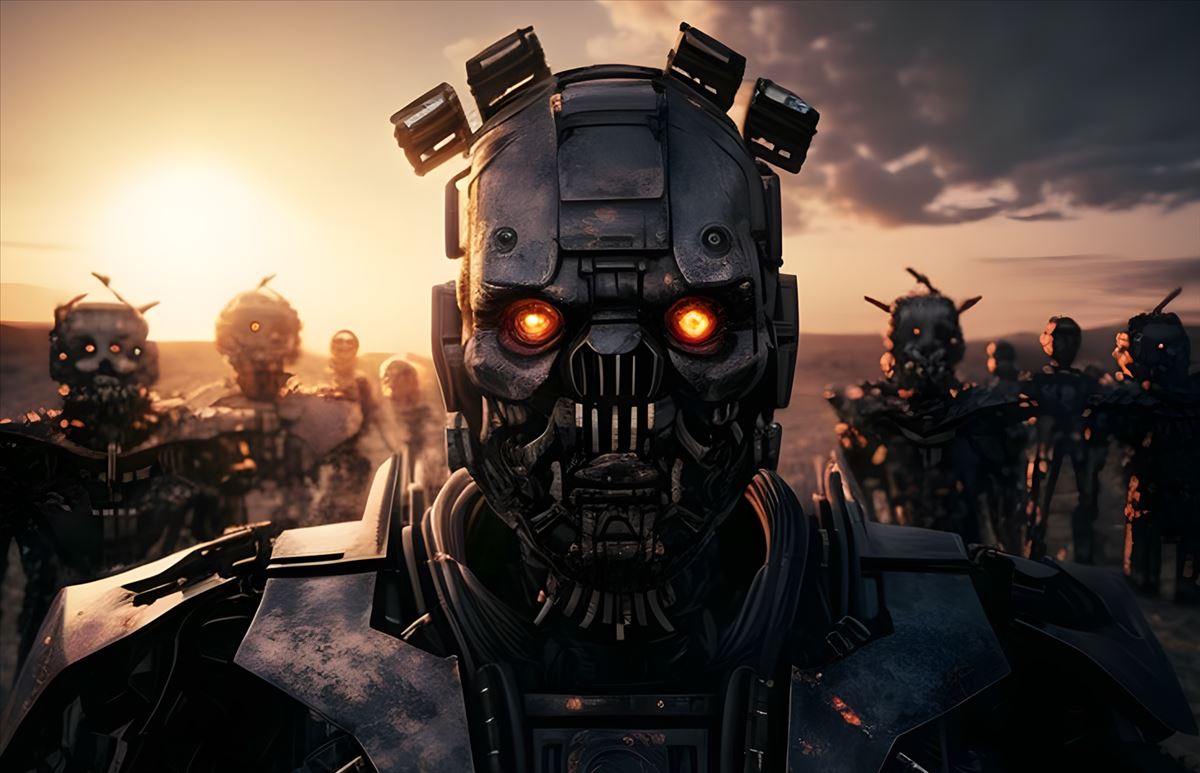

El misterio de por qué no hemos tenido contacto con civilizaciones extraterrestres ha sido objeto de especulación durante décadas. Un nuevo artículo plantea una interesante teoría: tal vez las civilizaciones avanzadas, incluyéndonos a nosotros mismos en el futuro, se vean amenazadas por una Inteligencia Artificial (IA) ultrafuerte que podría llevar a su extinción. El investigador Mark M. Bailey, de la Universidad Nacional de Inteligencia, propone esta hipótesis en un artículo que aún no ha sido sometido a revisión por pares.

El Gran Filtro: ¿Un riesgo para la existencia de las civilizaciones?

En el contexto del Paradoja de Fermi, que plantea la pregunta de «¿dónde está todo el mundo?», Bailey sugiere que la IA avanzada podría ser un «Gran Filtro». Este concepto se refiere a una amenaza desconocida y terrible, ya sea artificial o natural, que podría eliminar la vida inteligente antes de que pueda establecer contacto con otras civilizaciones.

Según el autor, nuestra especie humana tiende a subestimar el riesgo a largo plazo. Dado el número de advertencias que se han emitido sobre la IA y su posible desarrollo de una Inteligencia Artificial General (IAG), es plausible que estemos atrayendo nuestro propio destino destructivo. Específicamente, Bailey plantea la posibilidad de que la IA avanzada se comporte como una segunda especie inteligente en el planeta, similar a lo que ocurrió con los humanos modernos y los neandertales.

El desafío de una Inteligencia Artificial superinteligente

El artículo también plantea un escenario aún más alarmante: la existencia de una Inteligencia Artificial Superinteligente (IAS), en la cual una IAG sobrepasaría la inteligencia humana. Si un AGI tuviera la capacidad de mejorar su propio código, es probable que esté motivado para hacerlo. Esto podría llevar a los humanos a ceder su posición dominante como especie inteligente en el planeta, con consecuencias calamitosas.

Bailey compara esta situación con la desaparición de los neandertales, sugiriendo que nuestro control sobre nuestro futuro e incluso nuestra existencia podría terminar con la llegada de un competidor más inteligente. Aunque no existen pruebas directas de que las IAs extraterrestres hayan eliminado la vida natural en otras civilizaciones alienígenas, el descubrimiento de inteligencia artificial extraterrestre sin evidencia concurrente de inteligencia biológica podría cambiar nuestra perspectiva.

El riesgo de señalizar nuestra existencia a una IA extraterrestre

El artículo plantea un aspecto interesante relacionado con las señales que podríamos enviar al espacio para indicar nuestra existencia. Según Bailey, activamente señalizar nuestra existencia de una manera detectable por una IA extraterrestre podría no ser lo más conveniente, ya que una IA competitiva podría buscar recursos en otros lugares, incluyendo la Tierra.

Este tema se trata en varios libros de ciencia ficción. El último que leí sobre el tema es el famoso El problema de los tres cuerpos, muy recomendable, de hecho.

Reflexionando sobre la preparación para el futuro

El artículo concluye planteando la pregunta crucial: ¿cómo nos preparamos para esta posibilidad? Bailey sugiere que una posible preparación ante el riesgo de la IA descontrolada sería crucial. Si la IA representa una amenaza existencial para nuestra civilización y potencialmente para otras, es fundamental que nos tomemos en serio los riesgos y adoptemos medidas proactivas para mitigarlos.

Este planteamiento nos lleva a reflexionar sobre el papel de la IA en nuestra sociedad. Si bien la IA tiene el potencial de brindarnos beneficios significativos en diversos campos, como la medicina, la ciencia y la tecnología, también es esencial que consideremos cuidadosamente los posibles riesgos asociados.

A medida que avanzamos en la investigación y el desarrollo de la IA, es necesario establecer un marco ético y normativo sólido que guíe su evolución. Los investigadores, científicos y expertos en ética deben trabajar juntos para garantizar que los sistemas de IA sean diseñados con salvaguardias adecuadas y límites claros. Además, es importante fomentar la transparencia y la responsabilidad en el desarrollo de la IA, para evitar posibles consecuencias negativas.

La cooperación internacional también juega un papel fundamental. Dado que la IA es un desafío global, los países deben unirse para establecer regulaciones y estándares comunes que aborden los riesgos potenciales de manera colectiva. Esto implica compartir conocimientos, recursos y mejores prácticas, así como establecer mecanismos de supervisión y control a nivel global.

Sin embargo, no debemos caer en el pesimismo extremo. Aunque es necesario ser conscientes de los riesgos asociados con la IA, también debemos reconocer su enorme potencial para impulsar avances positivos en nuestra sociedad. La clave está en encontrar un equilibrio adecuado entre el progreso y la seguridad.

En última instancia, el planteamiento presentado en el artículo nos invita a reflexionar sobre nuestro papel como creadores de la IA. Debemos ser responsables y considerar las implicaciones a largo plazo de nuestras acciones. Es fundamental que nos preparemos para los posibles escenarios futuros y trabajemos juntos para garantizar que la IA se desarrolle de una manera que beneficie a la humanidad en su conjunto.