En los últimos años, las animaciones generadas por computadora de animales y humanos se han vuelto cada vez más detalladas y realistas. Sin embargo, producir animaciones convincentes de la cara de un personaje mientras habla sigue siendo un desafío clave, ya que generalmente implica la combinación exitosa de una serie de diferentes elementos de audio y video.

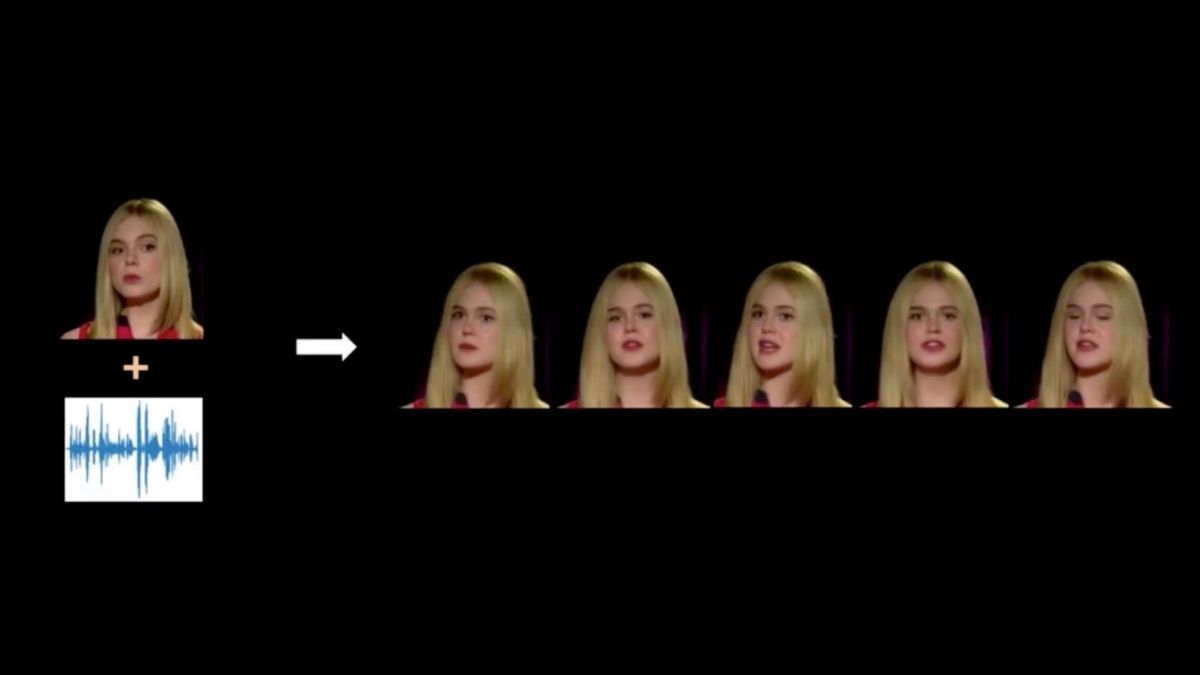

Siguiendo una lógica similar a la de los ya conocidos deepfakes, un nuevo modelo de IA diseñado por científicos informáticos de la India puede utilizarse para integrar grabacione de audio con los movimientos de una cabeza. Esta tecnología podría usarse para crear avatares virtuales, asistentes digitales y películas animadas más convincentes.

Animación realista de rostros en base a un audio con voz

«Para una experiencia de visualización agradable, la percepción del realismo es de suma importancia, y a pesar de los recientes avances de la investigación, la generación de una cara parlante realista sigue siendo un problema de investigación desafiante», comentó a TechXplore Brojeshwar Bhowmick, uno de los investigadores que a cargo a cabo el estudio. «Junto con la sincronización precisa de labios, la animación realista de la cara parlante requiere otros atributos de realismo, como parpadeos naturales de los ojos, movimientos de la cabeza y preservación de la información de identidad de las caras objetivo arbitrarias».

La mayoría de los métodos basados en el habla existentes para generar animaciones faciales se centran en garantizar una buena sincronización entre los movimientos de los labios y el habla grabada, preservar la identidad de un personaje y garantizar que ocasionalmente parpadee. Algunos de estos métodos también intentaron generar movimientos convincentes de la cabeza, principalmente emulando los realizados por hablantes humanos en un breve video de entrenamiento.

«Estos métodos derivan el movimiento de la cabeza del video de conducción, que puede no estar correlacionado con el contenido actual del discurso y, por lo tanto, parece poco realista para la animación de discursos largos», dijo Bhowmick. «En general, el movimiento de la cabeza depende en gran medida de la información prosódica del discurso en una ventana de tiempo actual», agregó.

Estudios anteriores han encontrado que existe una fuerte correlación entre los movimientos de la cabeza realizados por los hablantes humanos y tanto el tono como la amplitud de su voz. Estos hallazgos inspiraron a Bhowmick y sus colegas a crear un nuevo método que puede producir movimientos de cabeza para animaciones faciales que reflejan la voz de un personaje y lo que la persona está diciendo.

En uno de sus artículos anteriores, los investigadores presentaron una arquitectura basada en la red generativa adversarial (GAN) que podría generar animaciones convincentes de caras hablando. Si bien esta técnica era prometedora, solo podía producir animaciones en las que la cabeza de los altavoces no se moviera.

«Ahora desarrollamos una línea completa de animación facial realista impulsada por el habla que genera videos de caras parlantes con sincronización de labios precisa, parpadeos naturales de los ojos y movimiento realista de la cabeza, al idear un enfoque jerárquico para el aprendizaje desenredado del movimiento y la textura», dijo Bhowmick. «Aprendemos el movimiento inducido por el habla en los puntos de referencia faciales y usamos los puntos de referencia para generar la textura de los fotogramas de video de animación», también señaló.

El nuevo modelo generativo creado por Bhowmick y sus colegas puede generar de manera efectiva movimientos de cabeza realistas y guiados por el habla para caras parlantes animadas, que están fuertemente correlacionadas con las características vocales de un hablante y lo que esa persona está diciendo. Al igual que la técnica que crearon en el pasado, este nuevo modelo se basa en GAN, una clase de algoritmos de aprendizaje automático que se ha encontrado que es muy prometedora para generar contenido artificial.

Bhowmick y sus colegas evaluaron su modelo en una serie de conjuntos de datos de referencia, comparando su rendimiento con el de las técnicas de vanguardia desarrolladas en el pasado. Descubrieron que podía generar animaciones altamente convincentes con una excelente sincronización de labios, parpadeos naturales de los ojos y movimientos de cabeza coherentes con el habla.

El modelo puede identificar de qué está hablando un hablante y la entonación de su voz durante ventanas de tiempo específicas. Posteriormente, utiliza esta información para producir movimientos de cabeza coincidentes y correlacionados.