Google está trabajando en una nueva iniciativa basada en IA, junto con la organización Guiding Eyes for the Blind, que tiene como objetivo ayudar a personas con baja visión a tener independencia al ejercitarse o participar en una carrera.

Utilizan dinámicas basadas en inteligencia artificial que guían a estas personas sin necesidad de recurrir a bastones o perros guías. Este proyecto, llamado Project Guideline, aún está en fase beta pero ya cuenta con resultados asombrosos.

Así funciona la IA de Google para ayudar a personas con baja visión

Ya hemos comentado diferentes proyectos de Google que ayudan a personas ciegas o con poca visión a ganar independencia. Proyectos que facilitan que los usuarios puedan desplazarse con libertad en sus actividades cotidianas, sin necesidad de depender de otras personas.

Ese mismo objetivo tiene Project Guideline, pero con la idea central de ayudar a los usuarios a entrenarse o correr de forma independiente utilizando el potencial del aprendizaje automático.

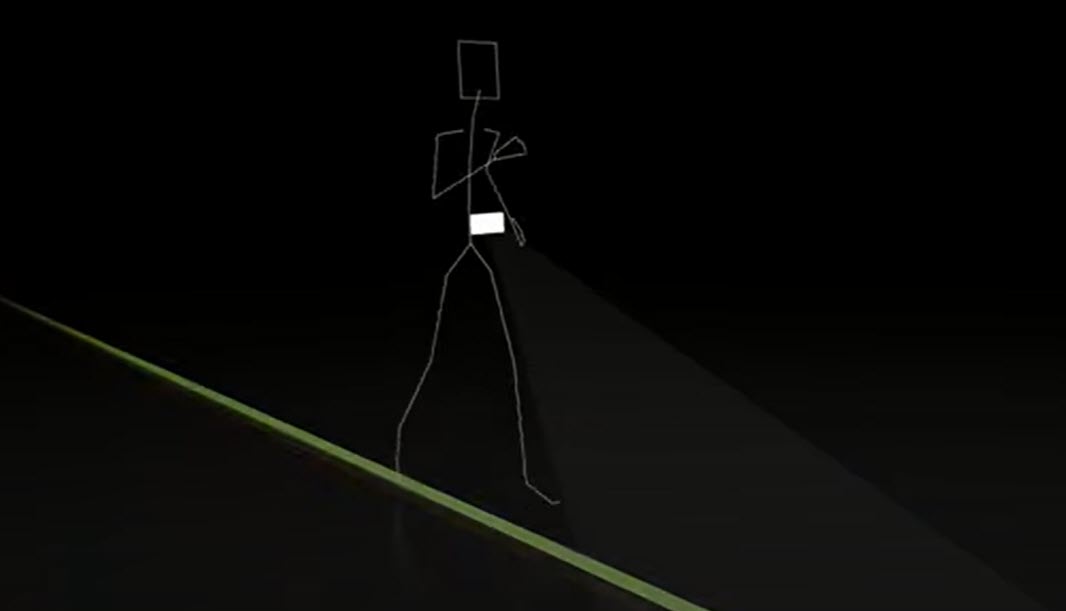

Dicho de manera simple, la dinámica que proponen es utilizar una pintada en la calle como guía, un dispositivo móvil que funcione “como ojos” identificando la línea pintada y señales auditivas que alerten al usuario cuando se desvía de su camino. Y por supuesto, un modelo de aprendizaje automático que da vida a este concepto.

Para aplicar la dinámica que propone Google, el corredor solo necesita llevar consigo tres cosas: un arnés especial sujeto a la cintura, auriculares de conducción ósea y su dispositivo Android. Y por otro lado, una guía pintada en la zona donde va a desplazarse para poner en funcionamiento esta dinámica.

Para trabajar con el móvil como aliado, se instala la aplicación de Project Guideline que usará la cámara del dispositivo y el GPS para rastrear la carrera. Utilizando la cámara del móvil como ojos, se podrá ver si el usuario está en la ruta establecida siguiendo la guía o si se está alejando de ella. Cuando eso suceda, la app emitirá señales de audio al usuario, con sonidos más fuertes en el lado que se está desviando.

Po ejemplo, si se desplaza hacia la izquierda, el sonido emitido sería más fuerte en el oído izquierdo. Podemos ver un ejemplo de esta dinámica en funcionamiento en este vídeo:

Y por supuesto, se tuvieron en cuenta diferentes detalles para sea funcional en diferentes contextos, por ejemplo, que este sistema funcione sin conexión a internet y aún en condiciones meteorológicas desfavorables.