La computación cuántica ha captado la atención de grandes empresas del rubro tencológico, dado su amplio potencial para el desarrollo de tareas a una escala difícil de conseguir con ordenadores tradicionales.

En una investigación recientemente publicada, Thomas Fischbacher y Luciano Sbaiz, investigadores de Google, presentaron un método que utiliza recursos y técnicas de computación cuántica para clasificar imágenes de 28 píxeles por 28 píxeles, iluminadas por un solo fotón.

Antes de entrar en los detalles de este avance, si no te encuentras familiarizado con algunos conceptos de la computación cuántica, tenemos una cápsula introductoria disponible en nuestro canal de YouTube.

Recapitulando la novedad, a través de este mecanismo de clasificación de imágenes, mediante el que se transforma el estado cuántico de aquel único fotón presente, se demostró que se puede obtener, por lo menos, un 41,27% de precisión al trabajar con bases de datos MNIST, utilizadas comúnmente para entrenar sistemas de procesamiento de imágenes. Esto constituiría una mejora del rendimiento en un 21,27%, comparado con las herramientas informáticas clásicas.

El modelo considera la máxima precisión de clasificación alcanzable si un algoritmo debe tomar una decisión después de detectar el paso del primer «cuanto» de luz (es decir, un fotón), siguiendo una dinámica similar a la de una pantalla LCD que revela una imagen, pero esta vez aplicada a un conjunto de datos.

Siguiendo modelos tradicionales de trabajo con bases de datos MNIST, la computación más clásica puede como mucho detectar un fotón que aterriza en uno de los píxeles de la imagen y adivinar el dígito de la distribución de la intensidad de la luz, que se obtiene al cambiar la escala del brillo de cada imagen a una unidad de suma.

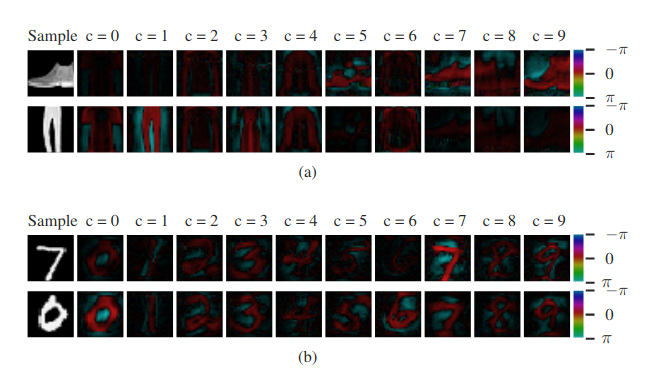

En cada fila, la primera imagen muestra la probabilidad de muestra original y las siguientes imágenes muestran las amplitudes de probabilidad para cada clase

El cambio de paradigma que ofrece esta solución de mecánica cuántica, se basa en un mecanismo que emplea divisores de haz, cambiadores de fase y otros elementos ópticos, para crear un patrón de inferencia similar a un holograma. El área del patrón de inferencia en la que se ubica el fotón puede utilizarse para dar a conocer la clasificación de la imagen.

Una conclusión que destaca entre lo demostrado con esta investigación es que no es requisito iluminar una escena con muchos fotones simultáneamente para producir interferencia. «Conceptualmente, explotar la interferencia para mejorar la probabilidad de que un experimento cuántico produzca el resultado buscado es la idea esencial que subyace a toda la computación cuántica», señalaron los investigadores en su publicación, donde destacaron que los avances compartidos se publicaron en términos comprensibles para todo experto del área, con la capacidad de extrapolarse a otros campos más allá de la investigación, como la enseñanza de la física.

La computación cuántica está perfilada para continuar siendo un gran aliado de los avances que surjan en torno a la inteligencia artificial y el aprendizaje automático. Asi lo hemos visto durante el útlimo tiempo y al parecer, la dirección continuará orientada hacia el mismo sentido. Su irrupción en el ultimo tiempo ha abierto un mundo de nuevas posiblidades de desarrollo de nuevas iniciativas y principalmente, ha fomentado la investigación. Sin embargo, dados los costos asociados, trabajos de esta envergadura pueden ser presumidos por muy pocos en la actualidad.

Este trabajo, según sus investigadores tiene como fin dar a conocer cómo la tecnología cuántica puede tender una mano para resolver algunos problemas haciendo uso de la IA. Puedes encontrar todos los detalles de la investigación en el documento publicado por sus autores con sus hallazgos.