En el campo de la medicina es notable resaltar como la tecnología ha estado haciendo posible el desarrollo de recursos y herramientas cada vez más sofisticadas para optimizar el trabajo realizado por el personal sanitario que labora en los hospitales.

Incluso la realidad virtual ha estado siendo usada como medio para facilitar el aprendizaje de los estudiantes de medicina en lo que concierne a realizar cirugías.

Enfocándose en esta área, investigadores de Google Brain, UC Berkeley e Intel AI Lab unieron esfuerzos para llevar a cabo el desarrollo de Motion2Vec, un modelo de IA dotado con la capacidad para obtener conocimientos relacionados con la realización de tareas de cirugía robótica, tales como suturar, pasar e insertar agujas y atar nudos. Todo esto, como parte del entrenamiento proporcionado por un vídeo de cirugía.

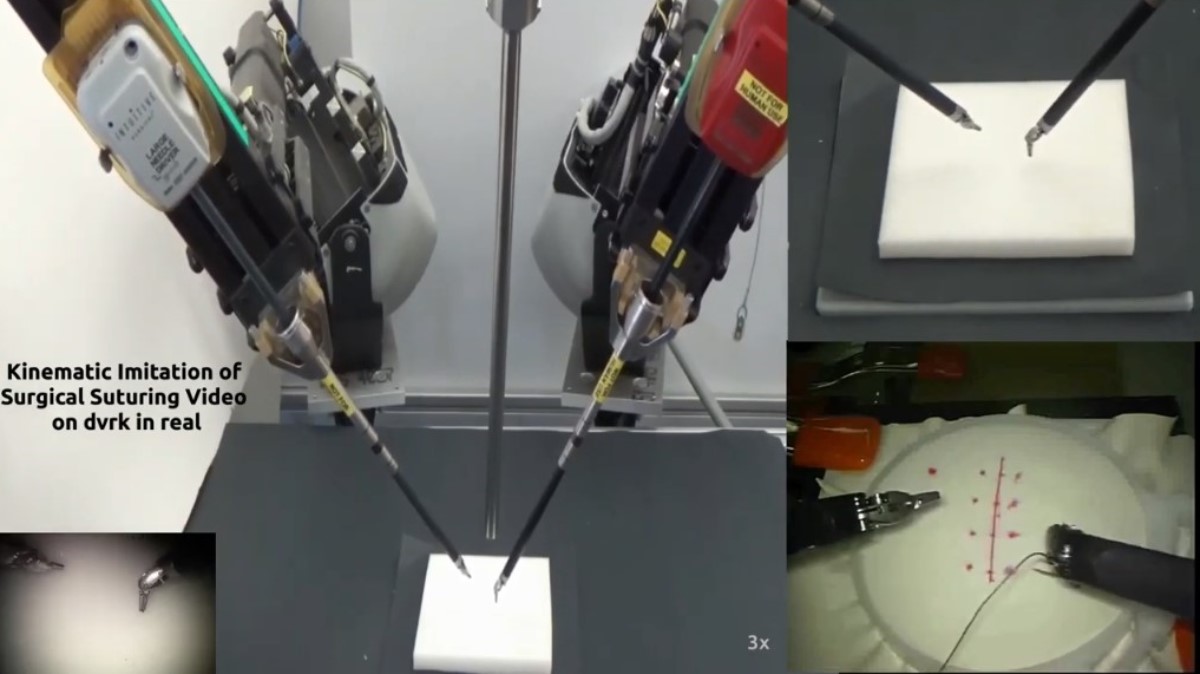

Como una manera de poner a prueba los resultados, los investigadores se dispusieron a implementar el modelo en un robot Da Vinci de dos brazos, el cual pasaba la aguja a través de un trozo de tela en el laboratorio.

Es así como Motion2Vec constituye un algoritmo de aprendizaje de representación que es sometido a entrenamiento mediante el uso de aprendizaje semisupervisado, siguiendo así el mismo patrón de comportamiento aplicado en modelos anteriores como Word2Vec y Grasp2Vec.

Por otra parte, los investigadores expresaron que su trabajo es una muestra de cómo la robótica de video usada en cirugía puede llevarse a un nivel superior, sustentándola con videos de demostración de expertos. Esto, como una manera de proporcionar conocimientos para la adquisición de nuevas habilidades de manipulación robótica.

Respecto a esto, los investigadores publicaron en su artículo lo siguiente

Los resultados sugieren una mejora del rendimiento en la segmentación con respecto a las líneas de base de última generación, al tiempo que se introduce la imitación de la pose en este conjunto de datos con un error de cm 0:94 en la posición por observación respectivamente.

Entrenamiento del Motion2Vec

En cuanto a los detalles acerca de Motion2Vec, estos fueron publicados la semana pasada en el repositorio de preimpresión arXiv, siendo presentados luego en la conferencia internacional de robótica y automatización (ICRA) a cargo del IEEE.

Para el entrenamiento del algoritmo fueron usados vídeos en donde se mostraban 8 cirujanos humanos controlando los robots Da Vinci. Estos vídeos fueron obtenidos del conjunto de datos de JIGSAWS, siglas usadas para hacer referencia al Conjunto de Trabajo de Evaluación de Gestos y Habilidades de la JHU-ISI, proyecto formado por vídeos de la Universidad John Hopkins (JHU por sus siglas en ingles) y de Intuitive Surgery, Inc (ISI).

Estos vídeos de JIGSAWS mostraron al Motion2Vec representaciones enfocadas en el movimiento de las habilidades de manipulación mediante el aprendizaje por imitación.

En referencia a esto, el artículo señala lo siguiente

«Utilizamos un total de 78 demostraciones del conjunto de datos de sutura […]El estilo de sutura, sin embargo, es significativamente diferente en cada cirujano»