En la categoría de utilidades para sitios web ya os he comentado varias aplicaciones que podemos usar para crear y configurar archivos htaccess, algo fundamental para que nuestra web se comporte de forma correcta ante cualquier circunstancia. Ahora le ha tocado el turno a otro archivo no menos importante: robots.txt.

Robots.txt checker se encarga de analizar el archivo de cualquier sitio web, comprobando si tiene la estructura correcta y avisando en caso de que se encuentre algún error que pueda perjudicar a la lectura de nuestra web por parte de los diferentes buscadores.

Muy recomendable para ampliar nuestros conocimientos sobre un tema que afecta a todos los que vivimos creando proyectos en la web.

En ese error del post., cual fue la solucion??

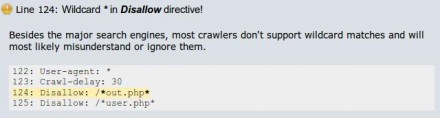

en la imagen no se muestra un error, sólo un aviso informando que no todos los robots consiguen entender lo que significa el asterisco.