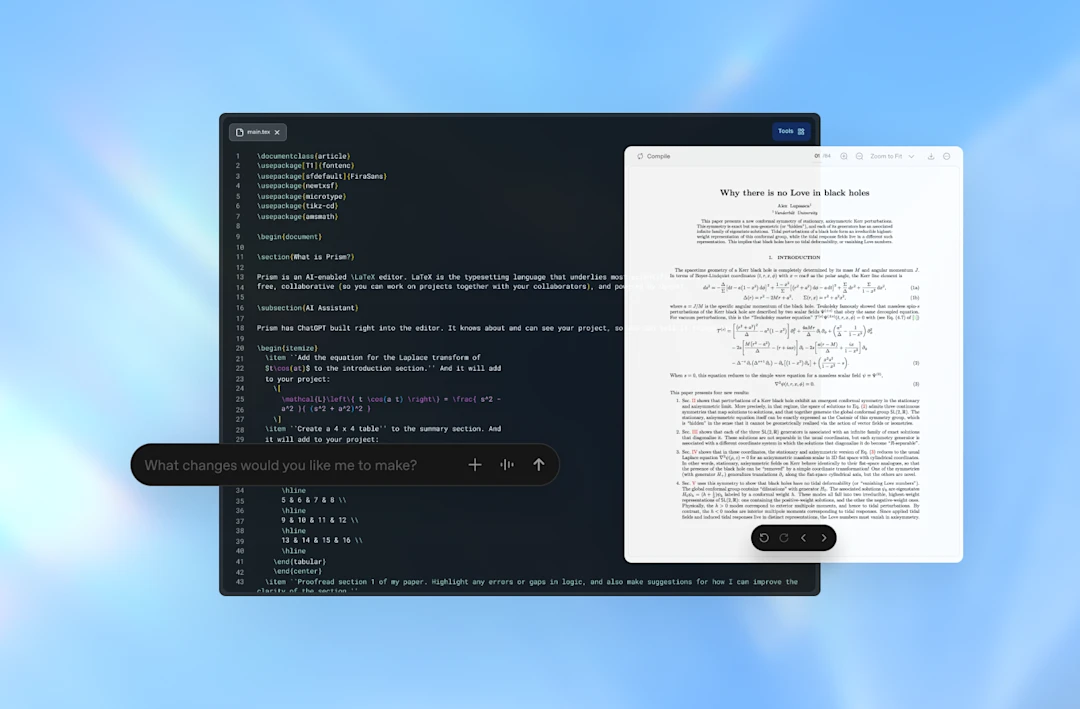

OpenAI ha presentado Prism, un espacio de trabajo pensado para la escritura científica y la colaboración entre investigadores, con GPT-5.2 integrado de forma nativa. Según la compañía, cualquiera con una cuenta personal de ChatGPT puede usarlo gratis desde una aplicación web, con proyectos y colaboradores ilimitados, y con la promesa de llevarlo más adelante a planes Business, Enterprise y Education. La idea no es que la herramienta “haga ciencia” por su cuenta, sino que quite fricción a tareas que suelen comerse horas: redactar, revisar, coordinar coautores, manejar LaTeX, mover citas, ajustar ecuaciones y preparar el manuscrito para publicación. La propuesta recuerda a lo que ha pasado en programación con entornos tipo Cursor o Windsurf, pero trasladado al ritual de escribir un paper. La noticia fue contada por TechCrunch y ampliada en el anuncio oficial de OpenAI, que insiste en el mismo mensaje: menos saltos entre herramientas, más continuidad mental. Continúa leyendo «Prism: el bloc de notas con IA que OpenAI quiere llevar a los laboratorios»

La “música de ascensor” visual: cómo la IA generativa puede aplanar la cultura cuando se alimenta de sí misma

Los sistemas de IA generativa se han convertido en una fábrica de imágenes, textos y sonidos a una velocidad que ningún creador humano puede igualar. Su truco, explicado sin mística, consiste en aprender patrones a partir de enormes colecciones de contenido hecho por personas, recopilado de internet y otras fuentes. El detalle inquietante es qué ocurre cuando ese material humano deja de ser el ingrediente principal y el sistema empieza a cocinar con sobras: datos sintéticos generados por otras IA, una y otra vez, como quien recalienta el mismo plato hasta que pierde sabor.

Esa idea, que hasta hace poco sonaba a teoría, está tomando forma con evidencias experimentales. Varios trabajos previos ya habían advertido que entrenar modelos con contenido generado por modelos puede degradar su calidad con el tiempo, como si el sistema se “desenfocara” por mirar demasiadas veces una copia de una copia. La pregunta cultural es igual de seria: si la red se llena de contenido automatizado y los modelos se alimentan de ese material, ¿qué pasa con la diversidad creativa? Continúa leyendo «La “música de ascensor” visual: cómo la IA generativa puede aplanar la cultura cuando se alimenta de sí misma»

Un PC gaming premontado vuelve a tener sentido cuando la RAM se dispara

Comprar componentes por separado suele ser la forma favorita de montar un equipo a medida, pero hay un detalle que está torciendo la balanza: el precio de la memoria. Si has estado mirando DDR5 últimamente, es fácil entender por qué a mucha gente le empieza a picar la curiosidad por los sobremesa premontados. Es como cuando vas al supermercado a por ingredientes para cocinar y descubres que el pack “menú completo” cuesta menos que comprar cada cosa por tu cuenta.

En esa lógica encaja una oferta que ha destacado The Verge: Costco está rebajando un sobremesa orientado a PC gaming que, por especificaciones, se sitúa en gama alta. No es el típico equipo “para jugar a 1080p con ajustes medios”; la configuración apunta a quien quiere potencia sostenida, margen para juegos exigentes y una base sólida para muchos años. Continúa leyendo «Un PC gaming premontado vuelve a tener sentido cuando la RAM se dispara»

NASA y el Webb afinan el “mapa invisible” del cosmos: nuevas pistas sobre cómo la materia oscura moldea el universo

La materia oscura tiene fama de fantasma cósmico: no emite luz, no la refleja, no la absorbe y tampoco la bloquea. Si fuera un objeto cotidiano, sería como el aire en una habitación: no lo ves, pero su presencia se delata por lo que mueve y por cómo cambia el entorno. En el universo, ese “aire” se manifiesta con gravedad, y esa gravedad deja huellas medibles. Con datos del telescopio espacial James Webb (JWST), un equipo liderado por la astrofísica Diana Scognamiglio, del Jet Propulsion Laboratory (JPL) de la NASA, ha producido uno de los mapas de materia oscura más detallados y nítidos logrados hasta ahora, publicado en Nature Astronomy.

La idea central es potente por sencilla: si no puedes fotografiar directamente una sustancia, observa cómo deforma el escenario. El equipo ha reconstruido la distribución de materia oscura como una especie de “andamiaje” que sostiene y guía a la materia ordinaria: gas, polvo, estrellas y galaxias. Según describen, la nueva cartografía gana nitidez respecto a mapas anteriores: no es solo un “más de lo mismo”, sino un salto en resolución que permite ver grumos y filamentos con mayor claridad, como pasar de una imagen desenfocada a otra donde los bordes y las texturas por fin encajan. Continúa leyendo «NASA y el Webb afinan el “mapa invisible” del cosmos: nuevas pistas sobre cómo la materia oscura moldea el universo»

Maia 200: el nuevo chip de IA de Microsoft se mide con Amazon y Google

Microsoft vuelve a mover ficha en el tablero del hardware para inteligencia artificial con Maia 200, el sucesor de su primer acelerador interno, Maia 100. Según ha contado Tom Warren en The Verge y confirma la propia compañía, el despliegue empieza hoy, 26 de enero de 2026, en los centros de datos de Microsoft. El contexto es claro: entrenar y ejecutar modelos cada vez más grandes exige una potencia que ya no se puede “comprar en el supermercado” con la misma facilidad de hace unos años. Tener un chip propio no es solo una cuestión de orgullo tecnológico; es como tener cocina industrial en un restaurante con mucha demanda: te permite controlar mejor costes, tiempos y capacidad, en lugar de depender siempre del proveedor de fuera. Continúa leyendo «Maia 200: el nuevo chip de IA de Microsoft se mide con Amazon y Google»

Un “chequeo técnico” del ADN en jóvenes: el piloto australiano que destapa riesgos ocultos de cáncer y corazón

La medicina preventiva suele funcionar como una ITV: se revisa algo cuando toca por edad, por antecedentes o cuando aparece una “luz de aviso” en forma de síntoma. El problema es que, en enfermedades hereditarias relevantes, esa luz puede encenderse tarde o no encenderse nunca hasta que el daño está hecho. Durante años, el acceso a pruebas genéticas en adultos ha dependido casi por completo de tener una historia familiar clara o un diagnóstico personal que justificara el estudio. Ese enfoque deja fuera a personas con variantes de alto riesgo que, por simple azar familiar o falta de información, no cumplen criterios.

Un estudio publicado en Nature Health analiza un piloto nacional australiano de cribado genómico poblacional en adultos jóvenes. La idea es directa: si existen variantes genéticas “accionables” con medidas preventivas claras, ¿por qué esperar a que el historial familiar sea lo bastante “ruidoso” o a que llegue la enfermedad? En lugar de buscar solo cuando el médico sospecha, se propone “pasar el radar” antes, cuando todavía hay margen para vigilar, ajustar hábitos o iniciar tratamientos. Continúa leyendo «Un “chequeo técnico” del ADN en jóvenes: el piloto australiano que destapa riesgos ocultos de cáncer y corazón»

Virus en microgravedad: lo que la Estación Espacial Internacional está enseñando sobre la terapia con fagos

En el laboratorio solemos imaginar la infección como una partida de ajedrez: el virus mueve, la bacteria responde, el virus se adapta, la bacteria contraataca. Ese pulso evolutivo existe en la Tierra, pero un equipo científico se llevó la partida a un tablero distinto: la microgravedad de la Estación Espacial Internacional. Lo que observaron es una versión alterada de esa pelea, con ritmos, reglas y atajos genéticos que no son los habituales en un matraz terrestre. El trabajo se centró en un dúo muy conocido por la biología molecular: el fago T7 y su huésped, E. coli. Continúa leyendo «Virus en microgravedad: lo que la Estación Espacial Internacional está enseñando sobre la terapia con fagos»

Oklo gana tracción en bolsa tras una mejora de recomendación y el empuje de un acuerdo nuclear ligado a Meta

La atención del mercado hacia Oklo no es nueva, pero a veces una sola nota de análisis funciona como ese empujón que hace que una conversación vuelva a la mesa. Según informó Barron’s, BofA Securities elevó su recomendación sobre la acción a “Comprar” desde “Neutral” y, al mismo tiempo, revisó al alza su precio objetivo hasta 127 dólares desde 111. El gesto tiene peso porque llega en un momento en el que el entusiasmo por la compañía convive con dudas muy concretas: no se cuestiona que la historia sea atractiva, se cuestiona el calendario y la ejecución.

En términos prácticos, una mejora de recomendación no convierte un proyecto en realidad de la noche a la mañana. Es más parecido a cuando un banco te preaprueba una hipoteca: no significa que ya tengas casa, pero sí que alguien ha revisado tu perfil y considera que el plan tiene coherencia si se cumplen ciertos pasos. En el caso de Oklo, el paso clave sigue siendo el mismo: demostrar que su camino hacia la comercialización puede sostenerse con acuerdos, financiación y avances regulatorios. Continúa leyendo «Oklo gana tracción en bolsa tras una mejora de recomendación y el empuje de un acuerdo nuclear ligado a Meta»

Un implante cerebral inalámbrico más pequeño que un grano de sal: cómo funciona el MOTE que registra neuronas durante un año

La neurotecnología lleva años persiguiendo una idea sencilla de decir y difícil de ejecutar: escuchar al cerebro sin estorbarle. Cuando metes un objeto en un entorno blando y vivo como el tejido cerebral, cualquier “cable rígido” o pieza grande se comporta como una ramita en gelatina: el movimiento natural del cuerpo hace que roce, tire o irrite. Por eso resulta llamativo lo que han presentado investigadores junto a colaboradores: un implante cerebral inalámbrico tan diminuto que puede posarse sobre un grano de sal y, aun así, registrar actividad eléctrica y enviarla al exterior sin cables ni batería durante más de un año en animales vivos.

El dispositivo se llama MOTE (microscale optoelectronic tetherless electrode), que puede traducirse como electrodo optoelectrónico microscópico sin “ataduras”. En tamaño, hablamos de unas 300 micras de largo por 70 micras de ancho, una escala comparable al grosor de un pelo humano en su dimensión más estrecha. Continúa leyendo «Un implante cerebral inalámbrico más pequeño que un grano de sal: cómo funciona el MOTE que registra neuronas durante un año»

¿Hemos inflado las cifras de microplásticos en el aire?

Los microplásticos se han convertido en ese “polvillo” moderno que parece colarse en todas partes: en el agua, en el suelo, en organismos vivos y también en el aire. La idea general no cambia: hay contaminación plástica dispersa por el planeta. Lo que sí podría estar cambiando es la magnitud de la cifra cuando hablamos de microplásticos atmosféricos. Un trabajo publicado el 21 de enero de 2026 en Nature, liderado por la científica ambiental Ioanna Evangelou (Universidad de Viena), sugiere que algunas estimaciones sobre cuántas partículas hay flotando podrían estar sobredimensionadas, incluso por varios órdenes de magnitud, si se comparan con lo que se está midiendo realmente en muestras ambientales.

Conviene subrayar el matiz: que ciertos estudios estén sobreestimando cantidades no equivale a que el problema sea menor o “inventado”. Evangelou lo plantea con prudencia: sigue habiendo microplásticos en la atmósfera, pero la ciencia necesita una forma más consistente de medirlos y de comparar resultados entre países, laboratorios y técnicas. Continúa leyendo «¿Hemos inflado las cifras de microplásticos en el aire?»