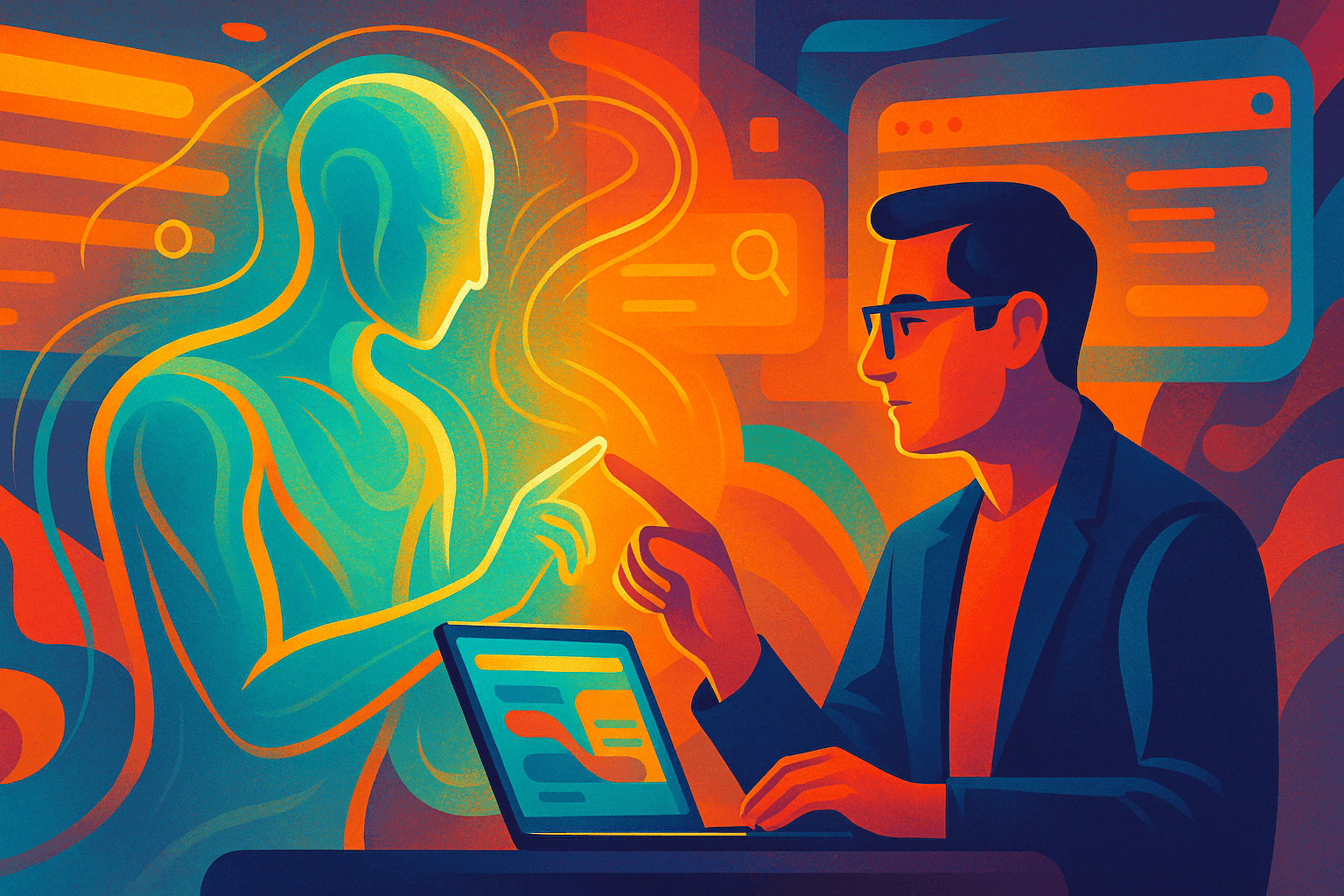

Google acaba de presentar Personal Intelligence, una función que permite que Gemini responda de forma más personalizada conectándose a información de tu cuenta, como Gmail, Google Photos, Search y tu historial de YouTube. La promesa suena muy tentadora: que el asistente deje de ser un “buscador con esteroides” y empiece a comportarse como alguien que entiende tu contexto y tus rutinas, sin que tengas que explicar cada detalle desde cero.

La idea central es sencilla: si el asistente puede mirar (con tu permiso) lo que ya existe en tus servicios de Google, puede darte respuestas más útiles y ajustadas. Es parecido a pedirle ayuda a una persona que ya conoce tus preferencias, tu calendario, tus viajes y tu forma de organizarte. La diferencia es que aquí ese conocimiento no viene de convivir contigo, sino de conectar fuentes digitales que ya has usado durante años.

Según Google, esta opción llega como beta en Estados Unidos, con un despliegue gradual para ciertos suscriptores de pago, y requiere opt-in: está desactivada por defecto y tienes que activarla de manera explícita. La compañía lo explica en un texto firmado por Josh Woodward, vicepresidente de Google Labs, Gemini y AI Studio, y también se ha comentado en medios como The Verge. Continúa leyendo «Gemini se vuelve más personal: así funciona “Personal Intelligence” y qué implica para tu privacidad»