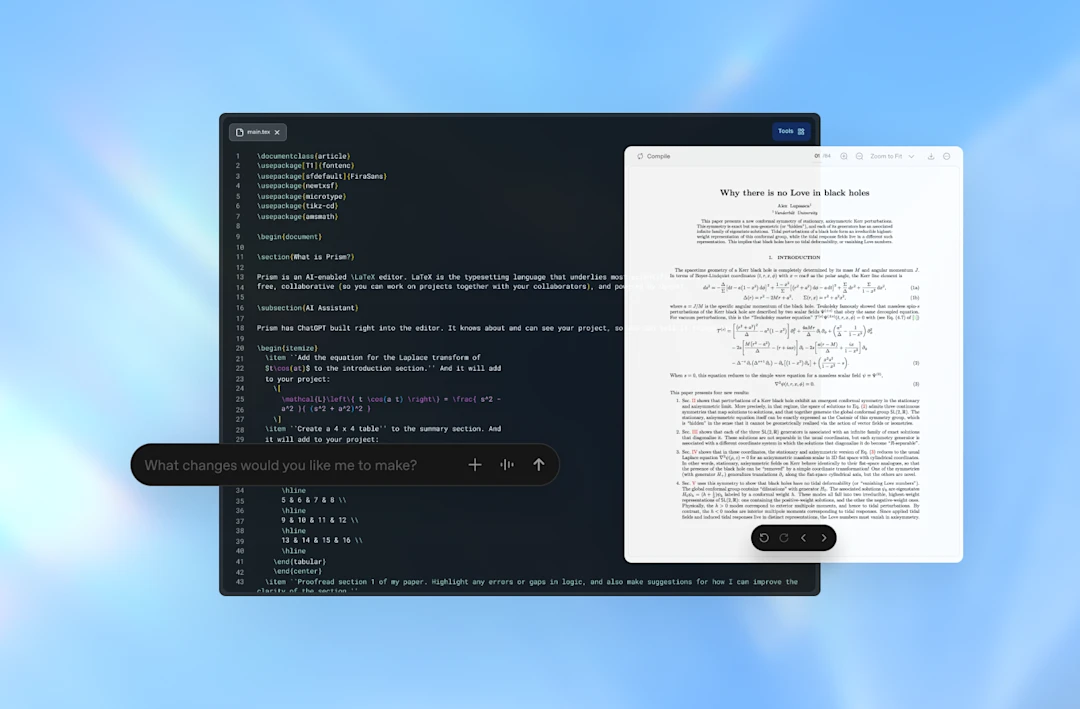

La escritura científica tiene algo de ritual: días enteros ajustando una frase para que sea precisa, persiguiendo una referencia que se resiste, comprobando que una ecuación no se ha roto por un símbolo mal puesto. En ese contexto, OpenAI ha presentado Prism, una herramienta gratuita que integra ChatGPT dentro de un editor de texto pensado para redactar papers. La noticia la adelantó MIT Technology Review, que la describe como una especie de “vibe coding” aplicado a la ciencia: la IA en primer plano, dentro del lugar donde realmente se trabaja, no como una pestaña aparte a la que se entra de vez en cuando.

El movimiento no surge de la nada. Según cifras citadas por la propia compañía, alrededor de 1,3 millones de científicos formulan más de 8 millones de consultas semanales a ChatGPT sobre temas avanzados de ciencia y matemáticas. La lectura que hace Kevin Weil, responsable de OpenAI for Science, es clara: la IA deja de ser curiosidad y empieza a convertirse en parte del flujo de trabajo. Si muchas personas ya “piensan en voz alta” con un chatbot, la siguiente jugada lógica es meter ese chatbot en el documento donde se redacta, se corrige y se entrega. Continúa leyendo «Prism, el editor con ChatGPT que quiere meterse en la cocina de los artículos científicos»