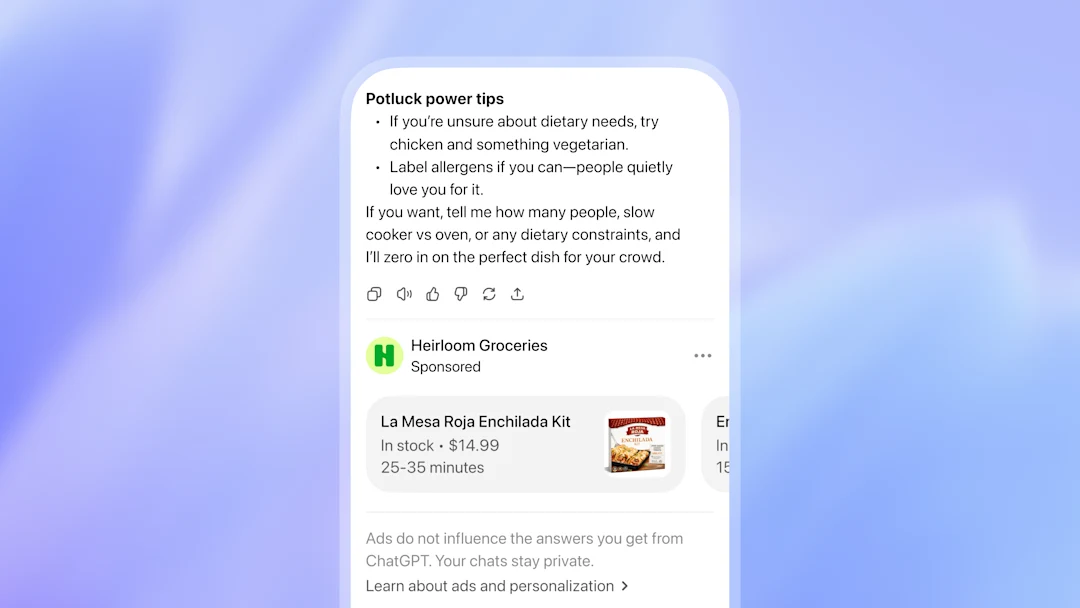

La decisión de introducir anuncios en ChatGPT ha encendido una discusión que mezcla dinero, ética y poder tecnológico. Según relató Futurism, hace un par de años Sam Altman, CEO de OpenAI, había descrito la publicidad como un “último recurso”. Ese marco mental sugería que el producto debía sostenerse por otras vías: suscripciones, acuerdos empresariales o licencias. El problema es que operar IA generativa es caro, y el sector entero busca una fórmula que no dependa de rondas eternas de inversión.

La noticia no quedó en una mera actualización de producto. Ha tenido una consecuencia simbólica de alto voltaje: la investigadora Zoë Hitzig anunció su renuncia a OpenAI en un ensayo publicado en The New York Times. Su postura no es la caricatura habitual de “publicidad igual a mal”. Reconoce que los anuncios no son, por definición, inmorales: si un servicio cuesta mucho, la publicidad puede ser una vía de ingresos legítima. Su preocupación está en el “cómo” y, sobre todo, en lo que ese “cómo” habilita dentro de una herramienta donde la gente confiesa cosas que no diría en público. Continúa leyendo «OpenAI y la llegada de la publicidad a ChatGPT: la dimisión de Zoë Hitzig reabre el debate sobre datos, confianza y modelos de negocio»