Google ha presentado Gemini 3.1 Pro como una actualización de la “inteligencia base” que impulsa sus avances recientes en razonamiento, incluida la familia Gemini 3 Deep Think. La idea es sencilla de explicar con una metáfora doméstica: si Gemini fuera una cocina, Deep Think sería el modo “alta cocina” para platos muy delicados; 3.1 Pro sería el nuevo fogón principal, más preciso y más estable para el día a día, pero capaz de subir la potencia cuando hace falta. Google lo posiciona como un modelo pensado para situaciones en las que “una respuesta simple no basta”, con mejoras de razonamiento que pretende trasladar a productos de consumo y a herramientas para desarrolladores.

La compañía no lo lanza como disponibilidad general todavía, sino en preview, con un mensaje implícito: quiere que el mercado lo pruebe en escenarios reales, detectar fricciones y seguir afinando áreas como los flujos de trabajo con agentes antes del despliegue completo.

Dónde se puede usar: del móvil a la nube empresarial

Una de las claves de este lanzamiento es el alcance. Google está desplegando Gemini 3.1 Pro en varios frentes a la vez. Para desarrolladores, aparece en Gemini API dentro de Google AI Studio, en Gemini CLI, en la plataforma de desarrollo agentivo Google Antigravity y en Android Studio. Para empresas, llega a Vertex AI y Gemini Enterprise. Para usuarios, se integra en la app de Gemini y en NotebookLM, con matices de disponibilidad ligados a los planes de suscripción.

En la práctica, esto importa porque reduce el “salto” entre experimentar y desplegar. Si un equipo prototipa un asistente interno en AI Studio, el camino natural hacia un despliegue con controles de empresa pasa por Vertex AI. Y si lo que se busca es productividad personal, NotebookLM se convierte en un escaparate claro del rendimiento del modelo al resumir, conectar notas y sostener el hilo con documentos extensos.

El gran gancho: razonamiento más fuerte y medible en benchmarks

Google destaca un salto importante en un benchmark especialmente comentado en la industria, ARC-AGI-2, centrado en resolver patrones lógicos nuevos. Según la compañía, Gemini 3.1 Pro alcanza un 77,1% verificado en esa prueba, y lo presenta como más del doble del rendimiento de Gemini 3 Pro.

Aquí conviene leer el dato con una actitud práctica. Un benchmark no garantiza que un modelo “se equivoque menos” en tu caso concreto, pero sí suele correlacionar con algo que los usuarios notan: cuando una tarea exige encadenar pasos mentales, mantener restricciones y no perderse en el camino, los modelos con mejor razonamiento tienden a “aguantar” mejor. Es el equivalente a pedirle a alguien que te ayude a montar un mueble: no basta con saber qué es un tornillo, hace falta seguir el manual sin saltarse pasos.

Pensar en tres marchas: niveles ajustables de “esfuerzo”

Varios análisis independientes han puesto el foco en un detalle que, para equipos de producto, puede ser tan relevante como los números: Gemini 3.1 Pro introduce un sistema de niveles de pensamiento ajustables. En vez de depender de un único “modo”, la propuesta permite elegir entre niveles de esfuerzo (por ejemplo, bajo, medio y alto) para equilibrar latencia, coste y calidad del razonamiento. VentureBeat lo describe como un efecto “Deep Think Mini”: con el nivel alto, el modelo se comportaría como una versión ligera del enfoque de razonamiento más intensivo.

Dicho sin jerga: es como conducir con distintas marchas. Para un trayecto corto, primera y segunda bastan; para subir un puerto de montaña, necesitas reducir y dejar que el motor trabaje. En una empresa, esto puede traducirse en algo muy concreto: un mismo endpoint para tareas rutinarias (resúmenes, clasificación) y para tareas difíciles (análisis, planificación), variando el “esfuerzo” según el caso.

“Inteligencia aplicada”: del texto a lo visual y lo interactivo

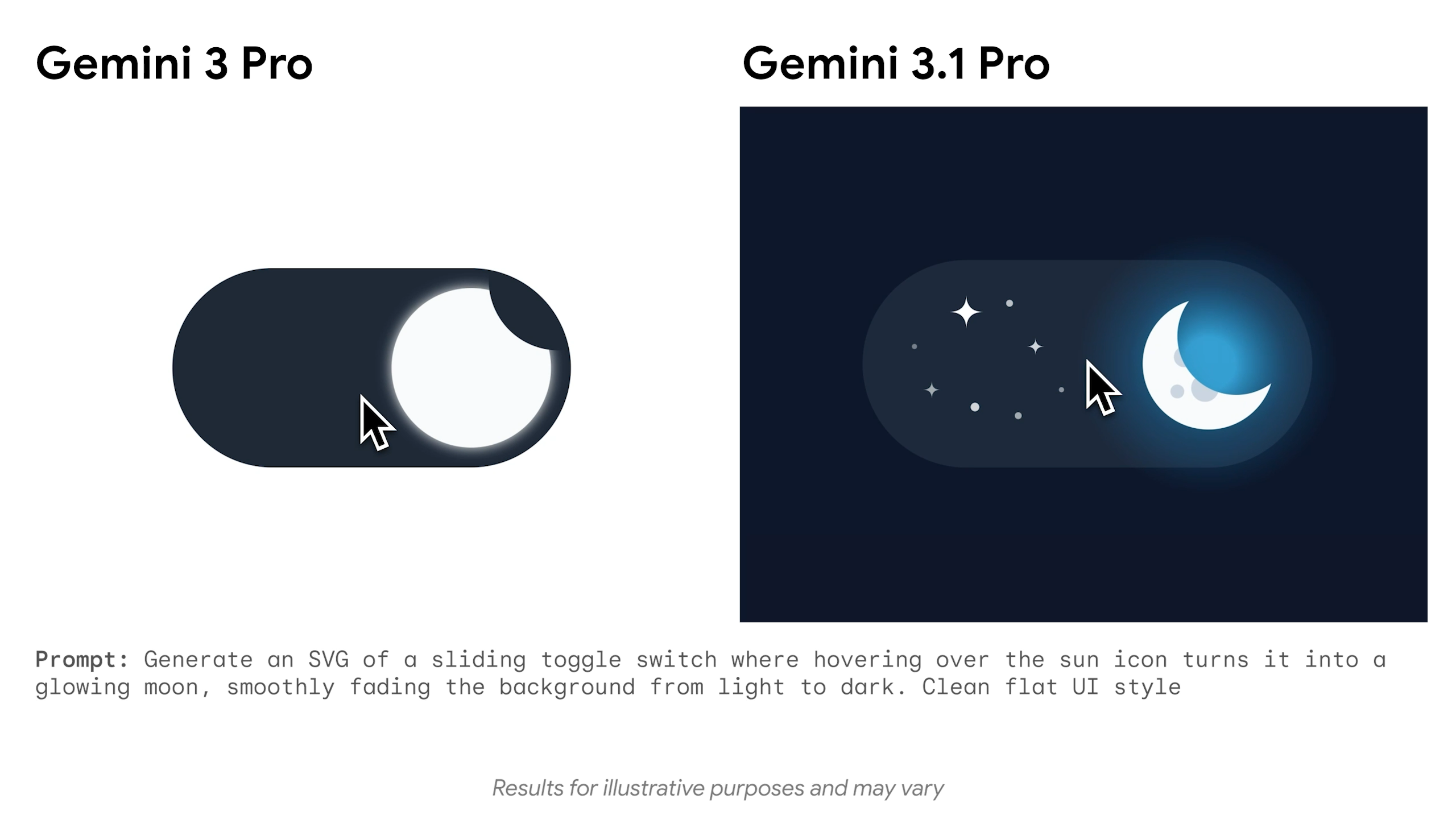

Google también insiste en el componente de utilidad. No se trata solo de responder preguntas, sino de convertir el razonamiento en artefactos que se puedan usar. Un ejemplo llamativo es la capacidad de generar SVG animados listos para web desde un prompt de texto: al ser código y no “píxeles”, el resultado escala sin perder nitidez y suele tener un tamaño de archivo menor que alternativas basadas en vídeo.

Para cualquiera que haya tenido que explicar una idea compleja en una reunión, esto se entiende rápido: es más fácil convencer con un esquema claro que con cinco párrafos densos. Si el modelo puede crear una visualización ligera y editable, el salto de “te lo explico” a “mira, aquí está” se acorta.

Agentes, herramientas y fiabilidad: lo que busca el mercado profesional

El discurso de Google alrededor de workflows agentivos sugiere una prioridad: que el modelo no solo “hable bien”, sino que ejecute pasos con herramientas de forma consistente. En la documentación para desarrolladores, la compañía menciona mejoras en el “thinking”, en la eficiencia y en una experiencia más grounded y consistente a nivel factual, con optimizaciones para comportamiento de ingeniería de software y para la ejecución fiable de tareas multi-paso con herramientas.

La diferencia entre un asistente simpático y uno útil en producción suele estar ahí. Un agente que consulta una API, interpreta el resultado, toma una decisión y deja un rastro auditable tiene que ser predecible. Si cada ejecución cambia de criterio sin aviso, el equipo termina poniendo “barandillas” por todas partes, y el ahorro de tiempo se diluye.

Estrategia de versiones: por qué “3.1” dice más de lo que parece

Que Google elija llamarlo 3.1 Pro y no otra preview numerada es un mensaje sobre cadencia. Sugiere un ritmo de mejoras más incremental y frecuente, más cercano al software tradicional que a los grandes saltos ocasionales. Algunos analistas lo interpretan como una señal de que la compañía quiere mover el listón de forma continua, especialmente en un contexto competitivo donde las comparaciones entre modelos cambian en cuestión de semanas.

Para un responsable de TI o de datos, esto implica otra adaptación: no basta con elegir “un modelo” y olvidarse. Hay que diseñar con la idea de sustitución rápida, pruebas A/B, evaluación interna y control de cambios, igual que se hace con cualquier componente crítico.

Lo que conviene vigilar al probarlo

Si estás pensando en evaluar Gemini 3.1 Pro, el punto de partida más sensato es tratarlo como una nueva “línea base” para tareas duras: razonamiento con restricciones, análisis que mezcla fuentes, generación de código con pruebas, o agentes que llamen herramientas. Y, al mismo tiempo, medir lo que de verdad importa en tu contexto: consistencia, coste por tarea, tasa de correcciones humanas y comportamiento con datos propios.

Google lo está empujando a lo largo de su ecosistema —de la app de Gemini a Vertex AI—, así que el resultado real dependerá de la integración y de los límites del plan o del entorno. El mensaje común es claro: Gemini 3.1 Pro quiere ser el modelo al que acudes cuando el problema no cabe en una respuesta rápida y necesitas que “piense” con más disciplina.