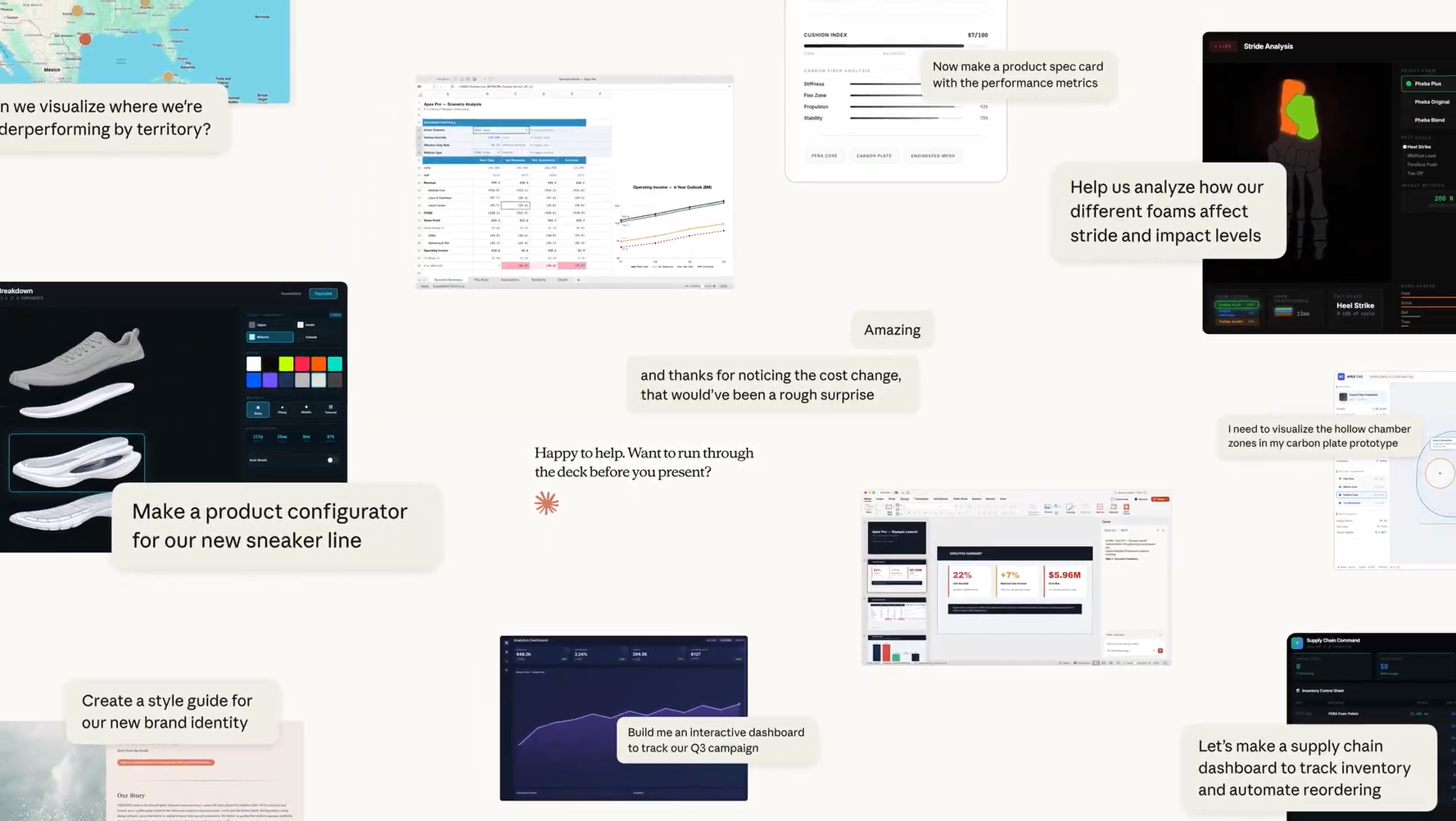

Anthropic presentó Claude Opus 4.6 como la evolución directa de Opus 4.5 y, por el enfoque del anuncio, el mensaje es nítido: mejoras prácticas para trabajo real. La compañía pone el foco en cuatro áreas que suelen marcar la diferencia cuando un modelo sale del “demo bonito” y entra en el día a día: programación, planificación, capacidad de sostener tareas agenticas durante más tiempo y un perfil de seguridad que, según sus evaluaciones internas, se mantiene al nivel de los modelos punteros del sector o incluso por encima.

En términos cotidianos, el salto no va solo de “responde mejor”, sino de “se comporta mejor cuando el problema no cabe en una pregunta corta”. Si has intentado que una IA entienda un repositorio grande, revise un PR con cambios dispersos o mantenga el hilo tras muchas iteraciones, sabes que el reto no es una respuesta brillante, sino la consistencia. Ahí es donde Anthropic sitúa el valor de esta versión.

Programación y trabajo en grandes bases de código

Uno de los puntos más repetidos en la comunicación de Anthropic es que Opus 4.6 se mueve con más fiabilidad en codebases grandes. Esto suele implicar varias mejoras a la vez: entender dependencias, no perder el contexto de decisiones previas y detectar efectos colaterales. La empresa menciona también avances en code review y debugging, con una idea interesante: el modelo “se pilla” más errores a sí mismo.

Para aterrizarlo, piensa en la diferencia entre un ayudante que te trae herramientas sueltas y otro que, mientras trabajas, te dice “ojo, si aprietas aquí, se afloja aquella pieza”. En software, esa “pieza” puede ser un test frágil, una función compartida o una configuración que nadie recuerda haber tocado. Si la promesa se cumple, el impacto se nota menos en el “hola mundo” y más en esas tardes largas donde los bugs parecen esconderse como calcetines perdidos.

Cuando la IA trabaja como un equipo: agent teams en Claude Code

Anthropic también anunció agent teams en Claude Code como “research preview”. La propuesta es que, en lugar de un único agente avanzando en serie, puedas lanzar varios subagentes que se reparten el trabajo y coordinan resultados, “como un equipo de ingeniería”. Esto encaja especialmente bien en tareas que se pueden dividir por lectura y análisis: revisar módulos distintos, buscar referencias cruzadas o mapear cómo viajan los datos por el sistema.

La metáfora aquí es sencilla: una persona leyendo un libro con post-its puede hacerlo bien; tres personas, cada una leyendo un capítulo distinto y reuniéndose al final, suelen encontrar más detalles en menos tiempo. El riesgo, claro, es la coordinación: que cada subagente entienda el objetivo común y no se quede en hallazgos aislados. Anthropic sugiere que la herramienta está pensada para que esa coordinación ocurra de forma autónoma, y que el usuario pueda “tomar el control” de un subagente cuando lo necesite.

Contexto gigante y memoria práctica: ventana de contexto de 1M tokens y context compaction

Una de las novedades más llamativas es la ventana de contexto de 1M tokens en la Claude Developer Platform, en beta, que Anthropic describe como la primera vez que un modelo de clase Opus llega a ese tamaño. En la práctica, esto permite trabajar con documentos y datasets enormes sin trocearlos con tanta agresividad. Si antes el flujo típico era “parte 1, parte 2, parte 3…”, la idea ahora es “tráeme la carpeta entera y dime qué importa”.

Aquí aparece un problema conocido: no basta con “meter mucho”, hay que usar ese mucho. Anthropic menciona el fenómeno de “context rot”, cuando la calidad se degrada al crecer la conversación, y presume mejoras en pruebas de “aguja en el pajar” a escala de 1M tokens. Es como tener una mesa de trabajo enorme: si está desordenada, el tamaño no ayuda; si hay método, encuentras rápido la pieza minúscula que buscabas.

Para sesiones largas, entra context compaction (beta), que resume y reemplaza contexto antiguo al acercarse a un umbral configurable. Es un mecanismo parecido a cuando, en una reunión extensa, alguien toma notas y decide qué decisiones quedan “cerradas” para liberar la cabeza del grupo. Bien usado, evita que las tareas agenticas se queden sin espacio antes de terminar.

Adaptive thinking y control de effort

Otra actualización relevante para desarrolladores es el paso de un “pensamiento extendido” con interruptor binario a un sistema con adaptive thinking y controles de effort. En lugar de obligar al modelo a pensar “a tope” siempre o nunca, se le permite decidir cuándo conviene razonar más profundo en función del contexto, manteniendo un nivel por defecto alto.

Anthropic introduce cuatro niveles de effort: low, medium, high (por defecto) y max. La lectura entre líneas es clara: más razonamiento puede mejorar resultados en tareas duras, pero cuesta en latencia y dinero. Es como conducir: en autopista puedes ir con control de crucero; en una calle estrecha, frenas, miras dos veces y avanzas con cuidado. Dar ese dial al desarrollador busca que no pagues “modo calle estrecha” cuando estás en autopista.

Benchmarks y pruebas en tareas reales

En su anuncio, Anthropic afirma que Opus 4.6 es “state-of-the-art” en varias evaluaciones, con menciones concretas a Terminal-Bench 2.0 para agentic coding y a Humanity’s Last Exam como prueba compleja de razonamiento multidisciplinar. También habla de liderazgo en BrowseComp, que mide la capacidad de encontrar información difícil en la web, y de rendimiento en GDPval-AA, una evaluación de tareas de trabajo con valor económico en dominios como finanzas y legal.

Un detalle interesante es la referencia explícita a Artificial Analysis como evaluador independiente de GDPval-AA. Anthropic dice que en esa métrica supera al “siguiente mejor modelo” por unos 144 puntos Elo y que gana a su predecesor por 190, traduciendo esa diferencia a una probabilidad de victoria aproximada del 70% en la comparación mencionada. En términos simples: no es una promesa abstracta, sino una forma de decir “si lo enfrentas muchas veces, suele salir ganando”.

El anuncio también menciona mejoras en recuperación en largo contexto y compara resultados en pruebas tipo MRCR v2, apuntando a menos “deriva” al manejar cientos de miles de tokens. Si esto se sostiene fuera del laboratorio, es un cambio relevante para investigación, análisis financiero y auditorías técnicas donde el detalle enterrado suele ser el que decide.

Seguridad y uso responsable en ciberseguridad

Anthropic insiste en que las mejoras de capacidad no se pagan con un deterioro de seguridad. Habla de baja tasa de conductas desalineadas en auditorías automatizadas, incluyendo engaño, complacencia extrema, refuerzo de delirios y cooperación con usos indebidos. También afirma que reduce “over-refusals”, cuando el modelo se niega a responder preguntas benignas.

Hay un bloque específico sobre ciberseguridad: al reconocer que el modelo es más capaz, dicen haber creado nuevas “probes” para detectar respuestas dañinas y que están impulsando usos defensivos, como ayudar a encontrar y parchear vulnerabilidades en software open source. La idea es parecida a mejorar las cerraduras cuando sabes que también has mejorado las ganzúas: si sube el nivel, deben subir los controles y el monitoreo, con ajustes continuos.

Oficina en la mira: Claude en Excel y Claude en PowerPoint

El anuncio no se queda en código. Anthropic menciona mejoras sustanciales en Claude en Excel y el lanzamiento de Claude en PowerPoint como “research preview”. La promesa en PowerPoint es especialmente concreta: leer layouts, fuentes y “slide masters” para mantenerse “on-brand”, ya sea creando desde una plantilla, reestructurando una narrativa o generando un deck desde una descripción.

Para mucha gente, esto suena menos glamuroso que un benchmark, pero puede ser más útil. Si Excel es la cocina donde limpias, cortas y organizas ingredientes (datos), PowerPoint es el plato que llega a la mesa. Si la IA entiende ambos espacios, el flujo se vuelve más directo: estructurar datos en una hoja, generar gráficos o conclusiones, y convertirlo en una historia visual coherente sin romper el estilo corporativo.

Disponibilidad, precios y lo que implica para equipos

Claude Opus 4.6 se anuncia disponible en claude.ai, en la API y en “plataformas cloud principales”. En el ecosistema de Anthropic suelen aparecer integraciones como Amazon Bedrock y Vertex AI de Google Cloud, lo que facilita adopción en entornos empresariales ya desplegados. Para desarrolladores, el modelo se identifica como claude-opus-4-6 en la API.

En precios, Anthropic afirma que se mantiene la tarifa de 5/25 dólares por millón de tokens (entrada/salida). Para prompts que superen 200k tokens, indica una tarifa “premium” con $10/$37,50 por millón en input/output. Señala también soporte de hasta 128k tokens de salida, útil cuando el resultado no es una respuesta breve sino un informe largo, una refactorización extensa o una batería completa de tests y documentación. Para cargas que requieren residencia, menciona US-only inference con un multiplicador de 1,1× en el precio por token.

Con todo esto, el retrato que dibuja Anthropic es el de un modelo que quiere ser menos “chat inteligente” y más “compañero de trabajo” capaz de aguantar sesiones largas, coordinar tareas como si fueran varios pares de manos y moverse con cuidado en terrenos sensibles como la ciberseguridad, sin obligar al usuario a pagar siempre el coste de pensar al máximo.