Los centros de datos hiperescalados para IA se están convirtiendo en el equivalente tecnológico de una refinería o una acería: instalaciones enormes, planificadas para trabajar sin descanso y orientadas a un objetivo muy concreto, entrenar y ejecutar modelos de lenguaje y otros sistemas de inteligencia artificial a escala descomunal. Donde antes imaginábamos “la nube” como algo etéreo, aquí toma forma de edificios mastodónticos que aparecen en polígonos industriales o en áreas rurales, buscando terreno, conexión eléctrica y permisos con la misma urgencia con la que una ciudad busca agua.

Según MIT Technology Review, esta nueva infraestructura no es solo una ampliación de lo ya conocido: es una especie distinta de supercomputación, diseñada alrededor de chips especializados, redes ultrarrápidas y sistemas de enfriamiento poco habituales fuera de la industria pesada.

Cómo se construye un superordenador del tamaño de un barrio

El corazón de estos complejos son cientos de miles de GPU (unidades de procesamiento gráfico), como las Nvidia H100, agrupadas en clústeres que trabajan sincronizados como si fueran un único cerebro. Si un ordenador tradicional fuese una persona resolviendo un problema paso a paso, estas GPU se parecen más a una cocina con decenas de fogones: muchas tareas ocurriendo en paralelo, cada una a alta temperatura, y todas coordinadas para que el plato salga a tiempo.

Para que esa “cocina” funcione, hace falta un sistema nervioso. En los centros hiperescalados, ese papel lo cumplen kilómetros y kilómetros de fibra óptica, enlazando los chips con latencias mínimas para que intercambien datos a gran velocidad. Y como ningún chef trabaja sin despensa, entra en juego el almacenamiento: sistemas gigantescos que alimentan a las GPU con datos de forma continua, porque en el entrenamiento de IA generativa el tiempo muerto es dinero quemándose.

Por qué se dispara el tamaño: leyes de escalado y demanda sin freno

La fiebre constructora se explica con dos fuerzas que se retroalimentan. La primera son las llamadas leyes de escalado: en términos sencillos, muchas técnicas de IA mejoran cuando se les da más datos, más parámetros y más cómputo. Es como entrenar para una maratón: con más horas de práctica y mejor nutrición, el rendimiento suele subir, aunque llega un punto en el que cada mejora cuesta mucho más esfuerzo.

La segunda fuerza es el uso cotidiano. La IA se está incrustando en productos y servicios de todo tipo, desde asistentes conversacionales hasta aplicaciones de bienestar o entretenimiento. Cuando millones de personas hacen preguntas, generan imágenes o piden resúmenes a la vez, la infraestructura que sostiene esa experiencia deja de ser “un centro de datos más” y pasa a parecerse a una red eléctrica paralela: tiene picos, requiere redundancia y no puede permitirse paradas largas.

En ese contexto, empresas como OpenAI, Google, Amazon, Microsoft y Meta están invirtiendo cifras astronómicas en capacidad de cómputo, y los gobiernos también están entrando en la carrera, impulsando infraestructura por motivos económicos y estratégicos, tal como recoge MIT Technology Review.

El precio de encender el cerebro: energía a escala de ciudad

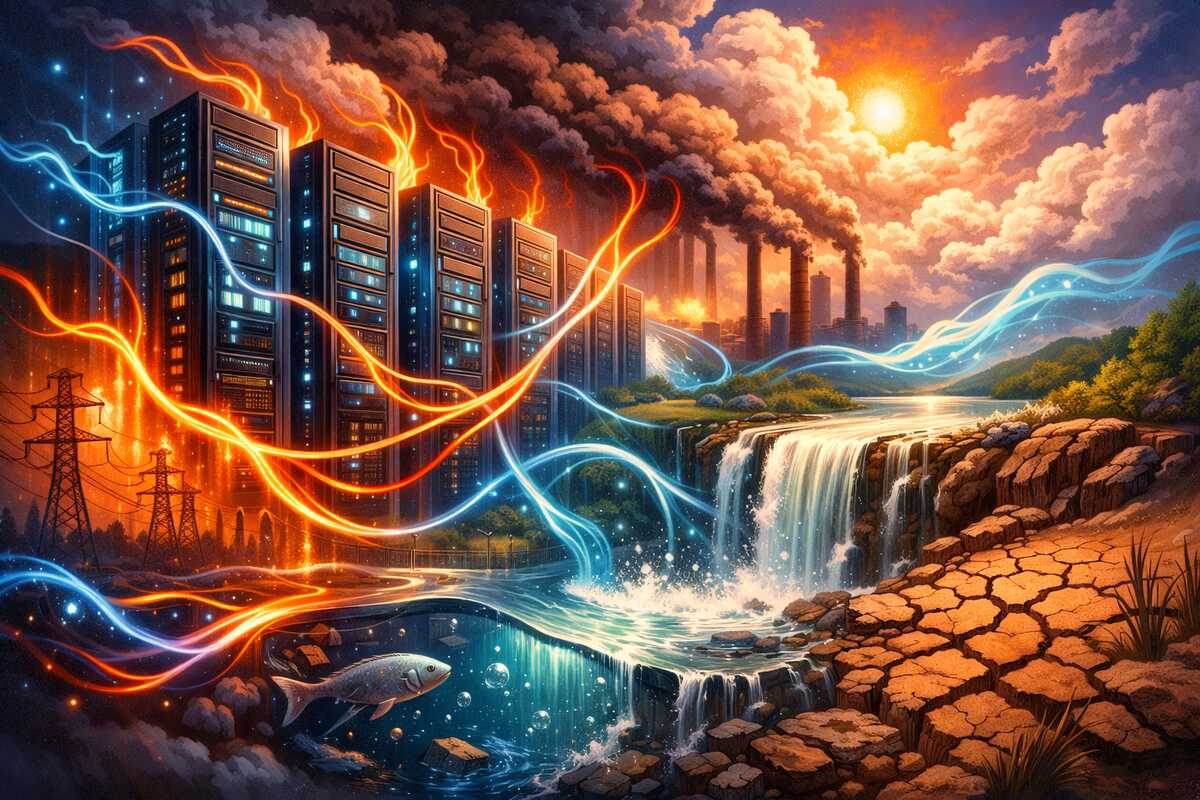

La potencia tiene un reverso inmediato: el consumo. Los mayores complejos en construcción pueden superar el gigavatio de demanda eléctrica, una cifra que compite con el consumo de ciudades enteras. Dicho de forma más tangible: es como conectar un barrio entero de hogares, oficinas y transporte… solo para mantener encendidas salas repletas de servidores.

El detalle incómodo está en el origen de esa electricidad. MIT Technology Review apunta que más de la mitad proviene de combustibles fósiles, mientras que las energías renovables cubren algo más de una cuarta parte. Eso significa que, incluso cuando una compañía compra certificados o firma contratos verdes, el sistema eléctrico real que alimenta la instalación puede seguir dependiendo de gas o carbón en muchos tramos, especialmente en regiones donde la red aún no se ha descarbonizado del todo.

La consecuencia no es solo climática. Cuando un gran consumidor entra en una red local, puede tensar precios y capacidad. En la práctica, la pregunta deja de ser “¿tenemos electricidad?” y pasa a ser “¿tenemos electricidad barata, estable y disponible las 24 horas?” Porque entrenar un modelo no se parece a cargar el móvil por la noche: es una demanda continua, exigente y poco flexible.

Refrigerar un horno: del aire al agua y a los baños de fluido

Concentrar tantas GPU tiene otro efecto: calor. Mucho calor. En estos centros, el aire acondicionado convencional se queda corto, como intentar enfriar una cocina industrial con un ventilador doméstico. Por eso se está imponiendo la refrigeración líquida: placas de agua fría pegadas a los chips o incluso inmersión en fluidos especiales que absorben y transportan el calor con gran eficiencia.

La industria explora ideas cada vez más agresivas: desde sistemas que aprovechan fuentes de agua cercanas hasta propuestas que, según se ha comentado en el sector, podrían llegar a usar agua de mar en ciertos diseños. El mensaje de fondo es claro: cuanto más densas son las salas de computación, más se parece el centro de datos a una planta industrial, con tuberías, intercambiadores térmicos y una gestión del calor que ya no es un “detalle de infraestructura”, sino el factor que decide si el proyecto es viable.

El impacto en la vida real: agua, ruido, aire y facturas

Cuando una instalación de este tamaño aterriza en una comunidad, los efectos se sienten más allá del empleo y los impuestos. Se habla de escasez de agua en lugares donde el recurso ya es delicado, de un zumbido constante por sistemas de ventilación y generadores, de contaminación del aire asociada a fuentes fósiles o a equipos de respaldo, y de la presión sobre la red eléctrica que puede empujar las facturas hacia arriba.

Aquí conviene una metáfora simple: es como si abrieran una fábrica que trabaja día y noche junto a una urbanización. Aunque la fábrica sea “digital”, su logística sigue siendo física: electricidad, agua, transporte, ruido, permisos y mantenimiento. Y si el coste de esa adaptación queda repartido en tarifas o inversiones públicas, la conversación social se vuelve inevitable, tal como sugiere MIT Technology Review al señalar que el público podría cargar con parte del coste durante años.

¿Qué alternativas se están barajando?

Ante esta tensión, las grandes tecnológicas están mirando distintas salidas. Una línea es asegurar suministro firme y bajo en carbono, de ahí el interés creciente por la energía nuclear como fuente estable. Otra apuesta es ampliar renovables con contratos a largo plazo, aunque el reto sigue siendo la intermitencia y la necesidad de red y almacenamiento para garantizar suministro continuo.

También aparecen ideas más futuristas, como la mención de Google a centros de datos alimentados por energía solar en el espacio, citada en el texto de MIT Technology Review. Más allá de lo llamativo, ese tipo de propuestas funciona como termómetro: si se verbaliza una opción tan extrema, es porque el cuello de botella energético se percibe como serio.

En paralelo, hay margen en eficiencia: mejores chips, modelos que requieran menos cómputo, técnicas para reutilizar calor, planificación para ubicar centros donde el agua y la energía sean más abundantes, y marcos regulatorios que exijan transparencia sobre consumo y fuentes. La clave es que ninguna medida por sí sola “arregla” el problema; se parece más a bajar el gasto del hogar combinando aislamiento, electrodomésticos eficientes y hábitos, no solo cambiando una bombilla.

El dilema de fondo: progreso rápido, infraestructura lenta

La IA avanza a ritmo de software, con ciclos de meses. La infraestructura avanza a ritmo de hormigón, con ciclos de años. Ese desajuste crea fricción: la demanda crece antes de que la red eléctrica y el suministro de agua puedan adaptarse, y las comunidades se convierten en el campo de pruebas de decisiones tomadas con urgencia.

Los centros de datos hiperescalados para IA son, al mismo tiempo, el motor del salto de capacidades que vemos en productos cotidianos y un recordatorio de que lo digital no flota en el aire. Entrenar modelos gigantes es una actividad industrial, con costes industriales. La conversación que viene no es solo tecnológica, también es energética y social: cuánto estamos dispuestos a consumir, quién paga la factura y cómo se reparten los beneficios.