En la era digital, gestionar grandes cantidades de datos de texto, imágenes y videos se ha vuelto crucial, no solo para empresas sino también para creadores individuales. Google, fiel a su visión de innovar en tecnologías de inteligencia artificial, ha introducido su Multimodal Embeddings API, una herramienta que promete revolucionar la forma en que interactuamos con diferentes tipos de datos. Desde WWWhatsnew, creemos que este avance marca un antes y un después en la búsqueda de información y organización de contenido.

¿Qué son los embeddings vectoriales?

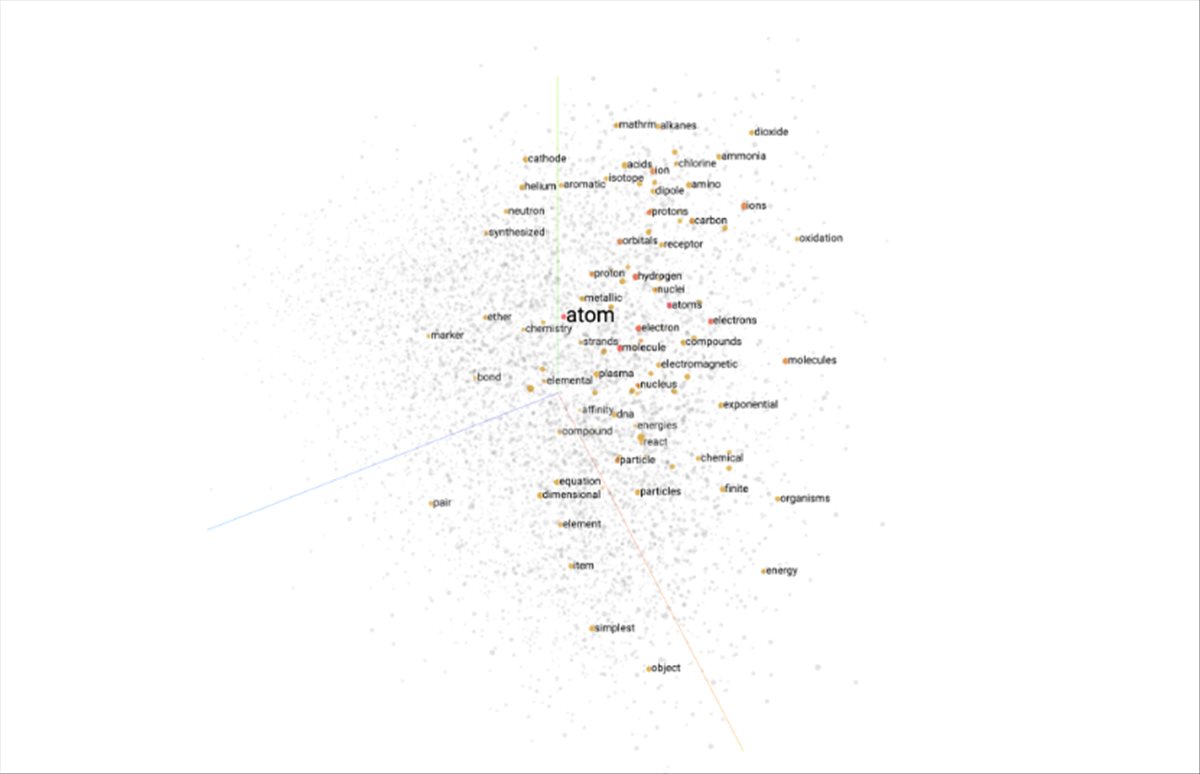

Imagina un mapa tridimensional en el que cada punto representa palabras, imágenes o incluso videos. Ahora, lleva esa idea a un espacio con más de mil dimensiones. Eso es, en esencia, lo que son los embeddings vectoriales: una forma de representar datos del mundo real en coordenadas matemáticas. Por ejemplo, herramientas como «word2vec» (introducida por Google en 2013) transformaron palabras en vectores numéricos, permitiendo a las máquinas entender relaciones semánticas, como que «rey» está relacionado con «reina».

La API Multimodal lleva esto un paso más allá, fusionando texto, imágenes y videos en un mismo espacio vectorial. Esto significa que una ilustración puede buscarse con palabras clave o un fragmento de texto puede relacionarse con videos relevantes.

Aplicaciones prácticas: Búsqueda visual para artistas

¿Por qué los artistas necesitan esto? Uno de los principales retos para creadores visuales es organizar y localizar su trabajo. Imagina a un ilustrador con cientos de bocetos digitales. Encontrar una pieza específica basándose en una idea vaga o una palabra clave puede ser un dolor de cabeza. Aquí es donde entra la Multimodal Embeddings API.

El equipo de Google desarrolló un prototipo para este escenario, tomando las ilustraciones de una diseñadora llamada Khyati. Subieron 250 ilustraciones a un proyecto Firebase, las convirtieron en vectores de 1408 dimensiones y crearon un sistema de búsqueda intuitivo basado en similitud visual. El resultado fue un sistema que no solo localizaba imágenes similares, sino que también relacionaba conceptos abstractos con piezas específicas.

¿Cómo funciona a nivel técnico?

El proceso involucra:

- Generar embeddings: Cada imagen se convierte en un vector usando la API de Google.

- Almacenamiento en Firestore: Los vectores se guardan en una base de datos optimizada para consultas rápidas.

- Búsqueda con KNN: Un algoritmo de «k vecinos más cercanos» encuentra las imágenes más similares a la consulta.

Por ejemplo, si un usuario busca «fuzzy», el sistema genera un vector para esta palabra y lo compara con los vectores de la base de datos. Esto permite encontrar ilustraciones que transmitan esa sensación o concepto.

Empresas y la escala masiva: Documentos y presentaciones

La API también ha demostrado su utilidad en entornos corporativos. Durante un experimento, el equipo de Google indexó más de 16,000 presentaciones y 775,000 diapositivas. Esto facilitó la búsqueda rápida de ideas o diseños antiguos, algo así como una «arqueología digital».

El proceso fue similar al usado con las ilustraciones, pero a una escala mucho mayor. Aquí entró en juego el Vertex AI Vector Search, una tecnología capaz de manejar miles de millones de documentos con tiempos de búsqueda inferiores a 100 milisegundos. Este enfoque es ideal para empresas que necesitan gestionar grandes volúmenes de datos.

Firebase vs. Vertex AI: ¿Cuál elegir?

Ambas opciones tienen ventajas según el contexto:

- Firebase: Perfecto para proyectos pequeños o medianos. Es intuitivo y ofrece buena velocidad en bases de datos moderadas.

- Vertex AI: Diseñado para escalas masivas, como manejar millones de documentos o consultas en milisegundos.

Desde WWWhatsnew, creemos que Firebase es una excelente opción para desarrolladores independientes o pymes, mientras que Vertex AI es ideal para empresas con necesidades complejas y grandes volúmenes de datos.

Alternativas locales y de código abierto

Para quienes buscan soluciones fuera de la nube, existen herramientas como sqlite-vec, una biblioteca ligera que permite manejar embeddings de forma local. Es ideal para quienes necesitan flexibilidad y control total sobre sus datos, aunque implica un poco más de configuración.

La Multimodal Embeddings API representa un gran paso hacia un futuro donde las búsquedas sean intuitivas, precisas y multimodales. Desde WWWhatsnew, vemos un potencial enorme en esta tecnología para mejorar cómo gestionamos y encontramos información. Ya sea que seas un artista buscando una ilustración o una empresa explorando un archivo masivo de presentaciones, esta herramienta puede transformar la forma en que interactúnas con tus datos.