No es fácil saber si una imagen ha sido creada por una IA, pero uno podría pensar que la plataforma que genera las imágenes sí podrían tenerlo más fácil a la hora de determinar si una foto ha sido creada por ellos o no.

Es en eso en lo que están trabajando desde OpenAI con el generador DALL-E.

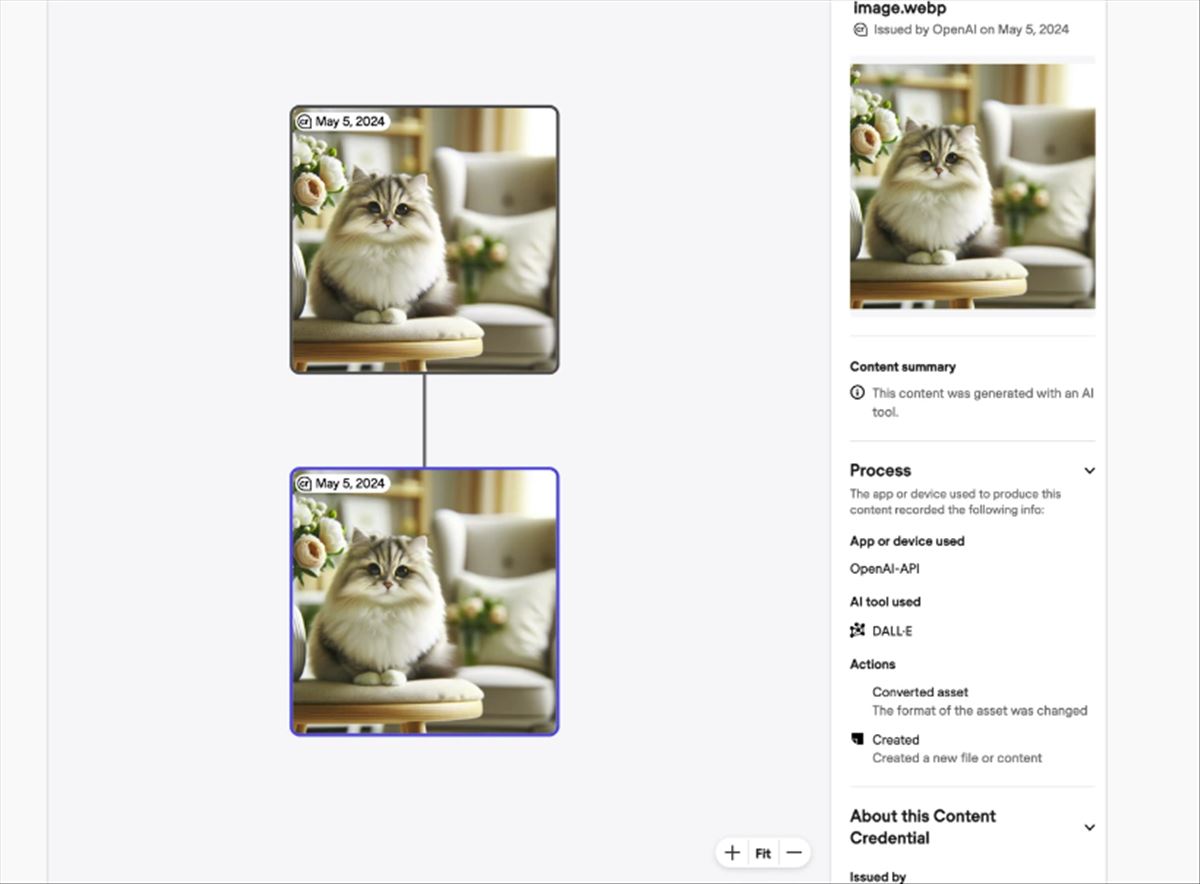

Ha lanzado una herramienta de detección diseñada específicamente para identificar imágenes generadas por su propio modelo, DALL-E 3. Esta innovación llega en un momento crucial, dado el creciente uso de imágenes generadas por IA en diversos sectores, incluido el político, donde su manipulación puede tener consecuencias significativas.

La herramienta de OpenAI muestra una precisión impresionante del 98% al identificar imágenes creadas por DALL-E 3, pero su rendimiento disminuye al enfrentarse a imágenes de otros modelos de IA, con una eficacia de solo entre el 5 y el 10%. Este es un punto crucial, ya que el mercado está saturado con múltiples generadores de imágenes de IA.

Aunque la herramienta maneja bien modificaciones leves como el recorte y los ajustes de saturación, manteniendo una eficacia del 95-97%, los cambios en el matiz presentan más desafíos, reduciendo la efectividad al 82%. Sin embargo, OpenAI no ha publicado datos específicos sobre el rendimiento frente a modificaciones más extensas, lo que sugiere que podrían reducir significativamente la eficiencia de la herramienta.

OpenAI ha sido transparente sobre las limitaciones de su tecnología, ofreciendo acceso a herramientas a evaluadores externos para facilitar la mejora continua. Esta apertura es esencial para el desarrollo y refinamiento de tecnologías que puedan adaptarse a los rápidos cambios en el campo de la generación de imágenes por IA.

En el contexto de las elecciones, el uso de imágenes generadas por IA es particularmente preocupante. Estas imágenes, a menudo modificadas para aumentar su impacto emocional o político, pueden ser herramientas poderosas para la desinformación. La capacidad de la herramienta de OpenAI para identificar y verificar la autenticidad de estas imágenes es, por lo tanto, un componente crítico en la lucha contra la manipulación mediática.

Aún estamos lejos de tener la herramienta definitiva de detección de contenido generado por IA, porque cuando nos acercamos por un lado, las herramientas se hacen más sofisticadas y aumenta la distancia.