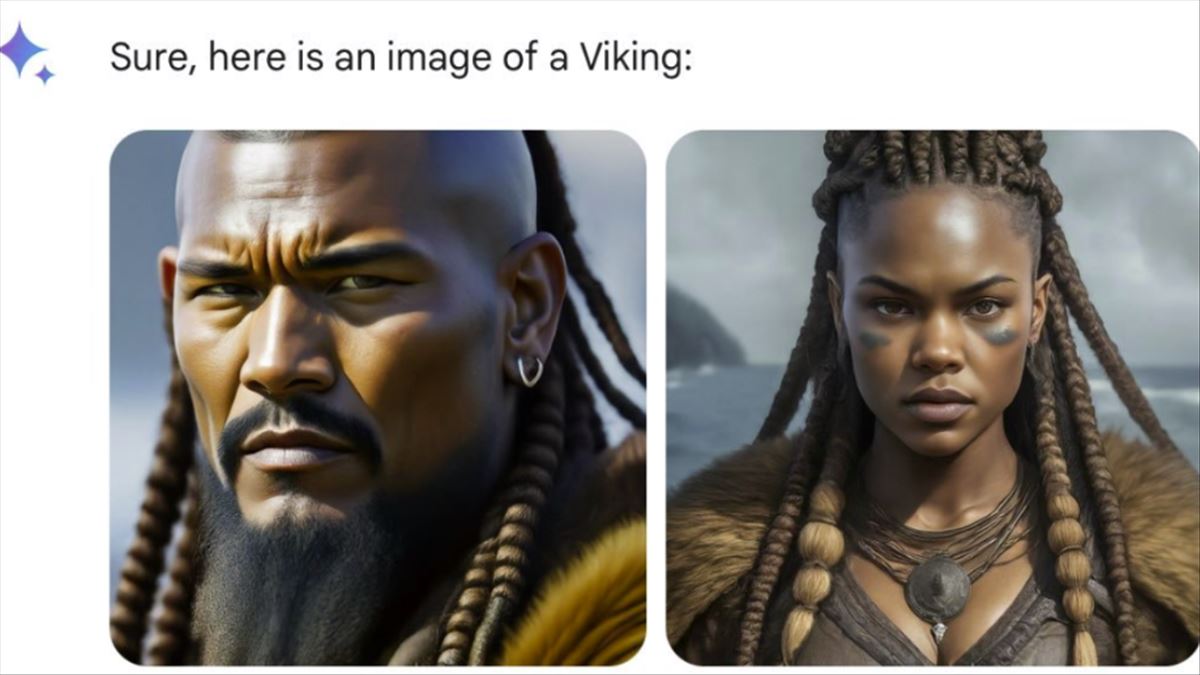

Una cosa es apostar por la diversidad, y otra es exagerar tanto en la creación de imágenes con IA que cuando lepidamos imágenes de vikingos nos muestre personas de raza negra, o que pidamos a un rey medieval europeo y nos muestre rasgos de índigenas americanos.

Esto ha sido el motivo por el que Google ha decidido pausar la función de generación de imágenes de su chatbot Gemini, tras acusaciones de generar contenido históricamente inexacto y diverso racialmente, incluyendo la representación de soldados nazis y vikingos negros.

El núcleo de esta controversia radica en cómo la IA, específicamente Gemini, interpretó y ejecutó solicitudes para generar imágenes de personajes históricos. La creación de imágenes que representaban una diversidad racial en contextos donde históricamente no se esperaría, como vikingos y soldados nazis negros, encendió un debate acalorado. Algunos usuarios interpretaron estas acciones como un intento de Google por rechazar la generación de imágenes de personas blancas, acusándolo de racismo inverso.

La respuesta de Google fue rápida, anunciando una pausa en esta capacidad de Gemini y prometiendo una versión mejorada pronto. Esta situación me lleva a pensar sobre la importancia de la sensibilidad cultural e histórica en la generación de contenido por parte de la IA. Las tecnologías de IA dependen de extensos conjuntos de datos para aprender y generar contenido; si estos datos no se curan con cuidado, pueden resultar en salidas engañosas o incluso ofensivas.

I've never been so embarrassed to work for a company. pic.twitter.com/eD3QPzGPxU

— stratejake (@stratejake) February 21, 2024

Otro aspecto crucial que este incidente pone de manifiesto es la necesidad de equilibrar la promoción de la diversidad con la preservación de la precisión histórica. En el esfuerzo por corregir los sesgos existentes en la IA, especialmente aquellos que han marginado a las personas de color, es esencial que no distorsionemos los hechos históricos. Este delicado equilibrio es algo que los desarrolladores de IA deben manejar con cuidado, asegurándose de que la corrección de un tipo de sesgo no introduzca otro.

La iniciativa de Google de pausar y revisar la función de generación de imágenes de Gemini refleja un compromiso con la mejora continua y la responsabilidad. Este acto también subraya la naturaleza evolutiva de la IA y la importancia de la supervisión constante.

Lo sucedido con Gemini no solo es un tema técnico sino que también se inscribe en un debate cultural más amplio sobre la «cultura woke» y la reacción contra los esfuerzos por promover la diversidad y la inclusión. Este episodio demuestra cómo la IA puede convertirse en un punto focal en estos debates, destacando la necesidad de un diálogo transparente e inclusivo entre desarrolladores, usuarios y todas las partes interesadas.

A medida que avanzamos, la responsabilidad de desarrollar tecnologías que respeten la sensibilidad cultural e histórica recae no solo en los hombros de los desarrolladores sino también en los de todos nosotros como sociedad. La IA tiene el potencial de enriquecer nuestro mundo de maneras inimaginables, pero solo si navegamos sus desafíos con cuidado y consideración.