OpenAI anunció la creación de un nuevo equipo con el objetivo de analizar los potenciales peligros relacionados con la inteligencia artificial.

Analizar, monitorear y predecir diferentes escenarios en torno al mal uso de los modelos de IA son algunas de las tareas de esta iniciativa de OpenAI.

Analizar los potenciales peligros del mal uso de la IA

Como parte de su compromiso en pro de incentivar la seguridad en la IA, OpenAI crea un equipo que estará específicamente dedicado a evaluar los potenciales peligros del avance de la inteligencia artificial:

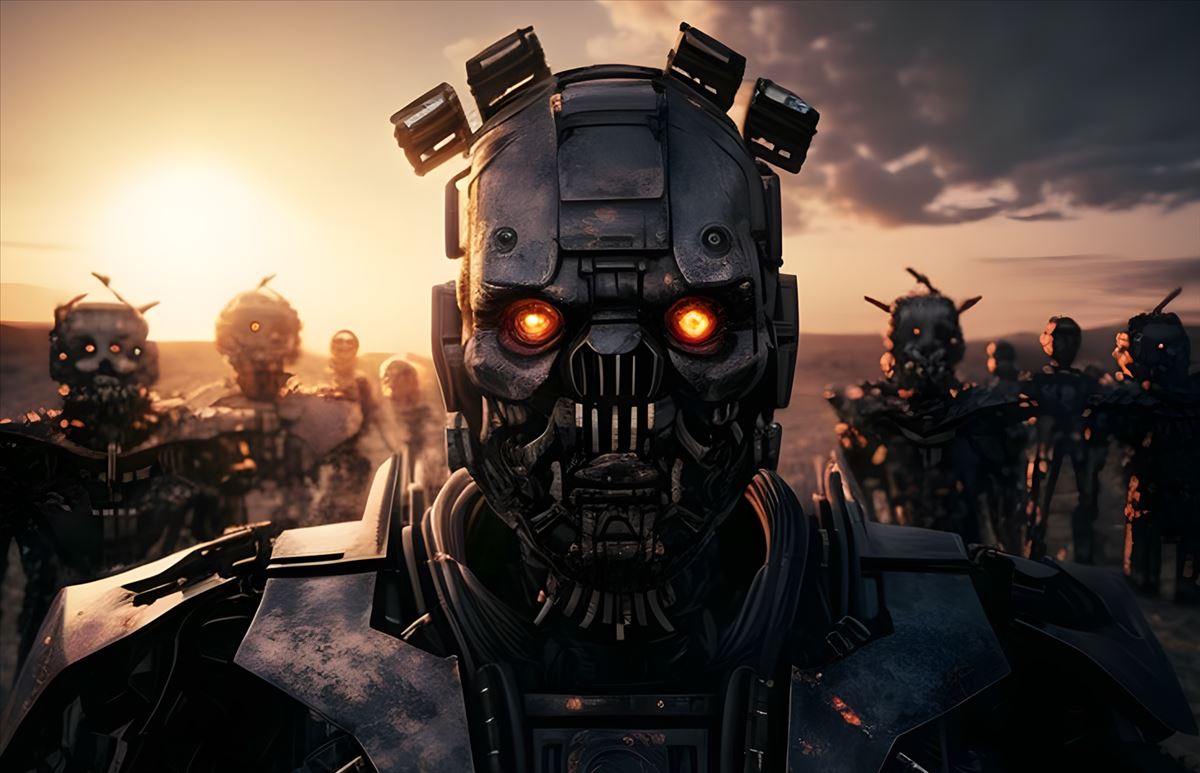

El equipo ayudará a rastrear, evaluar, pronosticar y proteger contra riesgos catastróficos que abarcan múltiples categorías, entre ellas: Persuasión individualizada, La seguridad cibernética, Amenazas químicas, biológicas, radiológicas y nucleares (QBRN), Replicación y adaptación autónomas (ARA)

Siguiendo esta dinámica se analizarán posibles escenarios teniendo en cuenta una serie de situaciones donde se hace mal uso de los modelos de inteligencia artificial. Por ejemplo, desde el uso de la IA para crear ciberataques hasta la creación de armas de destrucción masiva.

Un equipo para preveer cualquier «riesgo catastrófico» relacionado con la IA

Y por supuesto, no solo se considera a este equipo para analizar los actuales modelos de inteligencia artificial, sino que se irán evaluando los riesgos de cada nuevo avance o nueva generación de IA, bajo un sistema de monitoreo y supervisión.

Este análisis y seguimiento será imprescindible para anticiparse a cualquier «riesgo catastrófico» y crear sistemas de protección.

Necesitamos asegurarnos de tener la comprensión y la infraestructura necesarias para la seguridad de los sistemas de IA de alta capacidad.

Recordemos que a fines de mayo, Sam Altman, director ejecutivo de Open AI y un grupo de reconocidos investigadores, ingenieros y otros ejecutivos, emitieron una breve declaración advirtiendo sobre los peligros de la IA, y la necesidad de tomar medidas urgentes:

Mitigar el riesgo de extinción debido a la IA debería ser una prioridad global junto con otros riesgos a escala social, como las pandemias y la guerra nuclear