La transparencia en la inteligencia artificial (IA) es un tema que ha ganado relevancia en los últimos años. El Índice de Transparencia de Modelos de Fundación (FMTI), desarrollado por un equipo multidisciplinario de Stanford, MIT y Princeton, busca abordar esta cuestión crítica. Este artículo explora en profundidad el FMTI, su metodología y sus implicaciones para la industria de la IA.

La transparencia en la industria de la IA está en declive. Esta falta de claridad no solo afecta a las empresas y académicos, sino también a los consumidores y legisladores. La opacidad en la operación de modelos de IA puede llevar a riesgos significativos en términos de seguridad, ética y responsabilidad.

¿Qué es el FMTI?

El Índice de Transparencia de Modelos de Fundación (FMTI) es un marco de evaluación diseñado para medir la transparencia en el desarrollo y uso de modelos de inteligencia artificial de fundación. Este índice se basa en 100 indicadores que se dividen en tres grandes dominios: aguas arriba (Upstream), el modelo en sí (Model) y aguas abajo (Downstream). A continuación, se detallan estos dominios:

Indicadores Upstream

Se centran en los ingredientes y procesos que intervienen en la construcción de un modelo de fundación. Estos incluyen:

- Recursos Computacionales: Se refiere a la potencia de cálculo y al hardware utilizado para entrenar y ejecutar el modelo.

- Datos: Este indicador abarca la procedencia de los datos, cómo se recopilan, almacenan y procesan para el entrenamiento del modelo.

- Mano de Obra: Se refiere a la fuerza laboral involucrada en la construcción del modelo, incluidas las condiciones laborales y las prácticas éticas.

Indicadores del Modelo (Model)

Los indicadores del modelo se centran en las propiedades y funciones del modelo de fundación. Estos abarcan:

- Arquitectura del Modelo: Detalles técnicos sobre cómo está construido el modelo, incluidas las capas, nodos y parámetros.

- Capacidades: Este indicador evalúa lo que el modelo puede hacer, sus aplicaciones y utilidades.

- Riesgos: Se refiere a las limitaciones y posibles peligros asociados con el uso del modelo, como sesgos y vulnerabilidades.

Indicadores Downstream

Se centran en cómo se distribuye y utiliza el modelo de fundación. Estos incluyen:

- Impacto en los Usuarios: Evalúa cómo el modelo afecta a los usuarios finales, incluida la privacidad y la seguridad de los datos.

- Actualizaciones del Modelo: Información sobre cómo y cuándo se actualiza el modelo, y qué cambios se han realizado.

- Políticas de Uso: Detalles sobre las políticas que rigen el uso del modelo, incluidas las licencias y restricciones.

Estos tres dominios proporcionan una visión completa de la transparencia en el ciclo de vida de un modelo de IA de fundación, desde su creación hasta su implementación y uso.

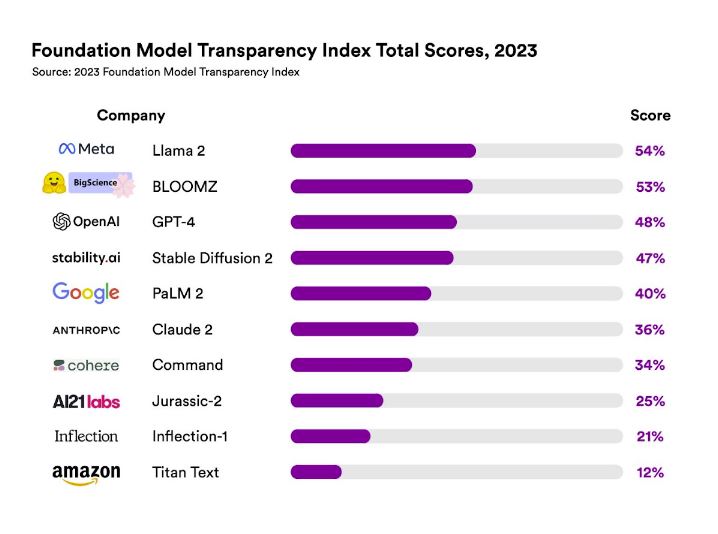

Hallazgos Clave del FMTI

Los resultados del Índice de Transparencia de Modelos de Fundación (FMTI) revelan un panorama bastante revelador sobre el estado actual de la transparencia en la industria de la inteligencia artificial. A continuación, se presentan las puntuaciones de algunas de las empresas más prominentes en el campo:

Meta (anteriormente Facebook)

- Modelo: Llama 2

- Puntuación: 54/100

- Observaciones: Este modelo obtuvo la puntuación más alta en el índice, aunque sigue siendo insuficiente en términos de transparencia total.

OpenAI

- Modelo: GPT-4

- Puntuación: 48/100

- Observaciones: A pesar de ser uno de los modelos de IA más avanzados y populares, GPT-4 de OpenAI no logró una puntuación impresionante en el índice.

Amazon

- Modelo: Titan

- Puntuación: 12/100

- Observaciones: Este modelo obtuvo la puntuación más baja entre los evaluados, lo que plantea serias preocupaciones sobre la transparencia en los modelos de IA de Amazon.

Estas puntuaciones indican que, en general, la industria tiene un largo camino por recorrer para alcanzar niveles aceptables de transparencia. Incluso los modelos que obtuvieron las puntuaciones más altas están lejos de ser completamente transparentes, lo que subraya la necesidad de una acción inmediata para abordar estas deficiencias.

Un dato importante que debe anotarse es que los modelos abiertos tienden a ser más transparentes que sus contrapartes cerradas, algo que es lógico, pero que era necesario comprobarlo.

El FMTI tiene el potencial de guiar a los legisladores en la creación de políticas efectivas para regular la transparencia en la IA. Esto es especialmente relevante en contextos como la Unión Europea, donde se está trabajando en la Ley de IA.

Más información en Stanford HAI.