Los fabricantes de coches autónomos dependen de programas muy caros que realicen simulaciones realistas de conducción. De esa forma Tesla, Waymo y otros consiguen en un día simular varios meses de situaciones diversas, necesario para entrenar su cerebro de IA para que en la realidad haya el menor número de accidentes posibles.

Ahora nace un nuevo simulador, pero en este caso es de código abierto. Se trata de VISTA 2.0, y ha sido creado por científicos del Laboratorio de Ciencias de la Computación e Inteligencia Artificial (CSAIL) del MIT. Se trata de un motor de simulación basado en datos donde los vehículos pueden aprender a conducir en el mundo real.

Daniela Rus, profesora del MIT y directora de CSAIL, y autora principal del artículo, dice que VISTA 2.0 es diferente a los simuladores AV existentes, ya que está basado en datos, lo que significa que fue construido y renderizado de manera fotorrealista a partir de datos del mundo real.

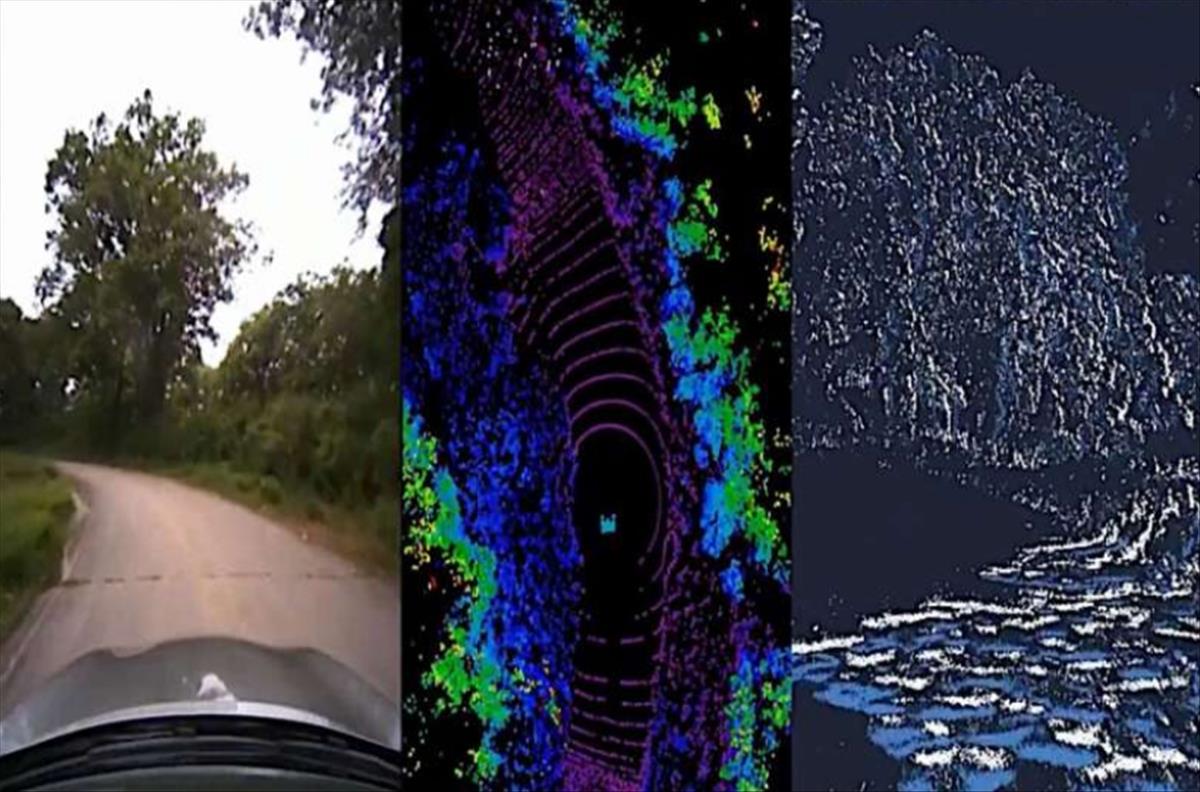

Es posible así simular sensores complejos y escenarios diversos usando muchos menos datos que los modelos anteriores. Puede desde simular datos de sensores de las cámaras 2D RGB, a lidars 3D con millones de puntos o cámaras basadas en eventos cronometrados irregularmente.

En las pruebas es posible ver cómo consiguen adelantar, seguir a otros coches y darles el paso, todo en escenarios de múltiples agentes en entornos fotorrealistas.

Estos simuladores deben de ser capaces de simular video en vivo, pero también datos LiDAR y cámaras de eventos, así como añadir otros coches para modelar situaciones de conducción complejas, y lo consiguen generando nubes de puntos 3D a partir de vistas dispersas del mundo.

Tenéis el código en este enlace y la documentación en vista.csail.mit.edu.