Cuando configuramos varios ordenadores para que realicen una tarea compleja de forma sincronizada, tenemos que tener en cuenta una infinidad de variables, pero hay dos realmente importantes: la capacidad de cada computadora y la latencia entre las conexiones de red de dichos ordenadores. Esta última es clave, ya que los ordenadores tienen que comunicarse constantemente para compartir sus resultados con el resto de la red, y si la conexión entre el hardware no es muy eficiente, se perderá demasiado tiempo.

Esto se aplica principalmente en los sistemas de aprendizaje profundo distribuido (DDL), y ahora IBM ha presentado una nueva técnica que promete reducir el tiempo que se necesita para entrenar sistemas de este tipo, optimizando la transferencia de datos entre componentes de hardware dentro de una red neuronal.

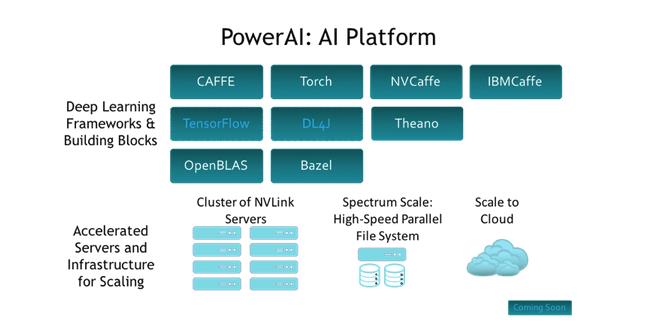

Quieren evitar los cuellos de botella en los sistemas de aprendizaje profundo distribuidos, reducir las conexiones de alta latencia entre el hardware que realiza el cálculo real, y para ello han creado PowerAI DDL, una nueva biblioteca de comunicación que aprovecha todas las conexiones de alto rendimiento disponibles. Con esta biblioteca IBM ha conseguido entrenar la red neural Resnet-50 con el conjunto de datos ImageNet en 50 minutos, utilizando 64 servidores, cada uno con cuatro GPUs.

Todo este hardware también es de IBM, la biblioteca no funciona con hardware de terceros, pero creen que las organizaciones podrán justificar la inversión de forma sencilla, ya que podrán realizar más estudios sobre inteligencia artificial en mucho menos tiempo.