La empresa Groq ha presentado un motor de modelos de lenguaje grande (LLM) que permite realizar consultas y otras tareas de manera extremadamente rápida directamente en su sitio web. Esta tecnología ha sido un avance significativo, demostrando velocidades que las GPU de empresas como Nvidia no pueden igualar. Groq ha incrementado la velocidad de respuesta de 800 a 1256.54 tokens por segundo en solo unos meses.

Compatibilidad y Flexibilidad

El motor de Groq utiliza por defecto el modelo Llama3-8b-8192 de Meta, pero también ofrece opciones para otros modelos más grandes como el Llama3-70b, y modelos de Gemma (Google) y Mistral. Esto permite una flexibilidad impresionante para los desarrolladores que buscan aprovechar diferentes capacidades de LLM.

Aplicaciones Prácticas

En pruebas realizadas, el motor de Groq ha mostrado una capacidad impresionante para realizar tareas de manera casi instantánea. Por ejemplo, al generar y modificar tablas para la organización de eventos, la respuesta fue inmediata y permitió realizar cambios sobre la marcha, como añadir columnas adicionales o corregir errores ortográficos.

Tecnología y Eficiencia

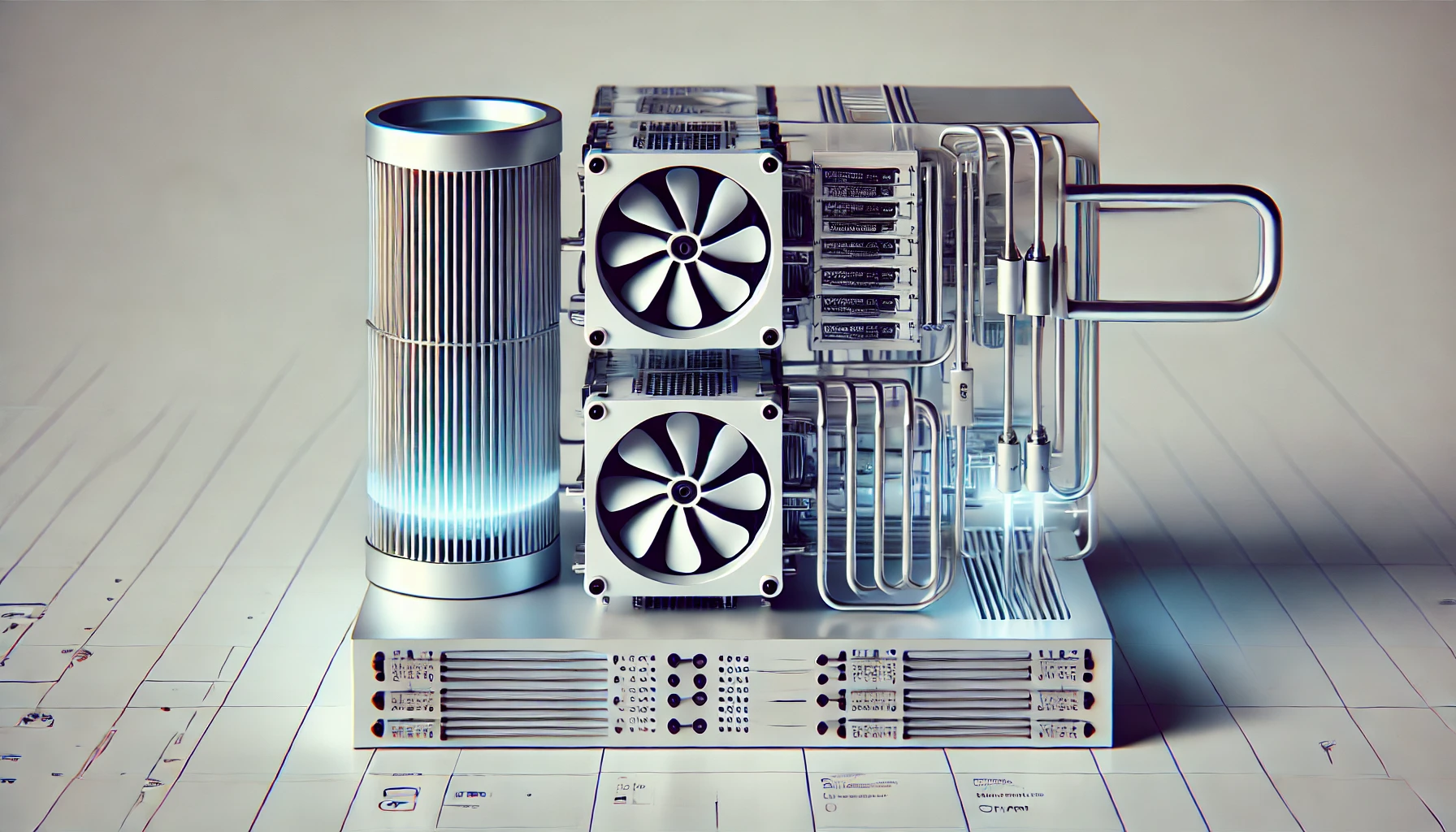

Groq se destaca por su unidad de procesamiento de lenguaje (LPU), que es mucho más eficiente que las GPU para tareas de inferencia de AI. Mientras que las GPU son esenciales para el entrenamiento de modelos, las LPUs de Groq ofrecen una eficiencia y latencia mucho mejores para la implementación de aplicaciones de AI.

La tecnología de Groq utiliza aproximadamente un tercio de la energía de una GPU en el peor de los casos, y en la mayoría de las cargas de trabajo, solo usa una décima parte. Esto representa un cambio significativo en un mundo donde la demanda de energía para cargas de trabajo de LLM sigue creciendo.

Impacto en el Mercado

Desde su lanzamiento hace 16 semanas, Groq ha atraído a más de 282,000 desarrolladores, mostrando un crecimiento impresionante en su base de usuarios. La facilidad con la que los desarrolladores pueden cambiar sus aplicaciones desde OpenAI a Groq en cuestión de segundos ha sido un factor clave en este crecimiento.

Jonathan Ross, CEO de Groq, destaca que la empresa se está enfocando en el despliegue empresarial de aplicaciones de AI, que requieren un procesamiento más eficiente. Ross será uno de los oradores principales en el evento VB Transform, donde se discutirán estos temas y más.

Avances en Reconocimiento de Voz

Además de la capacidad de escribir consultas, Groq ahora permite a los usuarios realizar consultas por voz, utilizando el modelo Whisper Large V3 de OpenAI para la traducción de voz a texto. Este texto se inserta como el prompt para el LLM, haciendo que la interacción sea aún más fluida y accesible.