Microsoft ha lanzado una nueva característica de inteligencia artificial llamada Correction, diseñada para detectar y corregir las alucinaciones de IA. Si no estás familiarizado con el término, una alucinación de IA ocurre cuando un modelo de inteligencia artificial genera información incorrecta o engañosa. Estas alucinaciones han sido un problema recurrente en los modelos de IA, pero ahora Microsoft ha integrado esta función dentro de su sistema de detección de groundedness en Azure AI Content Safety.

¿Qué es «Correction» y cómo funciona?

La función Correction está diseñada específicamente para los clientes empresariales de Azure, donde la precisión en la información generada por IA es crucial. Esta herramienta trabaja en conjunto con los documentos de referencia de Azure, conocidos como documentos de grounding. Estos documentos son la fuente principal que la IA debe seguir al generar respuestas, asegurando que la información esté basada en datos reales y verificables.

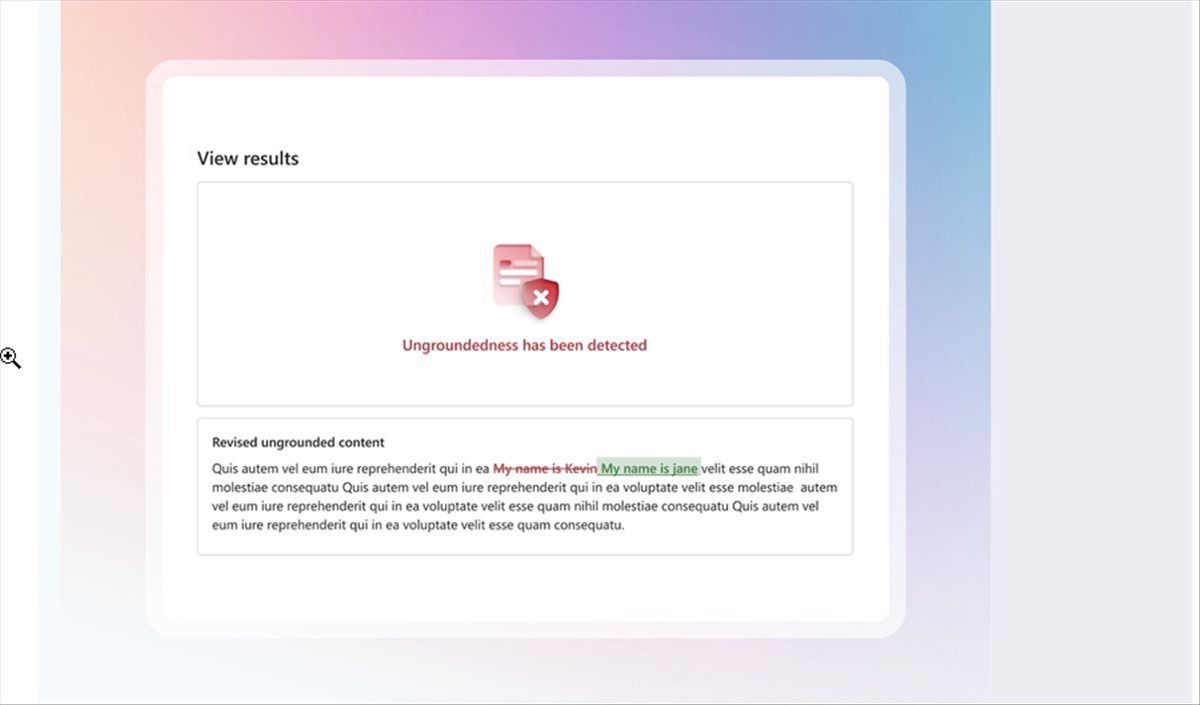

Cuando se activa Correction, la IA compara la información generada con los documentos de grounding. Si se detecta una incongruencia o información incorrecta, la función señala el error y solicita una corrección. Además, esta característica puede proporcionar una explicación de por qué un segmento de texto fue marcado como incorrecto, lo que facilita entender el proceso detrás de la corrección.

¿Por qué es importante corregir las alucinaciones de IA?

Las alucinaciones en la IA pueden llevar a malentendidos y generar contenido erróneo, lo cual es especialmente peligroso en contextos empresariales y críticos. Imagina que estás utilizando un chatbot de IA para consultas legales o financieras. Si la IA genera una respuesta incorrecta, las consecuencias pueden ser costosas o incluso peligrosas.

Correction no busca resolver la «exactitud» en su totalidad, sino alinear las respuestas generadas por IA con la información verificada en los documentos de grounding. Esto es clave para mejorar la confianza en los sistemas de IA generativa, que se están utilizando cada vez más en entornos empresariales, como lo destacó un portavoz de Microsoft en una entrevista con The Verge.

Integración con otras herramientas de IA de Microsoft

Correction se integra con otras capacidades de IA que Microsoft está desarrollando en su plataforma Azure AI. Esto incluye herramientas como Copilot, que permite a las empresas utilizar chatbots colaborativos para manejar tareas más complejas. La combinación de estas tecnologías hace que el uso de IA sea más fiable y eficiente, reduciendo la probabilidad de errores o información inexacta.

Los usuarios que habiliten la función de razonamiento también pueden recibir explicaciones detalladas de por qué una determinada respuesta fue marcada como incorrecta, lo que proporciona una mayor transparencia y comprensión del funcionamiento del sistema.

Microsoft y la lucha contra las alucinaciones de IA

La introducción de Correction forma parte de un esfuerzo más amplio de Microsoft para mejorar la precisión y la fiabilidad de sus herramientas de IA. Las alucinaciones han sido uno de los principales desafíos a la hora de integrar IA en aplicaciones prácticas, ya que incluso los modelos de IA más avanzados, como ChatGPT o Bard, han demostrado fallos en la generación de respuestas.

La estrategia de Microsoft con Azure AI es asegurarse de que sus herramientas estén respaldadas por fuentes de información confiables, como los documentos de grounding, lo que reduce significativamente la probabilidad de errores. Este enfoque es vital en industrias como la legal, financiera y médica, donde la precisión es esencial.

En WWWhatsnew.com, siempre hemos seguido de cerca el desarrollo de tecnologías de inteligencia artificial, y el lanzamiento de Correction es un paso más hacia la creación de sistemas de IA más robustos y precisos. Microsoft está demostrando que se toma en serio el problema de las alucinaciones de IA, y esta herramienta podría marcar la diferencia para muchas empresas que buscan implementar IA generativa de manera segura.