Meta está dando un gran paso adelante en el mundo de la inteligencia artificial con el lanzamiento de Llama 3.2, su primer modelo de visión multimodal que puede entender tanto imágenes como texto. Este anuncio se realizó en Meta Connect 2024 y marca un avance significativo en la competencia con otros gigantes de la IA como Anthropic y OpenAI. Si ya habías oído hablar de los modelos de lenguaje Llama, prepárate porque ahora no solo entienden palabras, ¡también ven imágenes!

¿Qué trae de nuevo Llama 3.2?

El nuevo Llama 3.2 no es cualquier modelo de lenguaje, es una herramienta con modelos más pequeños y medianos que van desde 11 mil millones (11B) hasta 90 mil millones (90B) de parámetros. Para ponerlo en perspectiva, cuántos más parámetros tiene un modelo, más preciso puede ser y mejor maneja tareas complejas. Pero lo que realmente destaca es su capacidad para entender imágenes, una función clave que le permite captar gráficos, tablas y hasta identificar objetos a partir de descripciones en lenguaje natural.

Pongamos un ejemplo práctico: imagina que tienes un gráfico de ventas de tu empresa y te preguntas en qué mes obtuviste mejores resultados. Con Llama 3.2, podrías preguntarle directamente y el modelo analizaría el gráfico, identificando el mes con mayor rendimiento. Además, también es capaz de generar descripciones de imágenes, lo que puede ser increíblemente útil en aplicaciones como redes sociales o herramientas de trabajo colaborativo.

Más ligero y más rápido

Para quienes estén pensando en desarrollar apps personalizadas, Meta también ha lanzado versiones más ligeras de Llama 3.2. Estos modelos de 1B y 3B parámetros están diseñados para funcionar en dispositivos móviles y de borde (edge computing). ¿Qué significa esto? Que no tendrás que depender tanto de la nube o servidores remotos, lo que puede ser clave para aplicaciones más privadas o que requieran respuestas en tiempo real. Por ejemplo, podrías usar estos modelos para crear asistentes personales que gestionen tus mensajes o agenden reuniones.

Rivalizando con los grandes: Claude y GPT-4

Meta no se anda con rodeos al comparar su nuevo modelo con los de la competencia. Según ellos, Llama 3.2 está en la misma liga que Claude 3 Haiku de Anthropic y el famoso GPT-4 de OpenAI, especialmente en tareas de reconocimiento de imágenes y comprensión visual. Si bien todos estos modelos son potentes, Meta afirma que su Llama 3.2 supera a otros como Gemma y Phi 3.5-mini en áreas clave como seguir instrucciones, generar resúmenes, usar herramientas y reescribir prompts.

Además, Meta ha puesto a disposición la descarga de sus modelos en llama.com y Hugging Face, lo que permite a los desarrolladores trabajar con ellos en una amplia variedad de entornos, desde on-prem (servidores locales) hasta la nube. Esta flexibilidad es crucial para quienes buscan integrar IA avanzada en sus productos sin depender completamente de plataformas externas.

Meta AI para empresas: Chatbots y más

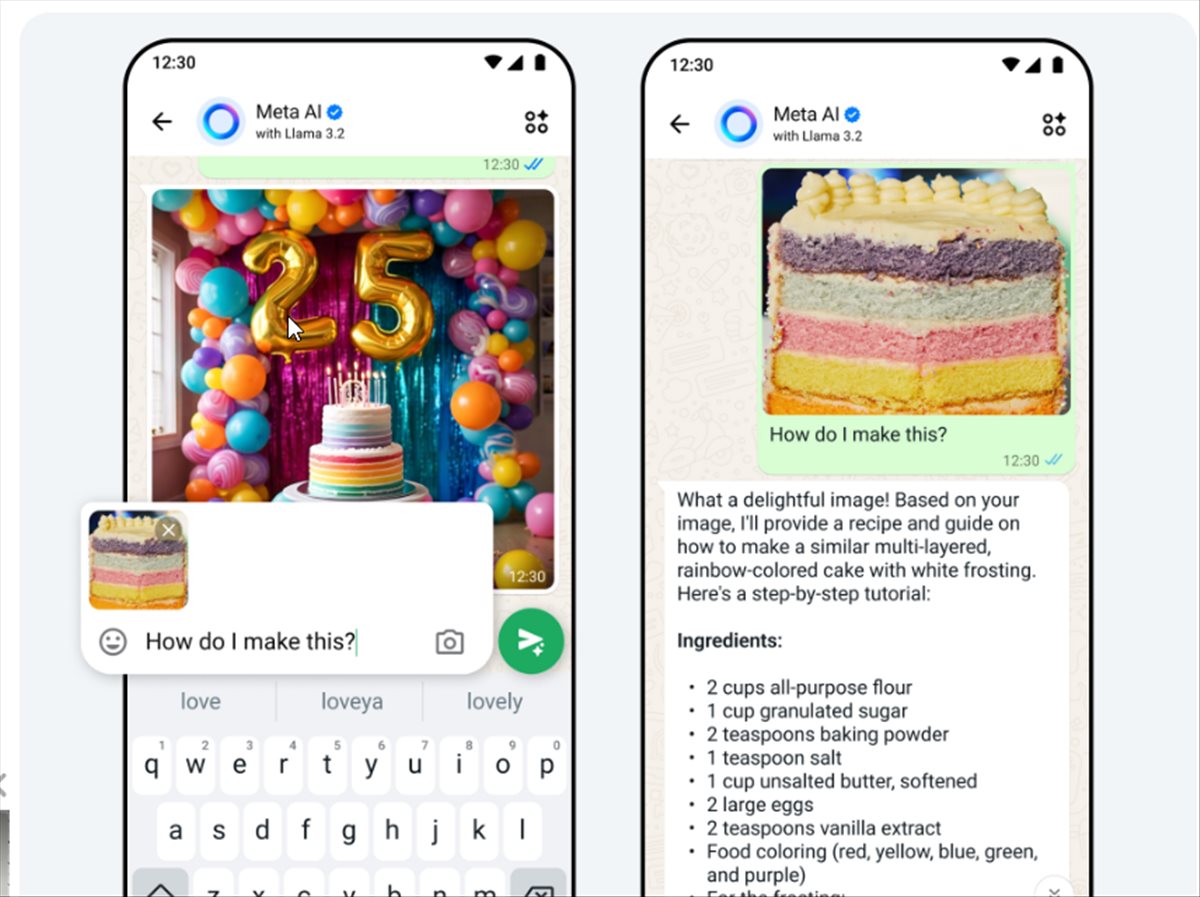

No solo se trata de mejorar los modelos de IA, Meta también está expandiendo el uso de inteligencia artificial en el ámbito empresarial. Han añadido funciones para que las empresas puedan usar agentes conversacionales en WhatsApp y Messenger, con los que los usuarios podrán hacer preguntas comunes, discutir detalles de productos e incluso realizar compras. Esto suena perfecto para compañías que buscan mejorar la atención al cliente sin saturar sus equipos de soporte.

En los últimos meses, más de un millón de anunciantes ya han utilizado herramientas de IA generativa de Meta para crear anuncios. Según datos de la compañía, las campañas que utilizan esta tecnología han logrado un 11% más de CTR (click-through rate) y un 7.6% más de conversiones en comparación con las campañas tradicionales.

¿La voz de Meta? ¡Ahora suena como una celebridad!

Quizá una de las funciones más llamativas es que ahora Meta AI tiene una voz… o mejor dicho, varias. Llama 3.2 incluye nuevas capacidades multimodales que permiten responder no solo en texto, sino también en voces de celebridades como Dame Judi Dench, John Cena, Kristen Bell, y otros. Imagina enviar un mensaje en WhatsApp y que te responda con la voz de un famoso. Es un toque divertido y muy creativo que probablemente veamos implementado en Messenger, Instagram y Facebook en los próximos meses.

Meta AI también podrá responder a fotos en los chats, cambiar fondos en imágenes o añadir y eliminar elementos, lo que le da un plus en cuanto a personalización visual. Están experimentando, además, con herramientas de traducción, doblaje de video y sincronización de labios, lo cual suena fascinante si piensas en las posibilidades de crear contenido completamente personalizado.

La batalla por el liderazgo en IA

Meta está claramente decidido a seguir compitiendo contra los gigantes del sector como OpenAI y Anthropic, no solo con su capacidad para manejar imágenes y texto, sino también con las aplicaciones empresariales y de consumo que están desarrollando alrededor de estos modelos. Personalmente, creo que es solo cuestión de tiempo antes de que veamos cada vez más integraciones de IA en nuestras interacciones diarias, ya sea en redes sociales, aplicaciones de mensajería o en el entorno laboral.

Si te interesa seguir al tanto de este tipo de avances, en WWWhatsnew.com solemos cubrir todo lo relacionado con la inteligencia artificial, desde lanzamientos hasta aplicaciones prácticas. No te pierdas las novedades, porque este año promete estar lleno de sorpresas en el mundo de la IA.