Varias veces os he explicado cómo funciona ChatGPT, os he comentado el sistema de estadísticas de los modelos de IA generativa y el cómo vomita palabras con sentido en función de las frases con las que ha sido entrenado.

El caso es que hay una página que muestra de forma gráfica todo esto.

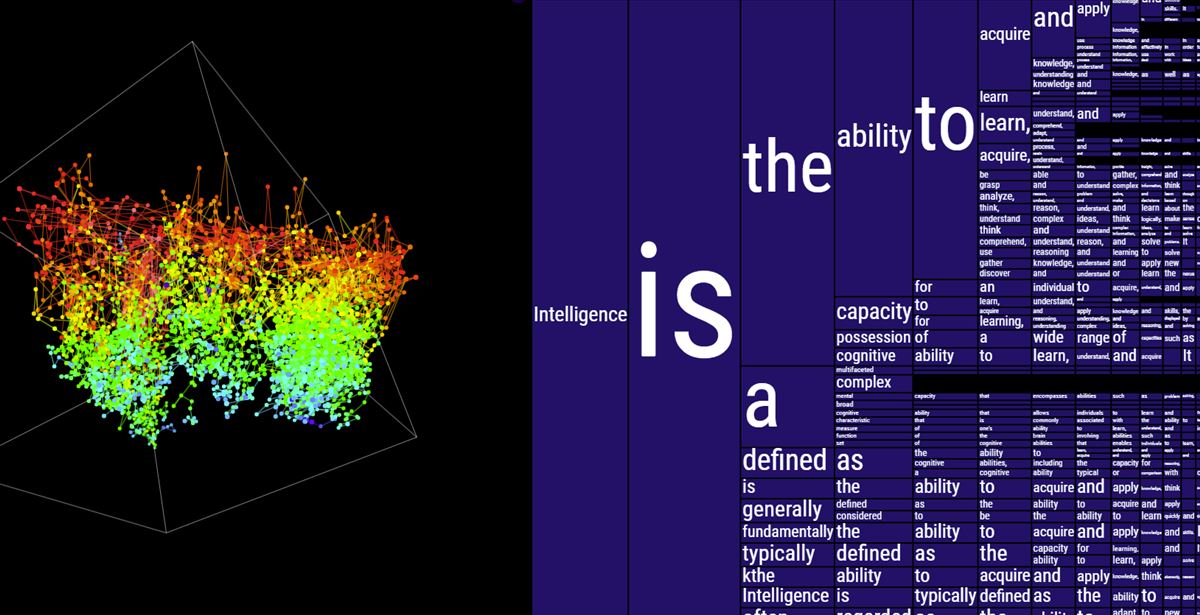

Se trata de moebio.com/mind, un experimento en el que el creador muestra la importancia de las distribuciones de probabilidad sobre palabras (o tokens) para generar texto.

En esencia, ChatGPT, como una forma de modelo de lenguaje grande (LLM), se entrena en un corpus masivo de datos de texto. Este proceso de capacitación implica aprender las probabilidades de secuencias de palabras (o tokens) en función de sus apariciones y contextos en los datos de capacitación. El modelo no comprende el lenguaje en el sentido humano, pero tiene una comprensión matemática de los patrones y secuencias de palabras.

Cuando el modelo genera texto, lo hace prediciendo la siguiente palabra (token) en una secuencia basada en las palabras anteriores. Para cualquier secuencia dada de palabras, el modelo calcula una distribución de probabilidad sobre todas las palabras de su vocabulario sobre cuál podría ser la siguiente palabra. Esta probabilidad se basa en los patrones que aprendió durante el entrenamiento.

Proceso de generación de secuencia

El proceso es el siguiente:

- Inicialización: el proceso comienza con una entrada inicial (que puede ser simplemente un token de inicio o un mensaje real proporcionado por el usuario).

- Predicción de tokens: en cada paso, el modelo observa la secuencia generada hasta el momento y predice una distribución de probabilidad para la siguiente palabra.

- Muestreo: De esta distribución, se selecciona la siguiente palabra. La selección puede ser determinista (elegir la palabra más probable) o implicar alguna forma de aleatoriedad (para generar resultados más variados o creativos).

- Repetición: este proceso se repite, y el modelo toma la secuencia extendida (incluida la palabra recién agregada) como nueva entrada para cada paso posterior, hasta que se cumpla una condición de parada (como alcanzar una longitud máxima o generar un token de parada).

- Refinamiento y entrenamiento: El entrenamiento de modelos como ChatGPT implica ajustar los parámetros del modelo (pesos en la red neuronal) para que las probabilidades que asigna a la siguiente palabra de una secuencia sean lo más precisas posible, dado el contexto proporcionado por las palabras anteriores. Esto se hace mediante un proceso conocido como retropropagación, donde el modelo se corrige en función de su rendimiento prediciendo la siguiente palabra en innumerables ejemplos de entrenamiento.

En la página de moebio tenemos el resultado de poner «inteligencia es» en ChatGPT y analizar los cientos de posibles resultados, tal y como se aprecia al ir moviendo el ratón por la página.

Es fascinante pensar en cómo un proceso basado en predecir la probabilidad de la siguiente palabra puede dar como resultado la generación de un texto coherente y contextualmente apropiado, es algo que no me dejará de sorprender nunca.