Ayer lunes, el gigante tecnológico Nvidia sorprendió al mundo al anunciar el HGX H200 Tensor Core GPU, utilizando la arquitectura Hopper para acelerar aplicaciones de inteligencia artificial. Si creías que el H100 era potente, el H200 promete ser aún más impresionante, lo que podría significar un salto enorme en modelos de IA como ChatGPT, acelerando tanto su desarrollo como sus tiempos de respuesta.

Los expertos han señalado que la falta de potencia de cómputo ha sido un gran cuello de botella en el progreso de la IA durante el último año. La escasez de GPUs potentes que aceleran los modelos de IA es en gran parte la culpable. Una forma de aliviar este cuello de botella es fabricar más chips, pero otra es hacer que los chips de IA sean más potentes. Aquí es donde el H200 se convierte en un producto atractivo para los proveedores de servicios en la nube.

A diferencia de los GPUs tradicionales centrados en gráficos, los GPUs de centros de datos como el H200 son ideales para aplicaciones de IA porque realizan un vasto número de multiplicaciones de matrices en paralelo, necesarias para el funcionamiento de las redes neuronales. Son esenciales tanto en la parte de entrenamiento de un modelo de IA como en la de «inferencia», donde las personas introducen entradas en un modelo de IA y este devuelve resultados.

Según Nvidia, el H200 es el primer GPU que ofrece memoria HBM3e. Gracias a esta tecnología, el H200 ofrece 141GB de memoria y 4.8 terabytes por segundo de ancho de banda, lo que Nvidia afirma que es 2.4 veces el ancho de banda de memoria del Nvidia A100 lanzado en 2020.

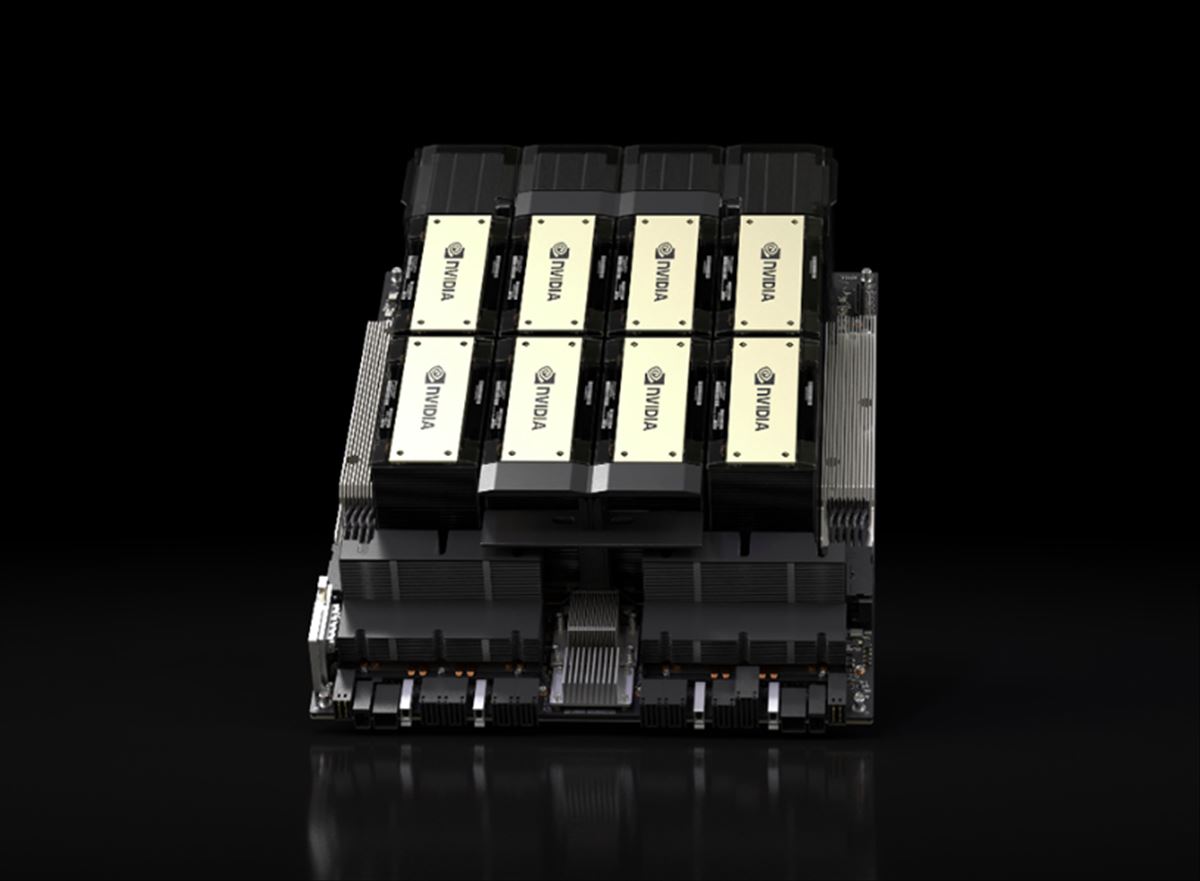

Nvidia fabricará el H200 en varios formatos, incluyendo tableros de servidor Nvidia HGX H200 en configuraciones de cuatro y ocho vías, compatibles tanto con el hardware como con el software de los sistemas HGX H100. También estará disponible en el Nvidia GH200 Grace Hopper Superchip, que combina un CPU y un GPU en un solo paquete para aún más potencia en IA.

Entre los primeros en implementar instancias basadas en H200 estarán Amazon Web Services, Google Cloud, Microsoft Azure y Oracle Cloud Infrastructure, comenzando el próximo año, y Nvidia dice que el H200 estará disponible «de fabricantes de sistemas globales y proveedores de servicios en la nube» a partir del segundo trimestre de 2024.

Mientras tanto, Nvidia ha estado jugando al gato y al ratón con el gobierno de EE.UU. sobre las restricciones de exportación de sus potentes GPUs que limitan las ventas a China. El año pasado, el Departamento de Comercio de EE.UU. anunció restricciones destinadas a «mantener las tecnologías avanzadas fuera de las manos equivocadas», como China y Rusia. Nvidia respondió creando nuevos chips para sortear esas barreras, pero EE.UU. recientemente también prohibió esos.

Nvidia está introduciendo tres nuevos chips de IA reducidos (HGX H20, L20 PCIe y L2 PCIe) para el mercado chino, que representa un cuarto de los ingresos de Nvidia en chips de centros de datos. Dos de los chips están por debajo de las restricciones de EE.UU., y un tercero está en una «zona gris» que podría ser permisible con una licencia.

El H200 promete no solo ser un gigante en términos de potencia de procesamiento, sino también un catalizador para la próxima generación de modelos de IA y chatbots. Con su capacidad para manejar cargas de trabajo cada vez más exigentes y complejas, este GPU podría ser un cambio de juego en el campo de la inteligencia artificial, abriendo nuevas posibilidades y marcando un hito en la historia de Nvidia.

Tenéis más información en nvidianews.nvidia.com