Volvemos a hablar de proyectos de Inteligencia Artificial que permiten crear imágenes de forma automática, partiendo desde cero, con tan sólo indicar unas instrucciones a través de textos, lo que ha supuesto una revolución hasta el punto de que algunas aplicaciones y servicios de creatividad populares están recibiendo funciones basados en estos proyectos

Y de entre los proyectos de Inteligencia Artificial más destacados de este emergente sector se encuentra Stable Difussion, que desde hoy dispone de su versión 2.0 con novedades bastante apreciables.

Stability AI señala que con esta versión se han incluido modelos robustos de texto a imagen entrenados con un codificador de texto completamente nuevo (OpenCLIP), estando detrás de su desarrollo LAION con el respaldo de Stability AI, prometiendo mejoras en la calidad de imagen en comparación con la versión anterior.

E indican que:

Los modelos de texto a imagen de esta versión pueden generar imágenes con resoluciones predeterminadas de 512×512 píxeles y 768×768 píxeles

En esta versión se ha abordado uno de los problemas existentes en este tipo de proyectos, y es la generación de contenidos que puedan ser calificados para adultos. A este respecto, se incluye el filtro NSFW de LAION para la eliminación de este tipo de contenidos.

Esta versión también incluye un nuevo modelo llamado Upscaler Diffusion capaz de mejorar las imágenes en un factor de 4, ofreciendo un ejemplo de imagen generada en 128×128 de resolución escalada a una imagen de mayor resolución (512×512).

Desde Stability AI agregan:

Combinado con nuestros modelos de texto a imagen, Stable Diffusion 2.0 ahora puede generar imágenes con resoluciones de 2048×2048 o incluso superiores.

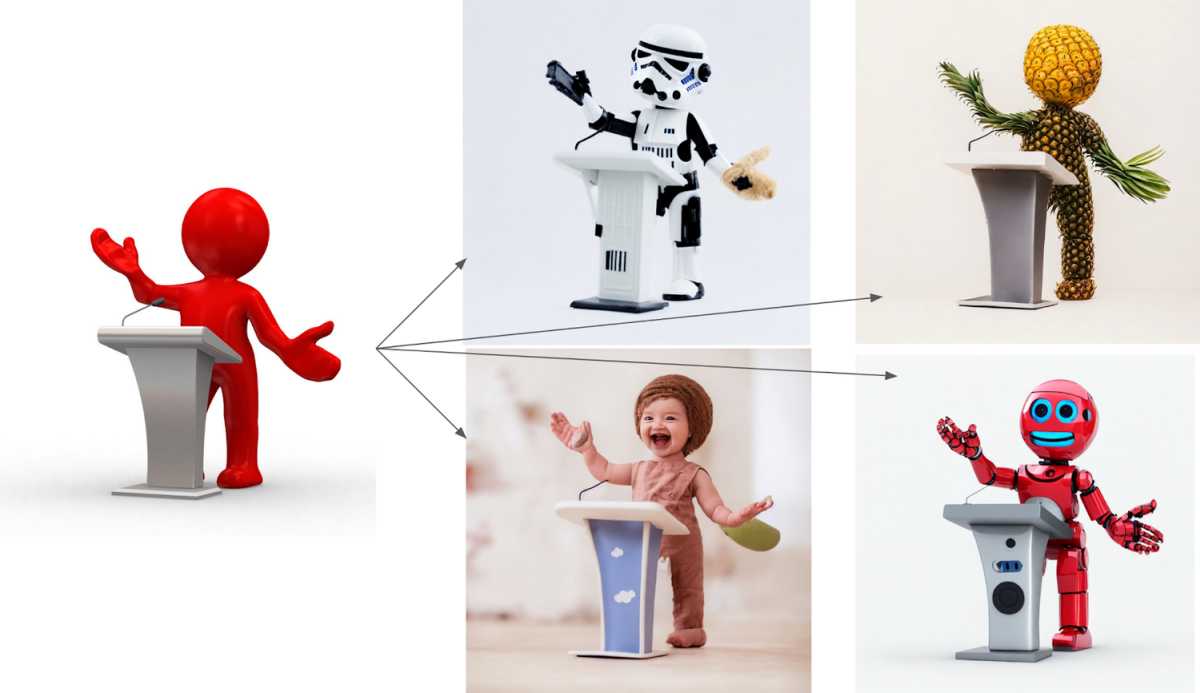

Pero además, esta versión incluye a depth2img, su nuevo modelo que tiene en cuenta la profundidad de una imagen generada por el modelo actual para generar nuevas imágenes usando tanto el texto como la información de profundidad, y cuyo ejemplo encabeza este artículo.

Y dicen que:

Depth-to-Image puede ofrecer todo tipo de nuevas aplicaciones creativas, brindando transformaciones que se ven radicalmente diferentes del original pero que aún conservan la coherencia y la profundidad de esa imagen

Y por último señalan que han actualizado su modelo de difusión de pintura guiado por texto, que facilita cambiar partes de una imagen de forma fácil y rápida con precisión.

Podremos probarlo directamente en Dream Studio dentro de pocas semanas.

Más información: Stability AI