En el mundo de la inteligencia artificial, los chatbots han evolucionado hasta convertirse en herramientas de interacción sumamente sofisticadas. Sin embargo, la reciente polémica en torno a Character.AI pone sobre la mesa un problema crítico: la seguridad de los menores en estas plataformas. A pesar de haber prometido medidas más estrictas, la compañía ha sido señalada por continuar recomendando chatbots perturbadores a adolescentes, poniendo en duda su compromiso con la protección infantil.

El problema de los chatbots basados en hechos reales y violentos

En diciembre, una investigación reveló la existencia de bots en Character.AI basados en perpetradores y víctimas de tiroteos escolares. A pesar de que la empresa aseguró haber eliminado los personajes denunciados, muchas otras versiones continuaron disponibles. Más preocupante aún, la plataforma siguió promoviendo estos bots a usuarios menores de edad mediante correos electrónicos automatizados.

Uno de estos correos, enviado a una cuenta registrada como la de un usuario de 14 años, contenía una invitación a interactuar con un chatbot llamado Vladislav Ribnikar, el nombre de una escuela en Belgrado donde, en 2023, un estudiante asesinó a diez personas. Lo más alarmante es que el bot mencionaba los nombres reales de las víctimas, recreando escenarios de la masacre.

Desde WWWhatsnew, creemos que este tipo de contenido no solo es inapropiado, sino que representa un grave riesgo para la salud mental de los menores. La facilidad con la que estos bots permanecen accesibles y son promovidos entre adolescentes expone fallos sistémicos en la moderación de la plataforma.

Promesas incumplidas y demandas en curso

Character.AI enfrenta actualmente dos demandas legales en EE.UU. por permitir interacciones inapropiadas entre menores y chatbots. En una de ellas, una madre alega que su hijo de 14 años fue inducido al suicidio tras involucrarse emocionalmente con un chatbot de la plataforma.

La empresa, en respuesta a las crecientes críticas, publicó un comunicado en diciembre titulado «Cómo Character.AI prioriza la seguridad de los adolescentes», donde prometió mejoras en la moderación y control de contenidos. Sin embargo, los recientes hallazgos ponen en duda la efectividad de estas medidas. Además, al tiempo que anunciaba su adhesión a iniciativas de bienestar digital como el Inspired Internet Pledge, Character.AI también solicitaba la desestimación de una de las demandas, argumentando que la Primera Enmienda protege su contenido, incluso si está vinculado a tragedias reales y potencialmente perjudiciales.

¿Puede Character.AI garantizar un espacio seguro para los menores?

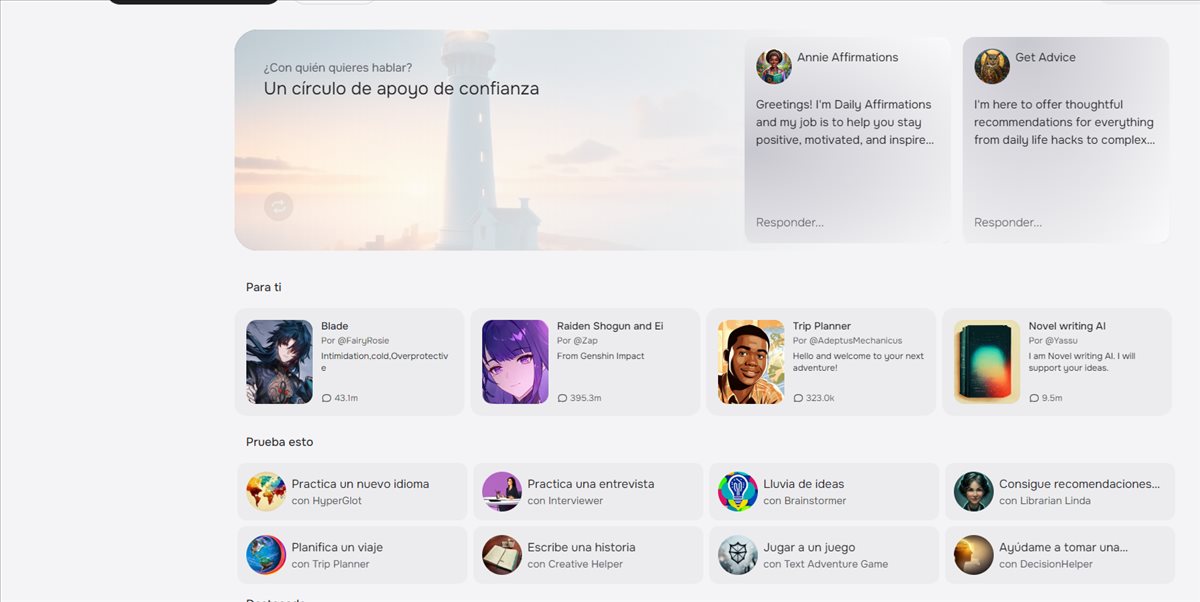

Las plataformas de IA conversacional, como Character.AI, han ganado popularidad por su capacidad para generar interacciones realistas. Sin embargo, la línea entre entretenimiento y peligro es cada vez más delgada cuando los chatbots se diseñan para recrear escenarios violentos o pueden influir negativamente en usuarios vulnerables.

Desde WWWhatsnew, consideramos que Character.AI debe demostrar con hechos sus compromisos de seguridad. No basta con eliminar perfiles después de recibir denuncias; la empresa debe implementar sistemas de filtrado robustos, auditorías constantes y transparencia en su moderación. Google, al ser uno de sus principales inversores, también tiene responsabilidad en garantizar que su tecnología no sea utilizada de manera perjudicial.

El caso de Character.AI es una advertencia sobre los peligros del marketing automatizado sin supervisión adecuada. Cuando una plataforma de IA recomienda chatbots de temática violenta a adolescentes, no solo está fallando en su deber de protección, sino que está contribuyendo activamente a un entorno digital inseguro. La regulación de estas tecnologías debe avanzar al mismo ritmo que su desarrollo, priorizando siempre la seguridad de los usuarios más vulnerables.