El mercado de los grandes modelos de lenguaje (LLMs) se ha convertido en un área muy importante para el mundo de la Inteligencia Artificial (IA). NVIDIA ha anunciado recientemente una nueva tarjeta de aceleración basada en la arquitectura Hopper, diseñada específicamente para satisfacer las necesidades de los usuarios de LLM: la H100 NVL.

La H100 NVL es una variante interesante de la tarjeta PCIe H100 de NVIDIA, que está dirigida a un mercado único: la implementación de LLM. Esta tarjeta tiene una capacidad de memoria notablemente grande, siendo 2 tarjetas PCIe H100 ya unidas. Una de las principales características de la H100 NVL es su capacidad de memoria, que es mayor que la de cualquier otro modelo de NVIDIA hasta la fecha. La combinación de dos GPU en una tarjeta ofrece un total de 188 GB de memoria HBM3, lo que significa que cada tarjeta tiene 94 GB, lo que es más que cualquier otro modelo de NVIDIA.

Especificaciones y Características de la Tarjeta

La H100 NVL ofrece un rendimiento en paridad con el modelo H100 SXM5, con 2 x 16896 núcleos CUDA FP32 y 2 x 528 núcleos Tensor. La velocidad de reloj es de 1.98 GHz, y la velocidad de la memoria es de aproximadamente 5.1 Gbps HBM3. El ancho del bus de la memoria es de 6144 bits, lo que permite una velocidad de memoria de 2 x 3.9 TB/segundo. La tarjeta H100 NVL viene con 2 x 67 TFLOPS de capacidad de vectorización FP32, y 2 x 1980 TOPS de capacidad de tensorización INT8.

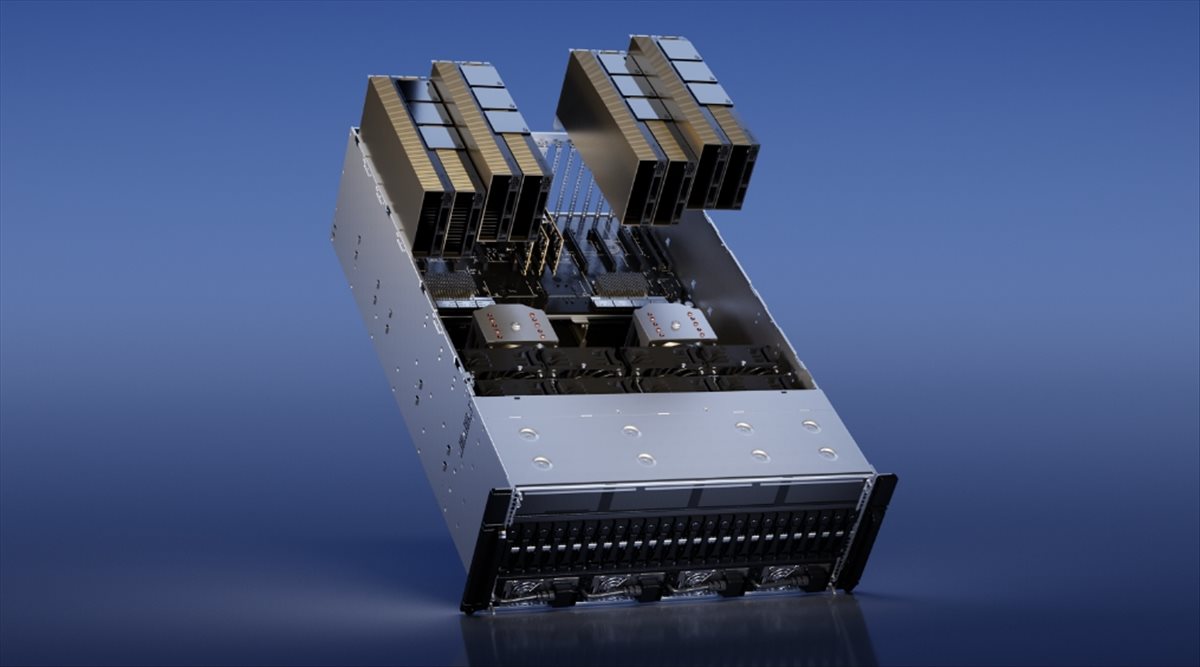

En cuanto al aspecto de la tarjeta, NVIDIA ha diseñado la H100 NVL como una tarjeta de doble GPU/tarjeta dual que se presenta al sistema host como tal. Las dos tarjetas PCIe H100 están unidas a través de tres puentes NVLink 4, lo que garantiza una conexión directa con una velocidad de 600 GB/segundo. Cada tarjeta tiene un TDP de 350W a 400W, lo que significa que la H100 NVL es una tarjeta de 700W a 800W en total.

¿Qué Hace a la H100 NVL Tan Especial?

La H100 NVL es una tarjeta de aceleración que está específicamente diseñada para satisfacer las necesidades de los usuarios de LLM. Los grandes modelos de lenguaje, como la familia GPT, requieren mucha memoria, y esto hace que los modelos de tarjetas PCIe H100 regulares no sean suficientes para sostenerlos. La H100 NVL, por otro lado, ofrece una mayor capacidad de memoria por GPU, lo que hace que sea ideal para este tipo de tareas.

La tarjeta H100 NVL es, en esencia, una versión mejorada de la tarjeta PCIe H100 de NVIDIA, con 6 pilas de memoria HBM en lugar de 5, lo que significa que la H100 NVL puede ofrecer más memoria y un mayor ancho de banda de memoria. NVIDIA ha habilitado la sexta pila de memoria HBM para la H100 NVL lo que le permite acceder a la memoria adicional que ofrece. Aunque esto puede afectar la tasa de rendimiento, NVIDIA ha señalado que la capacidad adicional de memoria es vital para las tareas de LLM y que la mayoría de los usuarios están dispuestos a pagar un precio más alto por una tarjeta de aceleración más potente.

La H100 NVL se destaca en el mercado de las tarjetas de aceleración, ya que es la tarjeta con la mayor cantidad de memoria por GPU que ha lanzado NVIDIA hasta la fecha. Además, ofrece un ancho de banda de memoria mucho mayor que cualquier otro modelo de NVIDIA. En general, la H100 NVL es una tarjeta muy prometedora para el mercado de LLM y puede convertirse en la opción preferida de muchos usuarios.

¿Cuál es el Impacto de la H100 NVL en el Mercado?

La H100 NVL es un gran paso adelante para NVIDIA, ya que les permite expandir su oferta en el mercado de LLM. La capacidad de memoria adicional y el mayor ancho de banda de memoria que ofrece esta tarjeta son un gran atractivo para los usuarios de LLM, lo que significa que NVIDIA puede capturar una parte del mercado que antes estaba fuera de su alcance.

El anuncio de la H100 NVL también es importante para la industria de la IA en general, ya que muestra cómo los fabricantes de tarjetas de aceleración están respondiendo a las necesidades específicas de los usuarios de LLM. La capacidad de procesar grandes cantidades de datos de lenguaje natural es cada vez más importante en el mundo de la IA, y la H100 NVL puede ser una pieza clave para satisfacer esta demanda.

Más información en anandtech.com