Si tenéis un archivo robots.txt complejo, uno que indique a Google los subdirectorios que no pueden ser rastreados, que bloqueen decenas de aplicaciones y que abran las puertas a otras, seguramente os interesará esta noticia.

Acaban de anunciar una nueva herramienta, disponible en Google para webmasters, que analiza con más profundidad el robots.txt de nuestro sitio, permitiendo verificar rápidamente si hay algún tipo de error que deba ser solucionado para mejorar la visibilidad de nuestro contenido en Internet.

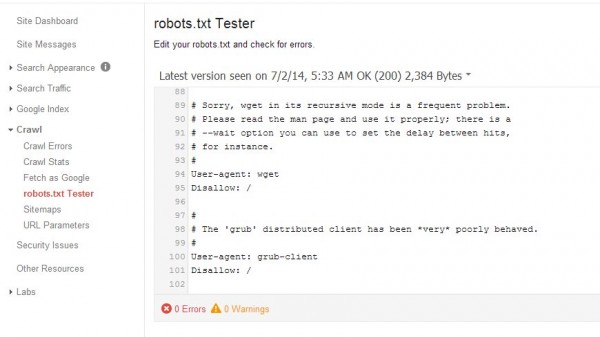

Solo tenemos que indicar el dominio deseado y ver el archivo tal y como se muestra en la imagen superior, con los errores y avisos que Google detectará en el mismo. Podemos indicar una url específica de nuestra web y ver si está o no bloqueada por Google, que destacará la linea responsable en robots.txt por dicha acción.

Podemos también comprar las acciones con una versión anterior del archivo, y recomiendan usar la herramienta que, en la misma plataforma, permite ver nuestra web según los ojos de Google, herramienta explicada en support.google.com.

Recordad que es posible también usar Mcanerin para generar este tipo de archivo especificando lo que queremos hacer, ayudando así a no perderse entre la sintaxis. Frobee.com también ofrece un recurso que nos permite validar nuestro archivo, detectando problemas en el mismo.